Redis里那些重复Key的问题怎么发现和解决,聊聊常见坑和处理办法

- 问答

- 2025-12-25 13:04:35

- 3

在Redis的使用过程中,重复Key的问题其实挺常见的,而且一旦发生,有时候排查起来会比较头疼,它不像数据库有严格的主键约束,你写入了相同的Key,Redis默认就会用新的值覆盖掉旧的值,不会给你任何错误提示,这就好比你在一个本子上记东西,后写的内容会把先写的直接盖住,如果你没注意到前面已经记过了,很可能就丢了重要信息。

怎么发现重复Key的问题?

发现这个问题,通常不是靠Redis主动告警,而是通过一些蛛丝马迹或者主动排查。

-

从业务症状反推:这是最直接的发现方式,用户投诉说“我的购物车里的商品突然不见了”或者“我的积分莫名其妙被重置了”,当你发现某个数据应该被累加(比如积分)、或者应该保持历史状态(比如订单状态流转),但却被意外覆盖或重置时,就要高度怀疑是不是有重复Key在作祟,本来应该用

INCR命令给用户积分加一,结果代码里错误地用了SET命令,直接把积分设成了一个固定值。 -

通过监控和日志发现异常模式:如果你的Redis监控做得比较好,可能会发现一些异常,某个Key的写入频率高得离谱,或者它的内存占用在某个时间点突然断崖式变化(因为旧的大对象被一个小对象覆盖了),再结合业务日志,如果发现同一条“正在写入Key=A”的日志在极短时间内被重复打印,而且来自不同的服务实例或线程,那很可能就是并发写入同一个Key的迹象。

-

使用Redis命令主动扫描:这是比较“笨”但直接的方法,如果怀疑某个模式下的Key有问题,可以用

KEYS pattern命令来列出所有匹配的Key,你觉得用户相关的Key(如user:123:profile)可能有重复,可以跑一下KEYS user:*:profile看看有没有明显不合理的重复,但要注意,KEYS命令在生产环境要慎用,因为它会阻塞其他请求,对于大数据量,可以用SCAN命令来增量迭代,避免阻塞。

-

分析RDB文件:这是一个“终极手段”,通过工具(比如

redis-rdb-tools)解析Redis的持久化RDB文件,可以统计出所有Key的信息,包括每个Key出现的次数,如果发现某个Key出现了多次,那肯定就是重复写入导致的,这种方法能发现所有潜在的问题,但操作起来比较重,一般用于定期巡检或深度故障排查。

常见的坑和处理办法

知道了怎么发现,我们再来聊聊哪些地方容易踩坑,以及怎么解决。

-

坑:Key的生成规则设计不当

- 场景:这是最常见的原因,要生成一个临时订单的Key,你用了

order:[userId],结果同一个用户同时下两个订单,后一个订单的Key就会覆盖前一个,又或者,生成Session Key的规则太简单,导致不同用户的Session ID发生碰撞(虽然概率低,但并非不可能)。 - 处理办法:设计Key时一定要保证唯一性,给Key加上足够唯一的后缀,比如使用全局唯一ID(UUID、雪花算法ID)、时间戳(精确到毫秒纳秒)或者随机数,上面的订单Key应该设计成

order:[orderId],而订单和用户的关联关系可以用另一个集合(Set)或哈希(Hash)来维护,比如user:[userId]:orders。

- 场景:这是最常见的原因,要生成一个临时订单的Key,你用了

-

坑:代码逻辑错误

- 场景:代码里粗心大意,本该更新哈希(Hash)结构里某个字段(

HSET user:123 profile.name "张三"),结果写成了直接设置整个Key(SET user:123 "张三"),把用户的其他信息全覆盖了,或者,在循环或递归调用中,不小心重复执行了SET操作。 - 处理办法:加强代码审查和单元测试,特别是对数据写入Redis的逻辑,要重点测试,使用强类型的客户端库,减少直接拼接命令字符串带来的错误风险,对于关键操作,可以考虑先用

EXISTS命令判断Key是否存在,再决定是SET还是其他更新操作,但这会牺牲一些性能。

- 场景:代码里粗心大意,本该更新哈希(Hash)结构里某个字段(

-

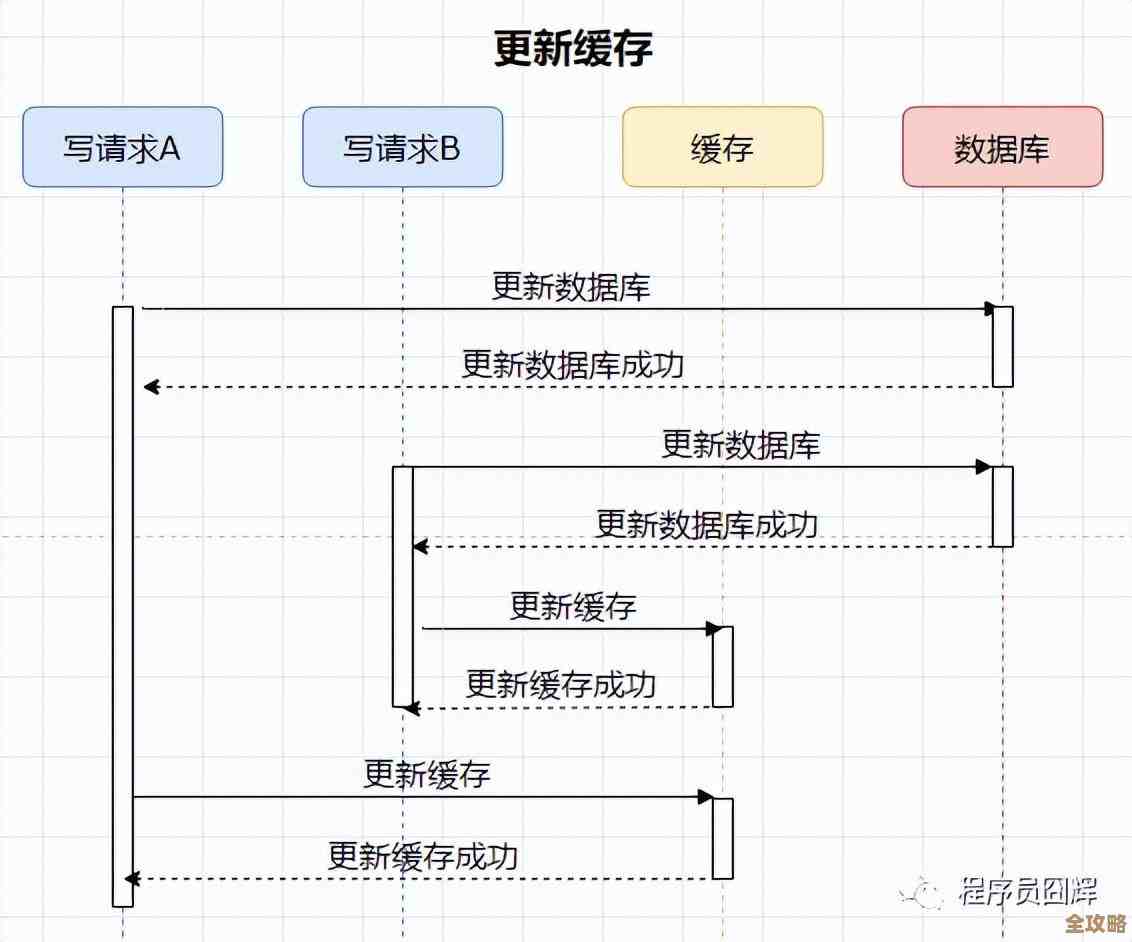

坑:分布式环境下的并发问题

- 场景:在微服务架构下,两个服务实例可能同时处理同一个业务,比如同时去初始化一个用户的缓存,如果没有锁机制,两个实例都会执行

SET user:123:cache ...,后执行的会覆盖先执行的,虽然最终数据可能一样,但造成了不必要的写入和潜在的数据不一致风险(如果两个实例计算缓存内容的逻辑有细微差别)。 - 处理办法:使用分布式锁,在准备写入某个Key之前,服务先去获取一个与之对应的锁(比如用

SETNX命令实现),拿到锁的服务才有权写入,写完后释放锁,这样可以确保同一时间只有一个写入者,Redis官方文档也推荐用Redlock算法来实现更严格的分布式锁。

- 场景:在微服务架构下,两个服务实例可能同时处理同一个业务,比如同时去初始化一个用户的缓存,如果没有锁机制,两个实例都会执行

-

坑:滥用

FLUSHDB或FLUSHALL命令- 场景:这算是一种特殊的“重复Key”问题,当你在测试环境或者生产环境误操作执行了

FLUSHDB(清空当前数据库)或FLUSHALL(清空所有数据库)后,紧接着数据恢复脚本或者应用重启又开始写入数据,如果恢复过程不是幂等的,可能会写入重复的初始数据,虽然Key本身不重复,但整个数据集的状态回到了一个重复的初始点。 - 处理办法:*严格控制`FLUSH`命令的权限**,最好在生产环境禁掉,如果必须使用,要有严格的审批和操作流程,执行清空操作后,确保数据恢复脚本是幂等的,即重复执行不会产生副作用。

- 场景:这算是一种特殊的“重复Key”问题,当你在测试环境或者生产环境误操作执行了

总结一下

解决Redis重复Key的问题,核心思想是“预防为主,排查为辅”,在设计和编码阶段,就要把Key的唯一性放在心上,避免逻辑错误,在运维阶段,通过监控、日志和定期巡检来主动发现问题,一旦出现数据被覆盖的迹象,不要慌,顺着业务逻辑和代码执行路径,结合Redis提供的排查工具,一步步定位问题根源,Redis很高效,但它不会帮你做业务逻辑的校验,这份责任需要开发者自己承担起来。

本文由雪和泽于2025-12-25发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/68178.html