云数据这么大,传统RAID还能撑得住吗,真得该换新思路了吧

- 问答

- 2025-12-26 20:30:24

- 3

关于云数据规模巨大是否意味着传统RAID技术已经无法支撑并且需要寻找新思路的问题,这个讨论在数据存储领域已经持续了相当长的一段时间,直接说结论的话,答案是:对于超大规模云数据中心的核心应用场景,传统RAID确实已经显得力不从心,业界也早已开始大规模应用新的技术和架构,但对于许多非超大规模的场景,传统RAID经过改良后,依然有其价值和生命力,我们不能简单地一刀切说它完全过时,但必须承认“换新思路”是云时代不可逆转的趋势。

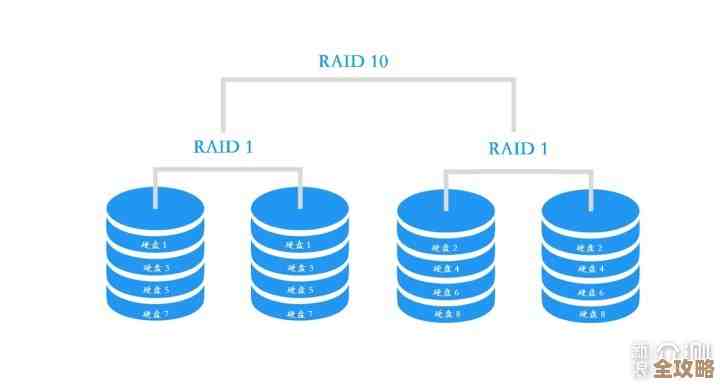

要理解这个问题,首先得明白传统RAID(独立磁盘冗余阵列)的设计初衷和云数据环境的巨大变化,RAID技术诞生于几十年前,当时硬盘(HDD)是绝对的主流,单个硬盘的容量和性能都有限,而且非常昂贵且容易故障,RAID的核心思路很巧妙:通过将多块便宜的硬盘组合起来,形成一个逻辑上的大硬盘,从而实现三个主要目标——提升性能(通过数据条带化)、增大容量、提高可靠性(通过数据冗余,比如镜像或校验),在很长一段时间里,RAID 5(单盘校验)和RAID 6(双盘校验)在容量利用率和可靠性之间取得了很好的平衡,成为企业存储系统的标准配置。

云数据时代的到来,从几个根本点上冲击了传统RAID的根基,第一点是数据量级的爆炸式增长,云服务商的数据中心动辄拥有数十万甚至上百万块硬盘,存储着EB(1EB=10亿GB)级别的数据,在这种规模下,传统RAID的恢复过程成为一个致命的瓶颈,一块10TB的硬盘在RAID 5阵列中发生故障,系统需要用剩下的硬盘重新计算出丢失的数据,并写入一块新硬盘,这个过程被称为“重建”,重建一块10TB的硬盘可能需要几十个小时,在这漫长的重建窗口期内,阵列是处于“降级”状态的,冗余保护能力下降,如果运气不好,在此期间阵列中再有第二块硬盘发生故障(这在硬盘数量巨大、使用年限相近的数据中心里,概率并不低),就会导致整个阵列的数据丢失,这种风险随着单块硬盘容量的增大而急剧升高,根据存储厂商Backblaze在2021年的一篇博文中提到的观点,大规模部署中,多盘同时故障的风险是真实存在的,这使得RAID 5基本被弃用,RAID 6也压力巨大。

第二点是硬盘技术本身的演进,固态硬盘(SSD)正在迅速取代机械硬盘成为高性能存储的首选,SSD的故障模式与HDD完全不同,HDD通常是完全的物理故障(磁头损坏、电机停转等),是“猝死”,而SSD更多是随着擦写次数的耗尽,逐渐出现读写错误或只读状态,更重要的是,SSD的性能极高,传统RAID的校验计算方式有时会成为性能瓶颈,无法充分发挥SSD的IOPS优势,SSD内部的闪存管理本身已经非常复杂,相当于在RAID之上又叠加了一层数据分布和冗余管理。

第三点是云架构对灵活性和效率的极致追求,传统RAID的组态(如RAID 5, RAID 6)一旦设定,调整起来非常困难,缺乏弹性,而云服务要求存储资源能够像水和电一样按需分配、灵活扩展,传统RAID僵化的扩容方式(比如只能通过更换更大容量硬盘或整个阵列来扩容)难以满足这种需求。

云数据中心用了什么样的“新思路”来应对呢?主要有以下几个方向:

-

软件定义的分布式存储:这是目前云计算的绝对主流,它完全摒弃了硬件RAID卡的概念,数据不再局限于一组固定的硬盘组成的RAID阵列,而是通过软件(如HDFS、Ceph、AWS的S3存储服务背后的技术)被切分成许多小块(分片),然后分散存储到数据中心成千上万台服务器中的成千上万块硬盘上,每个数据分片都会在多个不同的服务器、甚至不同的机架上保留多个副本(通常是3个副本),这种方式下,单台服务器或单块硬盘的故障,只会影响到整个数据海洋中的一滴水,系统会自动从其他副本读取数据,并在健康的节点上重新创建副本,这种方式的可靠性、可扩展性和性能都远非传统RAID可比,正如谷歌在其发布的“Spanner”等分布式数据库的论文中所阐述的,这种跨全球数据中心的冗余机制是云服务高可用的基石。

-

纠删码(Erasure Coding, EC):可以把它理解为RAID校验技术在更大尺度上的升级版,它比RAID 6(相当于EC中的一种特定配置)灵活和高效得多,可以将数据编码成10个数据块和4个校验块,并分散到14个不同的存储节点上,这样,即使同时坏掉任意4个节点,数据依然可以恢复,相比于3副本的方式,EC能用少得多的存储空间开销(例如40% vs. 200%)实现很高的可靠性,非常适合存储海量的冷数据或温数据,许多分布式存储系统都结合了多副本(用于热数据)和纠删码(用于冷数据)两种策略。

-

端到端的数据完整性校验:在超大规模系统中,静默数据损坏(数据在磁盘上悄然变质,但硬盘本身不报错)也是一个需要防范的风险,新的存储系统会在数据写入和读取的整个链路上加入更强大的校验机制(如CRC校验),确保数据的每一位都是正确的。

回到最初的问题,在超大规模云数据中心的背景下,以硬件为中心、固定组态的传统RAID确实“撑不住”了,它已经被更灵活、更可靠、扩展性更强的软件定义分布式存储架构所取代,这个“新思路”的转换早已发生并成为现实。

这并不意味着RAID技术会立刻消失,在企业的本地数据中心、中小型服务器、以及一些对性能有特殊要求的场景中,经过优化的RAID(如RAID 50, RAID 60)或类似RAID的硬件保护机制,结合SSD缓存等新技术,仍然是一种简单、高效、可靠的解决方案,特别是对于需要极低延迟的应用,本地硬件RAID仍然有优势。

不是传统RAID本身不好,而是云数据的规模和需求已经远远超出了它最初的设计目标,技术的车轮滚滚向前,在云的时代,拥抱分布式、软件定义的新思路,是应对海量数据挑战的必然选择。

本文由水靖荷于2025-12-26发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/68995.html