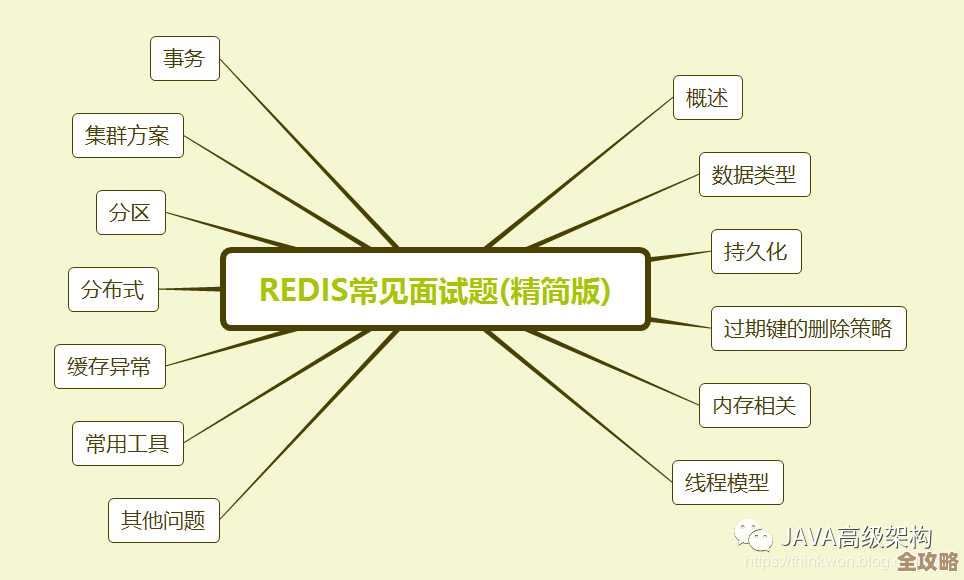

安全用Redis做离线数据访问,咋考虑它那非线程安全的问题和效率瓶颈

- 问答

- 2025-12-27 06:11:05

- 5

Redis在处理单个命令时是原子性的,并且其本身是单线程的,这意味着它在一个时间点只处理一个命令,这个设计避免了多线程环境下的锁竞争,使得Redis在多数场景下非常高效,当我们谈论“非线程安全”和“效率瓶颈”时,问题通常不出在Redis服务器本身,而出在客户端的使用方式上。

如何应对“非线程安全”的问题

这里的“非线程安全”主要指两个方面:一是客户端连接的管理,二是多个客户端(或线程)对同一数据的并发修改。

-

使用连接池,避免每个线程创建独立连接 这是最关键的实践,如果我们在一个多线程的离线数据处理程序(比如用Java的Spark作业、Python的多进程脚本)中,每个线程都自己去创建和关闭一个到Redis的连接,将会导致灾难性后果,频繁的TCP连接建立和断开本身就有巨大开销,更重要的是,Redis服务器需要为每个连接分配资源,连接数过多会压垮服务器,原生的Redis连接对象通常不是线程安全的,在一个线程中创建连接,被另一个线程使用时很可能出现数据错乱。 解决方案:使用经过良好测试的客户端连接池,在Java中可以使用Jedis Pool或Lettuce(Lettuce的连接本身是线程安全的),连接池会维护一组活跃的连接,当工作线程需要访问Redis时,它从池中“借用”一个连接,用完后归还,而不是关闭它,这样既避免了频繁创建连接的开销,也通过池的机制保证了连接被正确、隔离地使用。

-

谨慎处理并发写操作 离线数据处理常常涉及批量更新或聚合计算,如果多个任务同时尝试修改同一个Key(比如一个计数器或一个集合),虽然每个Redis命令是原子的,但一连串的命令组合在一起就不是了,先

GET一个值,在程序里计算,再SET回去,这个“读-改-写”操作序列在多线程并发时就会丢失更新。 解决方案:

- 使用原子命令:优先使用Redis提供的原子操作,比如递增用

INCR/INCRBY,而不是GET+SET;向集合添加元素用SADD;使用HSET直接设置哈希字段等,这些命令在服务器端原子完成。 - 使用Lua脚本:对于复杂的、需要多个命令才能完成的逻辑,可以使用Lua脚本,Redis会保证一个Lua脚本在执行时是原子性的,期间不会被其他命令打断,这对于需要保证数据一致性的批量操作非常有效。

- 使用WATCH/MULTI/EXEC(乐观锁):对于无法用原子命令或Lua脚本覆盖的场景,可以使用Redis的乐观锁机制,先

WATCH要监控的Key,然后执行一系列操作,最后在MULTI/EXEC事务中提交,如果在WATCH后到EXEC前,被监控的Key被其他客户端修改过,则本次EXEC会失败,程序可以决定重试或放弃,这在并发冲突不激烈的场景下是可行的。

- 使用原子命令:优先使用Redis提供的原子操作,比如递增用

如何突破“效率瓶颈”

离线数据处理的典型特点是数据量大、追求吞吐量,瓶颈可能出现在网络、Redis服务器配置、以及客户端的使用模式上。

-

网络往返时间(RTT)是最大的敌人 每个Redis命令都需要从客户端到服务器的一次网络往返,如果处理一条数据就发送一个命令(例如循环调用10万次

SET),那么绝大部分时间都花在了网络延迟上,而不是Redis处理上。 解决方案:- 管道(Pipelining):这是提升吞吐量的王牌技术,它将多个命令打包,一次性发送给Redis服务器,服务器依次处理完毕后,再将所有结果一次性返回给客户端,这极大地减少了网络RTT的次数,对于离线批量导入、批量查询场景,使用管道可以将性能提升数倍甚至数十倍,绝大多数Redis客户端都支持管道操作。

- 批量操作命令:很多命令本身就支持批量操作,比如使用

MSET/MGET一次性设置或获取多个Key,使用HSET一次设置多个字段,使用SADD一次添加多个成员,这比循环执行单个命令要高效得多。

-

优化Redis服务器配置和数据结构

- 避免大Key:单个Key对应的Value体积过大(例如一个包含百万元素的集合或哈希)会导致操作延迟增高,网络传输时间长,甚至在内存分配时出现问题,在离线处理中,应合理设计数据模型,将大Key拆分。

- 使用合适的数据结构:根据访问模式选择最合适的数据结构,比如存储对象用Hash比用多个String更节省内存和网络开销;需要快速判断成员是否存在用Set;需要排序用ZSet。

- 调整持久化策略:离线数据处理对数据持久化的要求可能与在线业务不同,如果数据可以从源系统重新生成,可以考虑在批量导入期间暂时关闭AOF持久化或使用RDB快照,以减少磁盘I/O带来的性能影响,但务必在完成后恢复持久化设置,确保数据的最终安全。

-

客户端的序列化/反序列化开销 在将复杂对象存入Redis前,需要将其序列化为字节(如JSON、MsgPack、Protobuf),这个过程的效率也会影响整体性能。 解决方案:选择高效的序列化库,在Java中,Jackson、Kryo通常比原生的Java序列化快得多,在Python中,

msgpack通常比json更快更省空间,权衡序列化/反序列化的速度和生成数据的大小。

总结一下核心思路: 安全高效地用Redis做离线数据处理,关键在于将Redis视为一个单线程的、高速的网络服务来对待,客户端方面,通过连接池解决连接管理和线程安全问题,通过管道和批量命令将网络开销降到最低,通过原子命令、Lua脚本或事务来保证数据一致性,服务器和数据结构方面,通过避免大Key、选用合适数据结构来确保Redis本身能高速运行,遵循这些实践,即使面对海量离线数据,Redis也能成为一个强大而可靠的缓存或存储组件。

(注:以上实践思路综合参考了Redis官方文档关于Pipelining、Transactions、Lua scripting的说明,以及Jedis、StackExchange.Redis等主流客户端库的最佳实践指南。)

本文由颜泰平于2025-12-27发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/69245.html