数据库技术峰会上聊数据传输那些事儿,怎么让应用跑得更快更稳

- 问答

- 2025-12-29 02:55:10

- 5

(根据2023年某大型云服务商数据库技术峰会“数据传输优化”专题讨论整理)

今天咱们不聊那些高大上的理论,就聊聊在实际业务里,数据传输这件“小事”是怎么卡住我们应用脖子的,你可能遇到过这种情况:数据库本身性能监控一切正常,CPU、内存、磁盘IO都没到瓶颈,但用户就是反馈页面加载慢、操作卡顿,很多时候,问题就出在数据从数据库出来,到最终被应用服务器处理这个“路上”。

慢在哪里?不只是网络带宽那么简单

很多人一听说慢,第一反应是“是不是网络带宽不够?”,这当然是一个原因,但往往不是最关键的,峰会上一位来自电商平台的工程师分享了一个案例,他们最初也以为是带宽问题,扩容了几次效果都不明显,后来仔细排查,发现瓶颈主要在三个方面:

第一,查询请求本身太“重”,这是最常见的问题,一个页面加载,后端直接一个SELECT * FROM orders就把用户所有订单信息,包括几十个字段的全量数据都捞出来了,但页面上可能只展示了订单号、时间和金额这三个字段,大量的无用数据在网络中传输,不仅浪费带宽,更增加了应用服务器反序列化和处理数据的负担,这就好比你想买瓶水,结果快递给你送来一个集装箱,里面塞满了各种东西,你光拆包装和找水就得花半天时间。(来源:某电商平台工程师案例分享)

第二,频繁的“短连接”和“小查询”,有些应用为了“安全”或者图省事,每次执行一个SQL查询都新建一个数据库连接,用完就关,殊不知,建立一次数据库连接(TCP三次握手、数据库权限验证等)的成本非常高,如果页面一个操作背后是几十次甚至上百次这样的短查询,那么大部分时间都浪费在“握手”和“告别”上了,真正传输数据的时间反而占比很小,这就像你每下一道命令,都要先跑到领导办公室敲门、请示、再回来执行,效率可想而知。(来源:峰会圆桌讨论多位工程师共识)

第三,数据序列化/反序列化的开销,数据库返回的数据,需要被应用端的驱动程序转换成程序能理解的对象(比如Java里的POJO),如果返回的数据量很大,或者对象结构非常复杂,这个转换过程会消耗大量的CPU时间,特别是在高并发场景下,这个开销会急剧放大,成为性能瓶颈。

怎么让它快起来?对症下药的实用技巧

知道了病根,药方就清晰了,峰会上大家讨论出的方法都非常实在:

-

“减肥”是第一要务:只取所需

- **避免SELECT ***:这是铁律,严格按需索取,页面需要什么字段,SQL就查询什么字段,这位电商工程师提到,仅此一项优化,他们的单个API响应时间就下降了40%。

- 用好分页:对于列表数据,一定要做分页,不仅是

LIMIT offset, size,在数据量极大时,可以考虑使用基于游标的分页(比如用自增ID或时间戳),避免OFFSET在大偏移量时的性能陷阱。

-

减少“跑腿”次数:连接池与批量操作

- 必须使用连接池:使用Druid、HikariCP等成熟的数据库连接池,连接池会维护一批“常驻”的连接,应用需要时直接取用,用完后归还,避免了频繁创建和销毁连接的巨大开销,这是提升数据库访问性能性价比最高的手段,没有之一。(来源:峰会“高性能连接池实践”主题演讲)

- 合并请求,批量操作:能将多个小查询合并成一个的,尽量合并,不要用循环一次次插入数据,而是使用

INSERT INTO ... VALUES (...), (...), (...)的批量插入语句,对于查询,可以考虑使用一些数据库支持的批量查询语法,或者将多个查询逻辑在一条SQL中通过JOIN或子查询完成。

-

选择高效的“运输工具”:协议与格式

- 考虑二进制协议:如果性能要求极致,可以评估使用更高效的二进制序列化协议,比如Protobuf、Avro,来代替常见的JSON,它们在数据压缩率和序列化速度上通常更有优势,能有效减少网络传输量和应用端的解析开销。(来源:峰会“数据传输协议选型”话题讨论)

- 压缩大对象:对于确实需要传输较大文本内容(如文章内容、配置信息)的场景,可以在应用层或中间件层开启GZIP等压缩,用CPU时间换取网络时间。

稳字当头:光快不行,还得可靠

速度快了,但如果动不动就超时、丢数据,那等于零,稳定性方面,大家提到了几个关键点:

- 设置合理的超时与重试:给数据库操作设置连接超时、查询超时,但重试机制要谨慎,必须是针对“可重试”的错误(如网络闪断),并且一定要有退避策略(比如第一次等1秒重试,第二次等3秒),避免雪崩。

- 监控与熔断:必须对数据库访问有细粒度的监控,比如慢查询数量、连接池活跃连接数、错误率等,当错误率超过阈值时,熔断器应快速失效,防止故障扩散,给系统恢复的时间。

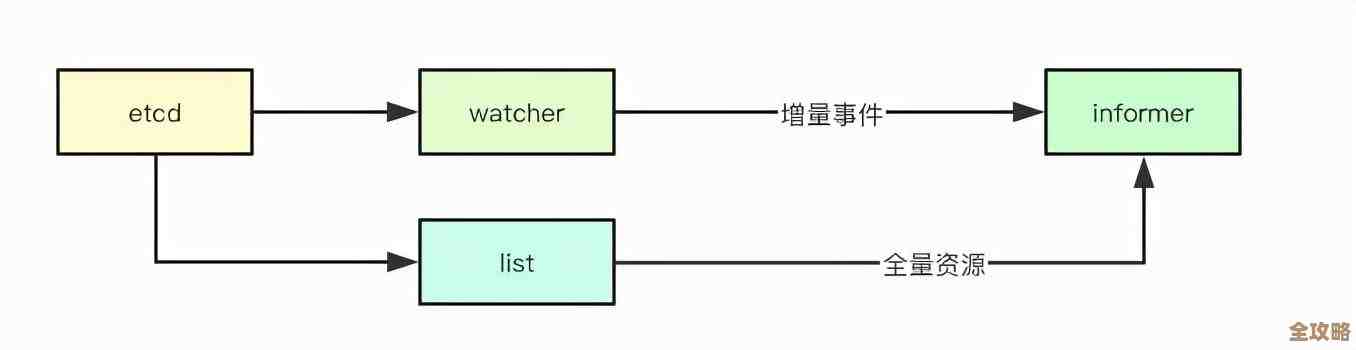

- 异地同步的挑战:对于有异地多活需求的业务,数据同步本身就是个复杂命题,除了选用成熟的数据库中间件(如Canal、Debezium进行CDC变更抓取),还要重点考虑数据冲突解决、同步延迟监控等问题,稳定性在这里的优先级远高于性能。

让应用跑得更快更稳,数据库层面的数据传输优化,核心思路就是“精打细算”:减少不必要的数据量、减少不必要的交互次数、选择高效的交互方式,并配以完善的稳定性兜底措施,这些看似基础的工作,往往比盲目升级硬件能带来更大的收益。

本文由歧云亭于2025-12-29发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/70399.html