ORA-02738报错写入字节数不对,Oracle故障远程帮忙修复方案分享

- 问答

- 2025-12-30 06:48:57

- 2

ORA-02738报错写入字节数不对,Oracle故障远程帮忙修复方案分享

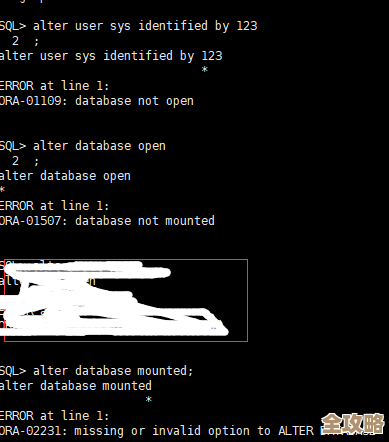

前段时间,我们团队在处理一个客户的紧急求助时,遇到了一个比较典型的Oracle数据库问题,客户那边的一个关键业务系统在夜间执行某个特定的数据处理程序时,突然失败了,应用程序日志里明确地指向了一个数据库错误:ORA-02738,这个错误后面还跟着一段描述,大概意思是“写入的字节数与请求的字节数不一致”,客户自己的运维人员尝试重启了应用和数据库,但问题依旧,只要一跑那个程序就报错,于是通过远程方式联系了我们寻求帮助。

我们得弄明白ORA-02738这个错误到底在说什么,根据Oracle官方的错误代码手册(来源:Oracle Database Error Messages, 11g Release 2),ORA-02738的解释是:“message number or string literal exceeds maximum size”,这个解释乍一看和我们遇到的“写入字节数不对”好像不太一样,但这正说明了Oracle错误的复杂性,有时底层原因和表面提示可能存在差异,更深入地去查证(来源:My Oracle Support官方支持文档),我们发现ORA-02738在某些上下文中,特别是在使用PL/SQL中的UTL_FILE包向操作系统写入文件时,确实会表现为“写入的字节数”相关问题,它本质上是说,程序尝试写入的数据量,与它事先声明的或者文件系统允许的单次操作数据量不匹配。

基于这个理解,我们开始远程排查,由于是远程协助,我们无法直接接触客户的服务器,所有操作都需要在客户的配合下,通过屏幕共享和指令指导来完成,我们的排查思路大致分成了几个步骤:

第一步,锁定问题发生的精确位置,我们让客户提供了完整的应用程序错误日志和数据库的跟踪文件,通过仔细比对,我们确认了错误确实发生在数据库内部一个存储过程中,这个存储过程使用了UTL_FILE.PUT_RAW这个函数来向服务器上的一个目录写入二进制数据,报错的行号也被定位了,这就把问题范围从整个应用缩小到了一个具体的数据库对象和一次具体的写文件操作上。

第二步,分析问题代码,我们让客户将出问题的存储过程脚本发给我们审查,我们发现,在调用UTL_FILE.PUT_RAW函数时,程序先计算了一个数据块的长度,然后将这个长度值和数据块本身作为参数传给函数,表面上看代码逻辑没有问题,我们注意到一个细节:这个数据块的内容是动态生成的,其大小在某些极端业务场景下可能会非常大。

第三步,检查数据库配置和操作系统环境,我们指导客户检查了以下几个关键点:

- UTL_FILE_DIR参数:确认数据库参数

UTL_FILE_DIR设置的目录路径是否存在,数据库进程是否有足够的读写权限,客户检查后确认权限正常。 - 操作系统磁盘空间:确认目标磁盘分区是否有足够的剩余空间,客户检查后确认空间充足。

- 文件系统限制:我们怀疑是否是单个文件的大小限制或单次写入的数据块大小超出了某个阈值,由于客户使用的是常见的Linux操作系统,我们让他检查了文件系统的块大小(block size)以及是否有用户级的文件大小限制(使用

ulimit -a命令查看),检查结果也没有发现明显异常。

第四步,深入问题核心——数据块大小,既然环境和权限都正常,问题又明确指向“写入字节数不对”,我们再次把焦点放回数据本身,我们让客户在存储过程中添加了更详细的调试信息,在调用UTL_FILE.PUT_RAW之前,将准备写入的数据块长度打印到另一张日志表里,我们也检查了UTL_FILE.PUT_RAW函数本身对输入参数的要求。

这一查,找到了根本原因,原来,这个存储过程在极少数情况下生成的数据块异常巨大,远远超过了UTL_FILE.PUT_RAW函数单个调用所能处理的上限(这个上限通常与Oracle的数据库块大小和内部缓冲区有关),程序逻辑是希望一次性地将整个大数据块写入文件,但函数处理不了这么大的数据量,于是就抛出了ORA-02738错误,提示写入的字节数和请求的字节数对不上。

找到了根因,解决方案就清晰了,我们并没有修改复杂的数据库参数或者操作系统设置,而是直接对存储过程的逻辑进行了优化,我们的修复方案是:将原来单次调用UTL_FILE.PUT_RAW写入整个大数据包,改为循环写入,也就是把大数据包分割成多个小块,每次只写入一个大小合理的、确保不会超出限制的小数据块,通过一个循环直到把所有数据写完。

我们远程指导客户修改了存储过程的代码,进行了严格的测试,首先在测试环境模拟了那种会产生超大数据块的业务场景,确认修改后的程序能够正常运行,在客户的配合下,在一个业务低峰期,将修改后的存储过程部署到生产数据库,部署完成后,再次运行那个之前失败的数据处理程序,运行顺利,没有再出现ORA-02738错误,问题得到了彻底解决。

回顾这次远程修复经历,ORA-02738这个错误虽然不常见,但给我们提了个醒:在处理文件读写,特别是使用UTL_FILE这类包时,一定要充分考虑数据大小的边界情况,不能假设每次写入的数据量都是常规大小的,编程时采用“分而治之”的思路,进行分批读写,是提高程序健壮性的一个好习惯,这次故障的解决,主要依靠的是对错误信息的准确解读、循序渐进的排查方法,以及最终对业务代码逻辑的针对性优化。

本文由盘雅霜于2025-12-30发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/71116.html