用Python搞定那些网页表格数据库数据爬取,教你一步步抓取不求人

- 问答

- 2025-12-30 22:43:44

- 3

综合自网络爬虫入门教程及常见问题解答)

你是不是经常在网上看到一些有用的数据,它们整整齐齐地排列在网页的表格里,比如股票价格、天气数据、公司名录等等?你是不是很想把这些数据弄到自己的电脑上,存成Excel或者直接用来分析,但发现网站不提供下载按钮,一个一个复制又太麻烦?别着急,今天就用最直白的大白话,教你用Python这个万能工具,像探囊取物一样把这些表格数据抓下来,彻底告别求人。

咱们得把家伙事儿准备好,你需要安装一个叫Python的程序,去Python官网下载一个就行,安装的时候记得勾选“Add Python to PATH”,这样后面用起来才方便,装好Python之后,要请出两位“得力干将”:requests和pandas,怎么请呢?打开你的电脑命令行(Windows叫CMD或者PowerShell,Mac叫终端),输入下面两行命令,然后回车:

pip install requests

pip install pandas简单解释一下,requests库是用来跟网页打招呼、要内容的,相当于你的“网络信使”。pandas库是专门处理表格数据的超级高手,能把乱糟糟的数据变得规规矩矩。

家伙事儿齐了,现在开始干活,抓取网页表格数据,最最最省心的办法,是直接用pandas的一个隐藏技能,很多网页上的表格,其本质是一种叫<table>的HTML代码写的,pandas可以智能地识别并抓取它们。

第一步,找到目标,打开你想要的网页,新浪财经”的某个股票历史数据页面,在网页上右键,选择“检查”或者“审查元素”,会打开一个满是代码的窗口,你需要用眼睛扫一下,看看你想抓的那个表格在代码里长什么样,确认它确实是用<table>标签包着的,大部分正规网站的数据表格都是。

第二步,抄下地址,复制浏览器顶部的网址(URL)。

第三步,写几句简单的“咒语”(代码),打开任何一个能写文本的软件,比如记事本,然后输入下面的代码:

import pandas as pd

# 把刚才复制的网址,替换掉下面引号里的内容

url = '这里粘贴你的网址'

# 这一行是核心魔法:让pandas去读取网页上所有的表格

tables = pd.read_html(url)

# 网页上可能不止一个表格,所以pandas会返回一个列表,我们通常取第一个。

df = tables[0]

# 把抓下来的数据保存成Excel文件,这样你就可以用Excel打开了

df.to_excel('我抓取的数据.xlsx', index=False)

print('搞定!数据已经保存为‘我抓取的数据.xlsx’')

把上面代码里的网址替换成你的目标网址,然后把这段代码保存成一个文件,名字叫抓表格.py,注意后缀必须是.py。

第四步,运行魔法,打开命令行,切换到你这个抓表格.py文件所在的文件夹(比如文件在桌面,就在命令行输入cd Desktop),然后输入python 抓表格.py并回车,稍等片刻,你就会看到“搞定!”的提示,同时文件夹里会多出一个Excel文件,打开它,你想要的数据就在里面了!

这个方法能搞定大约六七成的网页表格,超级简单,但有时候你会遇到一些“顽固分子”。

网站需要登录怎么办? 有些表格在你登录账号后才能看到,这时候,你的“网络信使”requests就不能光秃秃地去要数据了,得带上你的“身份凭证”(Cookie),操作步骤会复杂一点:

- 先用浏览器登录那个网站。

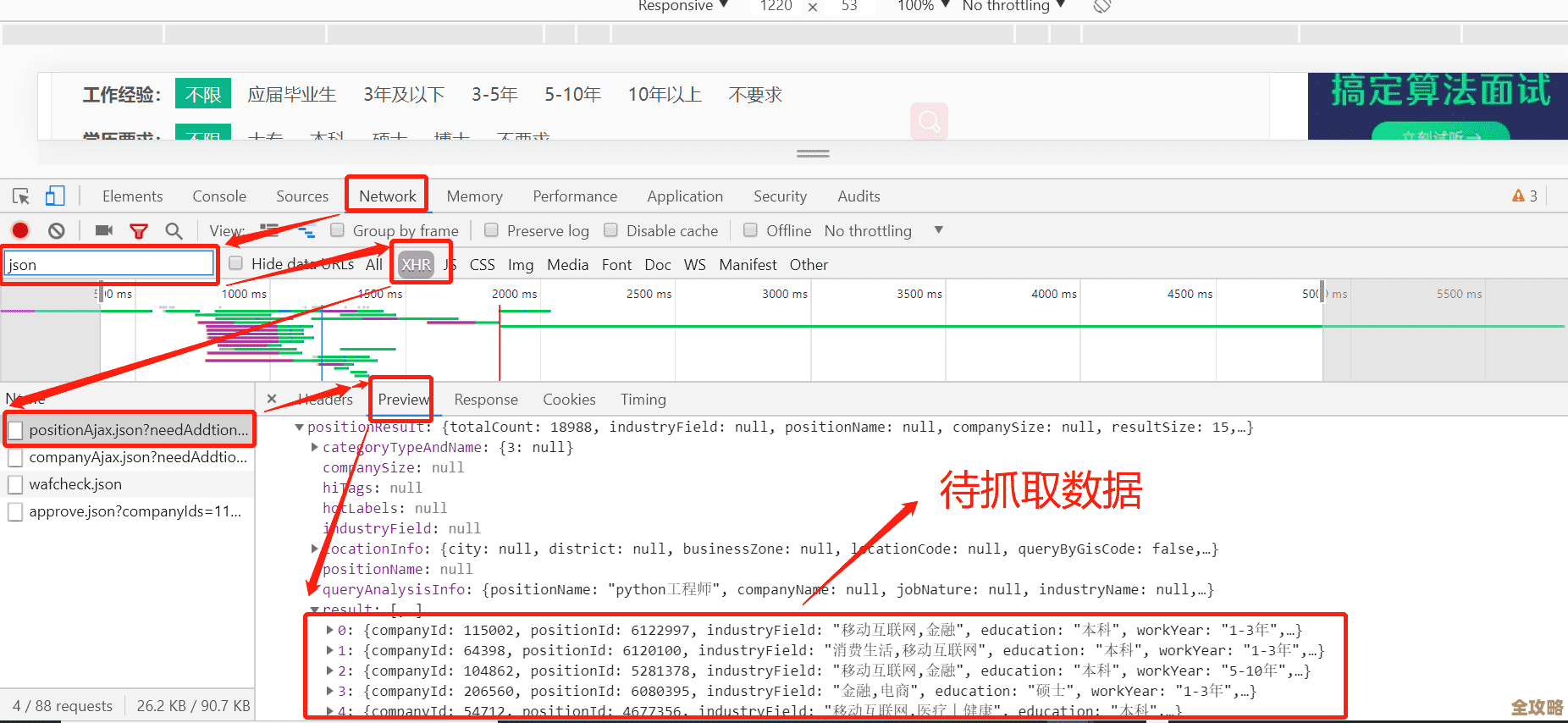

- 按F12打开开发者工具,切换到“Network”(网络)标签。

- 刷新一下网页,在Network里找到网页本身的那个请求,点击它,在右边找到“Headers”(头信息),往下拉,找到一大串叫“Cookie”的东西,复制下来。

- 修改你的代码,让requests带着Cookie去请求:

import pandas as pd

import requests

url = '你的网址'

headers = {

'Cookie': '你复制的那一大长串Cookie'

}

# 用requests带着Cookie去获取网页内容

response = requests.get(url, headers=headers)

# 用pandas解析获取到的网页文本内容

tables = pd.read_html(response.text)

df = tables[0]

df.to_excel('需要登录的数据.xlsx', index=False)

表格是“懒加载”的怎么办?

这是最讨厌的情况,你发现网页上的表格是慢慢刷出来的,或者需要你点击“加载更多”才会出现,这种表格通常不是直接写在最初的网页代码里的,而是通过JavaScript脚本后来动态加载的,这时候,上面的方法就失效了,因为pandasread_html读的是静态HTML。

对付这种“狡猾”的表格,我们就得请出终极武器——Selenium,它可以模拟一个真正的浏览器,点击、滚动、等待,等表格完全加载出来后再抓取,用Selenium稍微复杂一些,需要安装浏览器驱动(比如ChromeDriver),但思路是一样的:模拟人的操作,拿到最终呈现的完整网页源代码,然后再用pd.read_html来解析。

安装Selenium:pip install selenium

还需要下载一个和你Chrome浏览器版本匹配的ChromeDriver,放在Python的安装目录下。

示例代码大概长这样:

from selenium import webdriver

import pandas as pd

# 启动一个浏览器

driver = webdriver.Chrome()

driver.get('你的网址')

# 这里可能需要加一些等待时间,或者模拟点击“加载更多”的代码

# ... (具体操作要看网页结构)

# 获取渲染后的完整网页源码

html_content = driver.page_source

# 关掉浏览器

driver.quit()

# 再用老方法解析

tables = pd.read_html(html_content)

df = tables[0]

df.to_excel('懒加载的数据.xlsx', index=False)

好了,从最简单的“一招鲜”到对付复杂情况的方法,我都告诉你了,核心思想就是:先试试最简单的pd.read_html,不行就加Cookie,再不行就上Selenium模拟真人操作,多动手试几次,你就能发现,爬取网页表格数据真的不难,从此数据抓取再也不求人!实践是最好的老师,找个简单的网站开始你的第一次尝试吧!

本文由凤伟才于2025-12-30发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/71529.html