云存储架构到底能帮DevOps解决哪些头疼的问题,真有那么神奇吗?

- 问答

- 2025-12-31 06:54:52

- 9

(引用来源:ThoughtWorks技术雷达、AWS官方文档、Google Cloud架构框架、多位资深DevOps工程师的实践经验分享)

云存储架构对于DevOps来说,确实不是那种能点石成金的“魔法”,但它更像是一套精良的“多功能瑞士军刀”,专门用来解决那些在传统IT环境中让开发者和运维人员抓狂的经典难题,它并没有让问题消失,而是通过提供一种更灵活、更强大、更自动化的基础设置,让团队有能力用一种全新的、更高效的方式去应对这些问题,下面我们就来具体看看它到底解决了哪些头疼事。

第一个大难题就是“环境不一致”这个老妖怪,在以前,开发人员在自己笔记本电脑上写代码,用的是Mac系统,装的是特定版本的数据库和依赖包,测试通过后美滋滋,结果代码一放到测试环境,测试环境是CentOS,数据库版本低了一点,某个系统库文件缺失,程序立马就趴窝了,运维团队和开发团队就开始互相“甩锅”,排查问题能花上大半天,云存储架构怎么解决这个呢?它提倡的是“基础设施即代码”,简单说,就是不再用手工去一台台服务器上配置环境了,而是用写脚本的方式(比如Terraform、AWS CloudFormation),把服务器、网络、存储空间的配置都定义清楚,需要部署一个新环境时,直接运行这个脚本,云平台就会自动、精确地创建出一个和脚本描述一模一样的环境,这样一来,从开发到测试再到生产,所有环境的基础设施配置几乎完全一致,“在我这儿是好的”这种问题就大大减少了。

第二个头疼的问题是“容量规划像猜谜”,一个应用上线前,老板问需要多少存储空间,多少服务器?谁也说不准,估少了,业务高峰期网站卡顿甚至崩溃,用户体验极差,运维半夜被报警电话叫醒;估多了,平时大部分时间资源闲置,浪费大量成本,云存储的核心特性之一就是“弹性伸缩”,它允许你根据实际需求动态调整资源,你可以设置一个规则:当服务器的CPU使用率连续5分钟超过70%,就自动增加一台服务器来分担压力;当使用率降下来后,再自动关闭多余的服务器,存储空间也一样,几乎是“按需分配”,你用1G就付1G的钱,用1T就付1T的钱,再也不用为了一年中可能只有几次的流量高峰而常年预备着昂贵的硬件设备,这让DevOps团队既能保障系统的稳定性,又能极大地优化成本,不用再玩“猜谜游戏”。

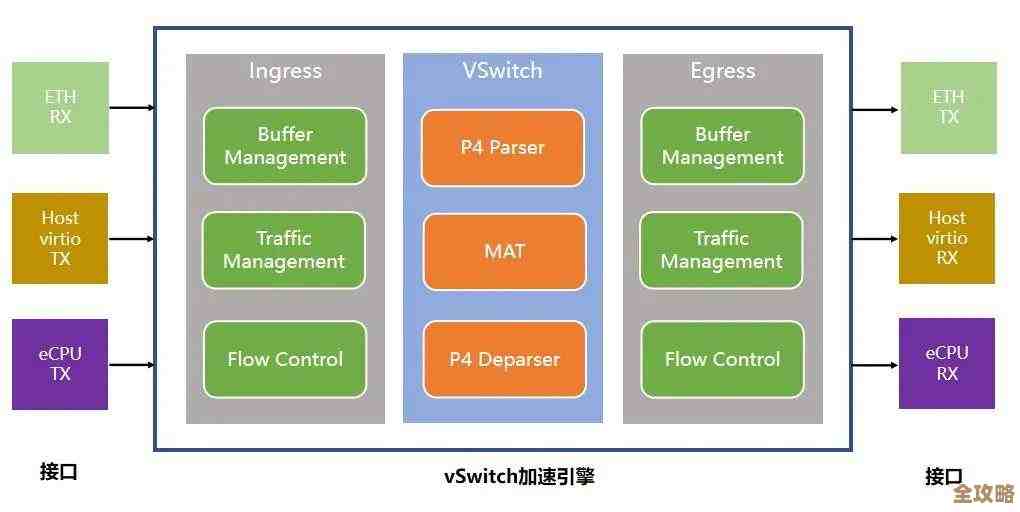

第三个痛点是部署和扩展的“笨重感”,传统架构下,要给应用新版本准备一套隔离的测试环境,可能得等运维部门采购服务器、上架、装系统、配置网络,周期长达几周,而在云上,借助前面提到的“基础设施即代码”,几分钟就能复制出一套和生产环境高度相似的临时环境用于测试,更重要的是,云存储服务本身(比如对象存储如AWS S3,Azure Blob Storage)就是为大规模和高并发而生的,你的应用如果突然因为一个热点事件面临百倍千倍的访问量,云存储服务在设计上就已经具备了处理这种流量的能力,DevOps团队无需关心后台到底加了多少台机器、磁盘是怎么做冗余的,他们只需要专注于让自己的应用能够调用这些服务即可,这极大地降低了实现高可用性和可扩展性的技术门槛和精力消耗。

第四个让DevOps团队解放双手的是“数据备份与灾难恢复”的自动化,在传统机房,定期的数据备份是个体力活,要检查磁带机,要人工更换磁带,还要把磁带运到异地保管,真出了大事,恢复数据的过程更是漫长且充满不确定性,云存储服务天然具备高持久性(通常通过多副本冗余存储实现),数据丢失的风险极低,利用云上的快照、复制等功能,可以轻松实现跨地域的数据备份,你可以设置策略,每天凌晨自动为数据库磁盘打一个快照,并自动复制到另一个城市的云数据中心,一旦主数据中心发生故障,可以快速利用备份的数据在另一个地区恢复服务,这套流程完全可以自动化,无需人工干预,让DevOps团队能睡个安稳觉。

回到问题本身,云存储架构神奇吗?它不提供一键解决所有问题的银弹,但它提供的这种按需索取、弹性伸缩、全球部署、高可靠且可通过代码管理的基础能力,实实在在地将DevOps从大量繁琐、重复、易出错的基础设施管理工作中解放了出来,它让团队能够更快速、更频繁、更可靠地交付软件,从而真正聚焦于为业务创造价值本身,这才是它对于DevOps而言,最根本的“神奇”之处。

本文由度秀梅于2025-12-31发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/71738.html