SparkStreaming和Kafka一起用时那些坑和怎么破的分享

- 问答

- 2025-12-31 11:01:35

- 4

这个分享主要来源于多个实际项目中的经验总结,以及Apache Spark官方文档和社区讨论中反复被提及的重点难点。

数据丢失的坑与对策

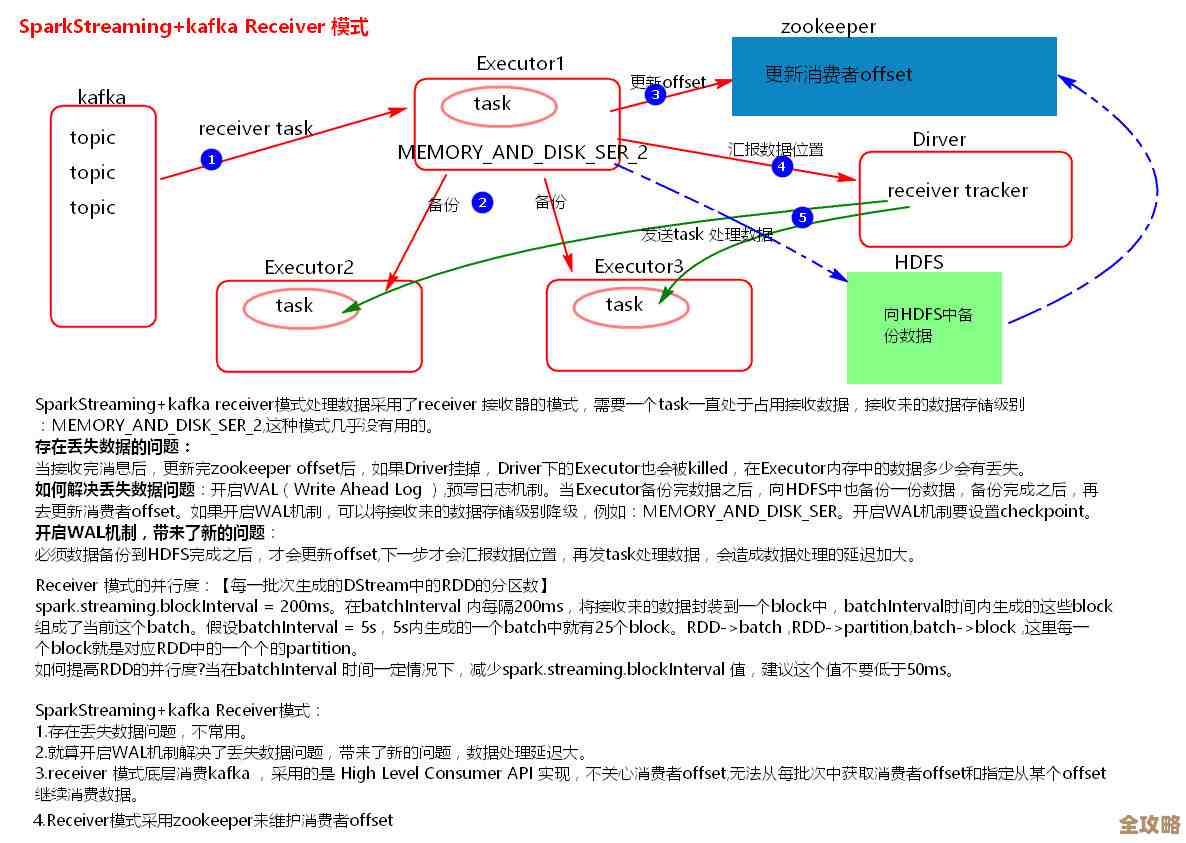

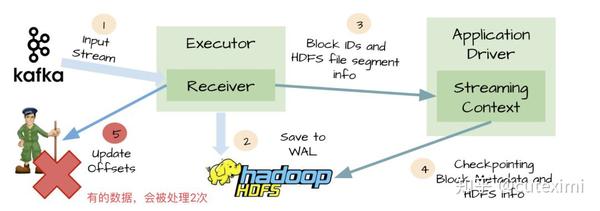

这是最严重也最让人头疼的问题,场景通常是:Spark Streaming程序处理了一部分Kafka的数据,但还没来得及向Kafka“汇报”说这些数据我已经处理完了(即提交偏移量),程序就因为各种原因崩溃或重启了,当程序恢复后,如果没做特殊处理,它可能会从Kafka里最后一次“汇报”的位置开始消费,那么崩溃前已经处理过但没来得及“汇报”的那部分数据就永远丢失了。

怎么破?关键在于“手动管理偏移量”和“保证处理与提交的原子性”。

- 放弃自动提交:要关闭Spark Streaming默认的Kafka自动提交偏移量的功能,这个自动提交是定时发生的,它不知道你的数据处理到哪一步了,所以不可靠。

- 手动记录偏移量:我们需要把读取到的Kafka数据的“进度条”(也就是偏移量)自己存起来,可以存到任何可靠的外部存储系统中,比如ZooKeeper、Redis、HBase或者关系型数据库(MySQL/PostgreSQL),这样,即使程序挂掉,重启后我们也能从存储里读出上次处理到的准确位置,然后从那里继续消费。

- 实现原子性操作:最理想的状况是,我们把“处理数据”和“保存偏移量”这两个操作变成一个“要么都成功,要么都失败”的原子操作,但这在分布式系统中很难完美实现,一个广泛使用的、比较稳妥的实践是:

- 先将这批数据处理好,将结果持久化到目的地(比如HDFS、数据库)。

- 再将这批数据对应的偏移量提交到外部存储。

- 这个顺序很重要,如果先提交偏移量,但数据处理失败了,数据就会丢失,反过来,如果数据处理成功但偏移量提交失败,顶多是少量数据被重复处理一次(下一节会讲如何应对重复),但绝不会丢。

- 为了进一步保证一致性,甚至可以将处理结果和偏移量放在同一个数据库事务中提交,但这会增加系统复杂性。“先存结果,后存偏移量”的顺序已经能解决绝大部分丢失问题。

数据重复的坑与对策

数据重复通常是在“至少一次”语义下不可避免的副产品,当我们成功处理了数据,但在提交偏移量时,程序可能因为网络闪断、重启等原因导致提交失败,下次重启时,程序会从上次成功提交的位置重新消费,那部分已经处理过的数据就会被再处理一次。

怎么破?思路从“防止重复”转向“接受重复,但实现幂等性”。

- 接受现实:在分布式环境下,要想完全避免数据重复,成本极高且可能影响性能,更务实的做法是假设重复会发生,然后让我们的系统能够“淡定”地处理重复数据。

- 实现幂等性写入:所谓幂等性,就是无论同一个操作执行多少次,结果都跟只执行一次一样,这是解决重复问题的银弹。

- 数据库层面:可以使用

INSERT ... ON DUPLICATE KEY UPDATE这样的语法,或者利用唯一键约束(Unique Key)/主键(Primary Key),当插入重复数据时,数据库会自动忽略或更新,而不会报错导致流程中断。 - 业务逻辑层面:在写入结果之前,先根据数据的唯一标识(比如订单ID、用户ID+时间戳)去查询一下目标存储是否已经存在该记录,如果存在,就跳过或覆盖。

- 使用支持幂等性的中间件:比如某些消息队列或流处理引擎本身提供幂等性Producer。

- 数据库层面:可以使用

性能与并行度的坑与对策

有时候会发现Spark Streaming处理Kafka数据的速度跟不上数据产生的速度,造成任务堆积和延迟。

怎么破?核心是增加并行度。

- Kafka分区数与Spark分区数:Spark Streaming消费Kafka时,一个Kafka分区通常会被映射给一个Spark的Executor中的一个任务(Task)来处理。Kafka的Topic的分区数量,直接决定了Spark Streaming消费该Topic的最大并行度,如果你的Topic只有2个分区,那么无论你给Spark分配了多少个CPU核心,同时处理数据的Task最多也只有2个。

- 增加分区数:如果遇到性能瓶颈,首要的检查点和优化手段就是增加Kafka Topic的分区数,并相应地增加Spark Streaming应用的Executor数量和每个Executor的CPU核心数,让更多的计算资源可以同时工作,需要注意的是,增加Kafka分区数是一个需要谨慎评估的操作,最好在创建Topic时就规划好。

监控与调试的坑与对策

流处理应用是7x24小时运行的,出了问题如果不能快速发现和定位,影响会很大。

怎么破?建立完善的监控体系。

- 关键指标监控:

- 处理延迟:监控每个批次(Batch)的处理时间是否超过批间隔时间,如果持续超过,说明处理速度跟不上,需要扩容或优化。

- 调度延迟:监控批次在队列中等待的时间,如果过长,可能表示资源不足。

- 消费滞后量:这是最重要的指标之一,它表示最新产生的Kafka数据与当前Spark Streaming正在处理的数据之间的差距( lag ),如果滞后量持续增长,说明消费者落后于生产者,必须立即干预,Kafka本身提供了工具可以查看这个值,Spark的监控界面也能展示。

- 日志记录:在关键步骤(如开始处理一批数据、成功提交偏移量)打上详细的日志,并记录偏移量范围,这对于事后排查问题至关重要。

总结一下,与Kafka一起使用Spark Streaming,要想稳定可靠,核心就是三件事:第一,通过手动管理偏移量来防止数据丢失;第二,通过设计幂等性逻辑来容忍数据重复;第三,通过合理设置分区和资源来保证处理性能。 配上一套好的监控系统,就像给流处理应用装上了仪表盘和报警器,能做到心中有数,遇事不慌。

本文由革姣丽于2025-12-31发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/71844.html