一次性批量写入redis数据,怎么高效又省事儿的操作分享

- 问答

- 2026-01-02 11:13:53

- 3

说到一次性往Redis里灌进去大批量数据,怎么才能又快又省劲儿呢?这事儿其实就像你要搬一大堆书进一个新家,一本一本地跑肯定累死个人,但要是用上几个结实的大纸箱,一次能扛一箱,那效率就天上地下了,今天聊的就是怎么给Redis数据打包和搬运的方法。

最直接但也是最不推荐的办法,就是一条一条命令地发,比如你用Python的redis库,写个for循环,每次循环执行一次set命令,这种方法为啥不行呢?主要卡在两个地方,一个是网络开销太大了,你每发一条命令,Redis服务器都得给你回一个“OK”,这来来回回的时间,比命令本身执行的时间长多了,另一个是Redis本身是单线程处理命令的,你一下子几万几十万个请求涌过去,它虽然处理得快,但光忙着接电话了,也会影响它处理其他操作的性能,数据量小的时候感觉不出来,数据一多,这种方式就特别慢,效率极低。

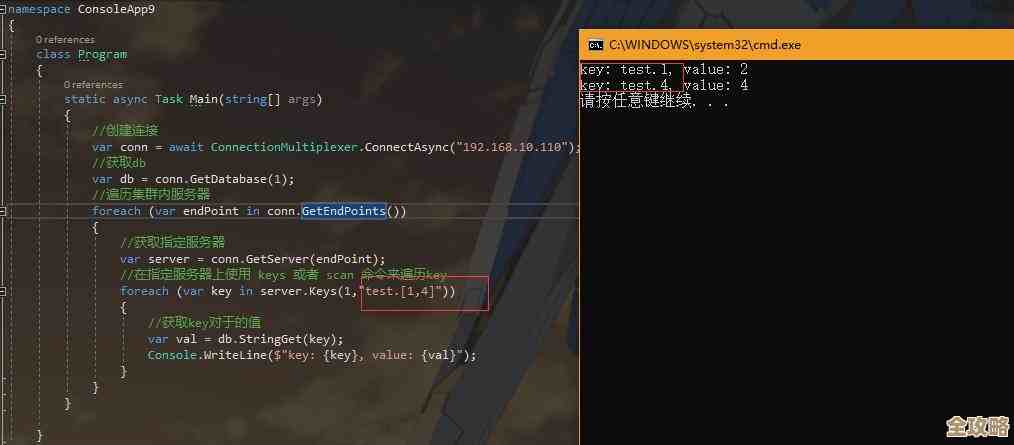

那怎么改进呢?Redis官方其实给了我们一个非常给力的工具,叫做管道,也就是pipeline,这个方法就像是把那些零散的命令装进一个管道里,一次性把它们全部发送到Redis服务器,然后服务器一口气处理完,再把所有的结果打包一次性返回给你,这样就极大地减少了网络往返的次数,比如你还是有一万条数据要写,用管道可能只需要来回通信几十次就搞定了,而不是一万次,根据Redis官方文档里的说明,使用管道可以带来非常显著的性能提升,有时候效率能提高几十倍甚至上百倍,像Python里的redis-py库,使用pipeline特别简单,就是用pipeline()方法创建一个管道对象,然后把你的set命令都塞进去,最后用execute()一起执行就行了,这是最常用、也最高效的常规手段,90%以上的批量操作场景用它就足够了。

管道虽然好,但它还是有个特点:它是一批命令一起发过去,Redis服务器必须按顺序处理完这一批,中间如果有一个命令出错了,它不会停下来,会继续处理后面的,但你需要等所有命令都处理完,才能在返回的结果里看到哪个出了错,对于只是单纯地写入数据,不关心中间结果的场景,这完全没问题。

那有没有比管道还要猛的方法呢?有的,那就是直接“送原材料”,让Redis自己“下锅炒菜”,这就是Redis提供的MSET命令,这个命令允许你在一条命令里,直接设置多个key-value对,它的效率比管道理论上还要高,因为管道可能还是一批命令(比如10个SET命令)打包,而MSET本身就是一条命令,它有个很大的限制,就是它只能用来设置简单的字符串键值对,如果你要写入的数据带有过期时间,或者你是要写入哈希、列表这些复杂的数据结构,MSET就无能为力了,所以它的适用场景比较单一,但在适合的场景下,它是非常快的。

还有一个“终极大招”,适用于极端情况,比如你需要迁移一个特别巨大的数据量,或者需要初始化一个全新的Redis数据库,这个方法不是通过普通的Redis命令,而是直接生成Redis协议格式的文件,然后把这个文件“喂”给Redis,这个工具叫redis-cli --pipe,它的原理是绕过Redis的命令请求解析环节,直接发送最终的数据流,所以速度是极限的快,这个方法操作起来比较麻烦,你需要先把你的数据转换成一种特定的格式(就是Redis协议本身的格式),然后通过管道符传递给redis-cli,这个方法在Redis官方的文档里也有详细说明,通常是在数据迁移工具(比如redis-dump)或者需要从其他数据源直接生成巨大数据文件时使用,对于日常开发中的批量写入,一般用不到这么重型的武器。

总结一下,怎么选呢?如果你是偶尔在程序里需要批量写一批数据,用管道是最省事、最有效率的,平衡性好,如果你要写的全是简单的键值对,并且数量巨大,用MSET会更胜一筹,如果你是做大规模数据迁移或初始化,可以考虑研究一下redis-cli --pipe这个终极方案,核心思想就一个:想尽办法减少和Redis服务器的网络通信次数,把多个操作合并成一个批次来处理。

本文由芮以莲于2026-01-02发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/73045.html