字节跳动用Doris做湖仓分析,聊聊他们是怎么搞的,遇到啥问题和解决思路

- 问答

- 2026-01-02 12:01:15

- 4

这个事情主要来源于字节跳动技术团队自己分享的几篇博客文章,字节跳动基于Doris的湖仓分析技术实践》和《字节跳动Doris实时数仓建设》等,他们讲了自己是怎么一步步把Doris用起来,并且解决实际问题的。

一开始,他们为啥选Doris?

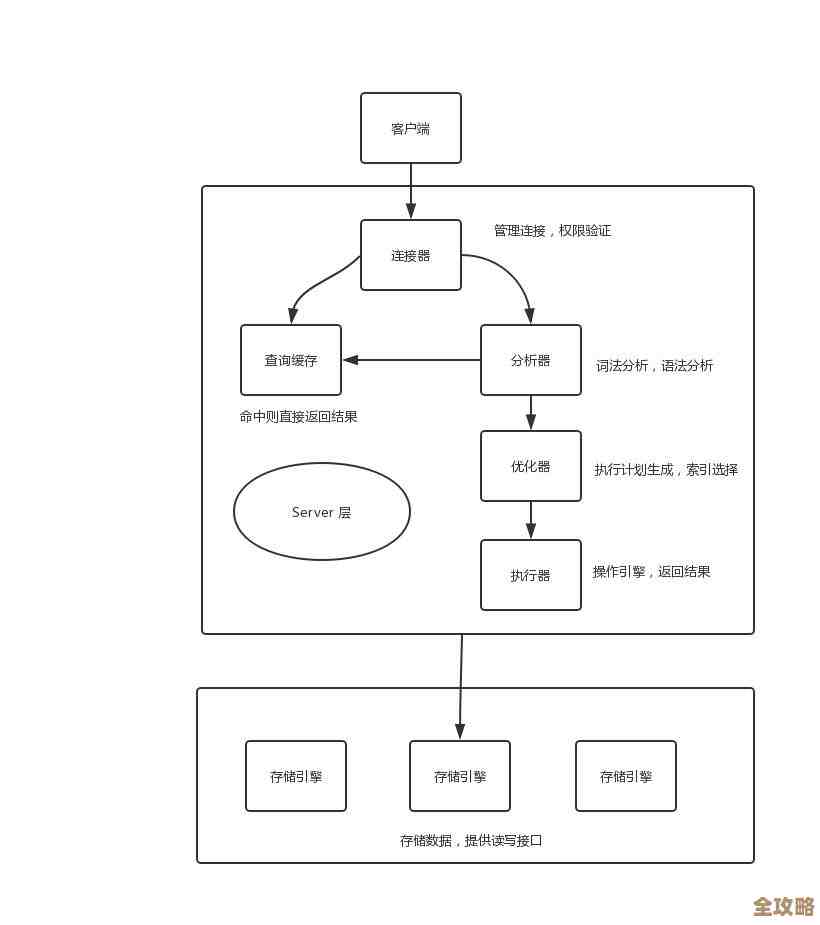

字节跳动的数据量太大了,业务又多又杂,以前那种老的数据架构,比如传统的数仓,处理离线数据还行,但速度慢,数据延迟高,可能今天才能看到昨天的数据,而一些专门的实时计算系统,虽然快,但又不太擅长处理复杂的查询分析,他们需要一个既能处理海量历史数据(像湖一样能存),又能快速响应交互式查询(像仓一样好用)的东西,这就是所谓的“湖仓一体”概念。

Doris作为一个开源的、基于MPP(大规模并行处理)架构的分析型数据库,正好有几个点吸引了他们:它兼容MySQL协议,这意味着公司里很多开发者和数据分析师用起来学习成本低,直接用熟悉的工具就能连上查询,它的性能不错,特别是对于多表关联、即席查询这种场景,它支持实时数据导入和更新,这符合他们对实时性的要求,他们就决定在Doris的基础上,搭建自己的湖仓分析平台。

他们具体是怎么“搞”的?

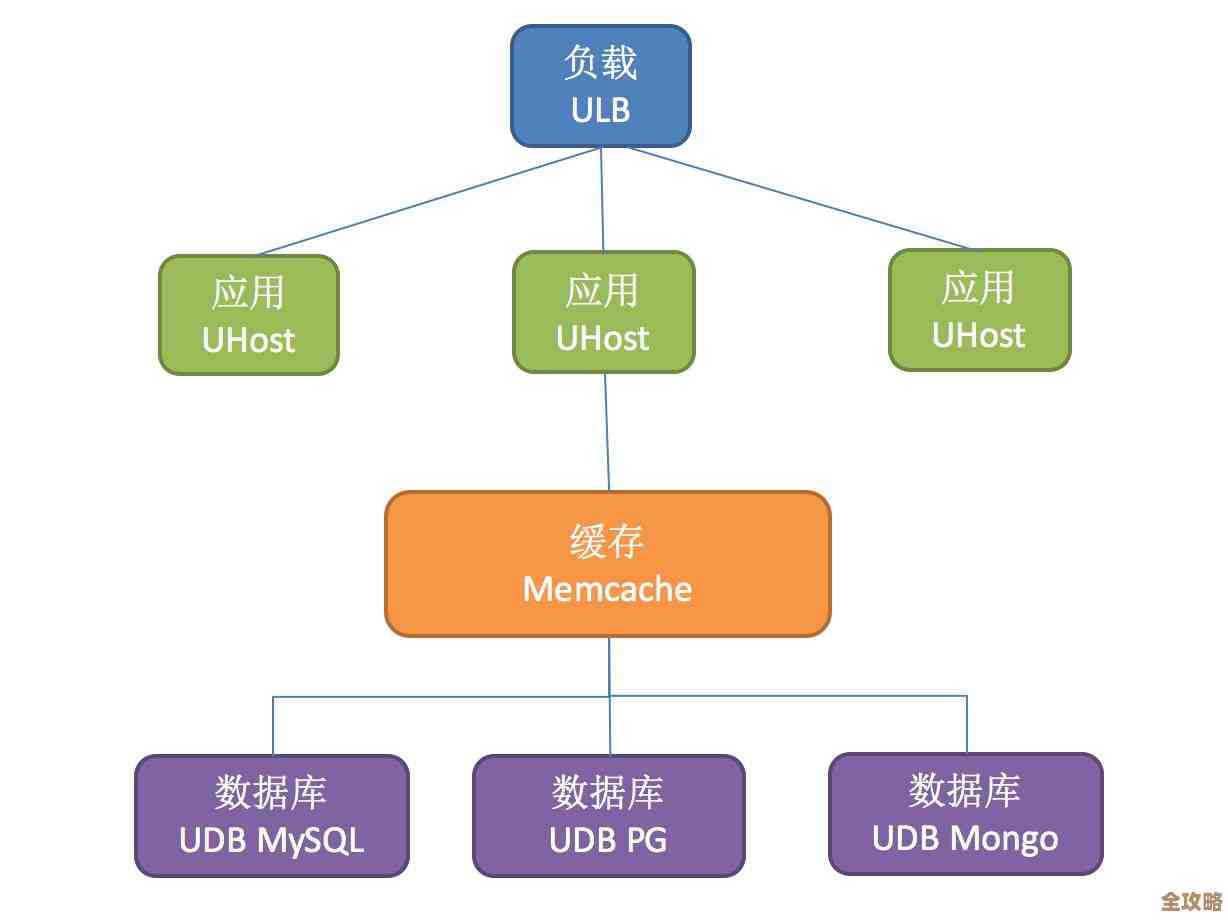

简单说,就是把Doris作为整个数据链路的核心“服务层”或者“加速层”,数据从哪儿来呢?四面八方都有:比如用户在使用抖音、今日头条等App时产生的实时日志,通过消息队列(如Kafka)流过来;还有业务数据库(比如MySQL)里变更的数据;以及已经存在数据湖(比如HDFS、Iceberg格式)里的海量历史数据。

他们的做法不是把所有这些原始数据都一股脑儿塞进Doris里,因为Doris虽然好,但存储成本也是要考虑的,他们采用了一种分层混合的策略:

- 热数据加速: 对于最近的需要被频繁、快速查询的数据,比如过去几小时或几天的核心业务指标,他们会通过实时数据导入工具(如Routine Load)把这些数据直接摄入Doris内部表中,这样,业务方就能对最新的数据做非常快的交互式分析,延迟可以做到秒级甚至毫秒级。

- 冷热数据结合: 对于更早的历史数据,可能查询没那么频繁,但偶尔也需要和热数据一起做全量分析,他们就利用了Doris支持的外部表功能,也就是说,数据物理上还保留在更便宜的数据湖(如Iceberg)里,但在Doris里创建一个“映射”或者叫“快捷方式”(外部表),这样,用户写一条SQL查询,Doris就能智能地同时查询自己内部的热数据和数据湖里的冷数据,然后把结果合并返回给用户,他感觉就是在查一个完整的数据集,不用关心数据具体存在哪里。

这样一来,Doris就像一个统一的查询入口,既保证了热点数据的高速访问,又借助数据湖降低了总体存储成本,实现了湖和仓的优势互补。

过程中遇到了啥问题?又是怎么解决的?

规模上去之后,问题自然就来了,他们遇到的挑战主要围绕“大”和“多”两个字。

-

元数据管理压力巨大。

- 啥问题: 当表的数量达到成千上万甚至更多,每个表又有大量分区和副本时,Doris的FE(前端节点)负责的元数据管理压力会非常大,这可能导致FE节点不稳定,比如启动变慢、偶尔无响应,影响整个集群的可用性。

- 解决思路: 他们做了好几方面的优化,一是对Doris内核进行了改进,优化了元数据的加载和同步逻辑,二是规范了用户建表的行为,比如避免创建过多不必要的分区,推广使用一些最佳实践,三是加强了监控,一旦发现元数据增长过快或异常,能及时干预,核心思路就是“减负”和“优化”。

-

大数据量导入时的稳定性。

- 啥问题: 字节的数据流入量极其恐怖,在高速实时写入Doris时,尤其是在数据高峰期间,可能会把BE(后端存储节点)的磁盘IO或者网络带宽打满,导致导入变慢甚至失败,进而可能引起数据堆积。

- 解决思路: 他们开发了更智能的流控和降级机制,不是一味地猛灌数据,而是根据后端节点的实际负载能力(比如CPU、内存、磁盘IO使用率)动态调整数据导入的速度,如果某个节点压力太大,就暂时少给它分点数据,或者让数据在消息队列里稍微等一等,等节点缓过来再继续导入,保证了整个导入过程的平稳。

-

应对超高并发的查询。

- 啥问题: 公司内部成百上千的业务团队同时使用,可能会在某一时刻发起大量复杂查询,瞬间占满集群资源,导致查询排队、超时,影响所有用户。

- 解决思路: 他们完善了资源隔离和多租户管理,可以想象成把一个大集群划分成多个“虚拟小组”,给重要的业务部门分配保证的资源配额(比如CPU、内存),这样即使其他部门有突发的大量查询,也不会把核心业务的资源抢光,他们对查询语句本身也做了更多的监控和优化,会识别并限制那些过于消耗资源的“慢查询”,避免一条坏SQL拖垮整个集群。

字节跳动用Doris做湖仓分析,不是一个简单的“拿来就用”,而是一个不断磨合、优化和增强的过程,他们看中了Doris的性能和易用性,然后结合自身超大规模的场景,在元数据管理、数据导入、查询并发等关键环节下了狠功夫进行改造和优化,最终才让Doris能够稳定支撑其庞大的数据分析需求,他们的经验表明,开源技术要想在极端场景下用好,离不开深入的定制化和持续的运维投入。

本文由歧云亭于2026-01-02发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/73066.html