Redis缓存永远不过期?其实时间和存储才是关键保障

- 问答

- 2026-01-03 00:24:05

- 1

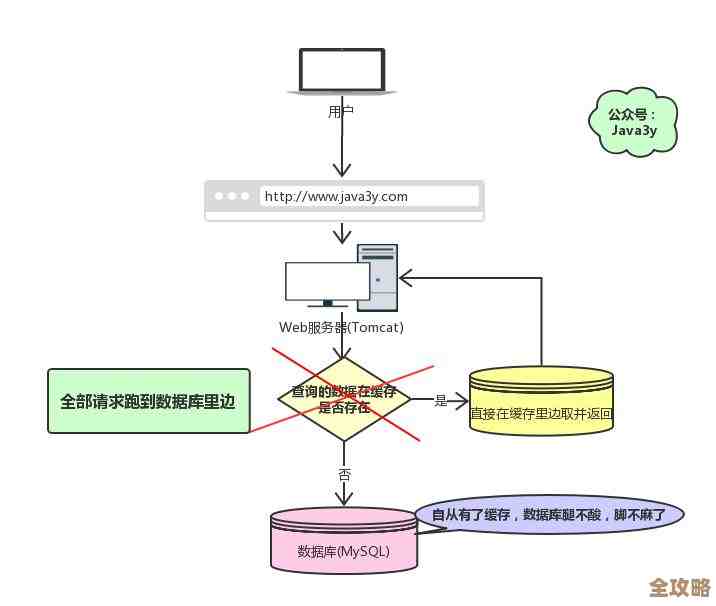

说到Redis缓存,很多人可能听说过一种取巧的做法:把缓存数据设置为永不过期,然后通过应用程序逻辑或者依赖Redis的内存淘汰机制来管理,听起来好像省事了,但实际情况是,这种做法就像把房子建在流沙上,看似稳固,实则隐患重重,真正想让Redis成为系统的坚强后盾,关键不在于耍小聪明,而在于深刻理解并处理好两个核心要素:时间和存储。 参考了多位资深开发者在技术社区如CSDN、博客园等的实践经验分享)

为什么“永不过期”是个危险的陷阱?

我们得明白,“永不过期”并不意味着数据真的能永久有效,业务数据总是在变化的,比如商品价格、用户积分、热点新闻列表等等,如果你设置了永不过期,那么当源头的数据发生变化时,缓存里的旧数据就成了“脏数据”,用户看到的就是过时信息,这会直接导致业务错误。

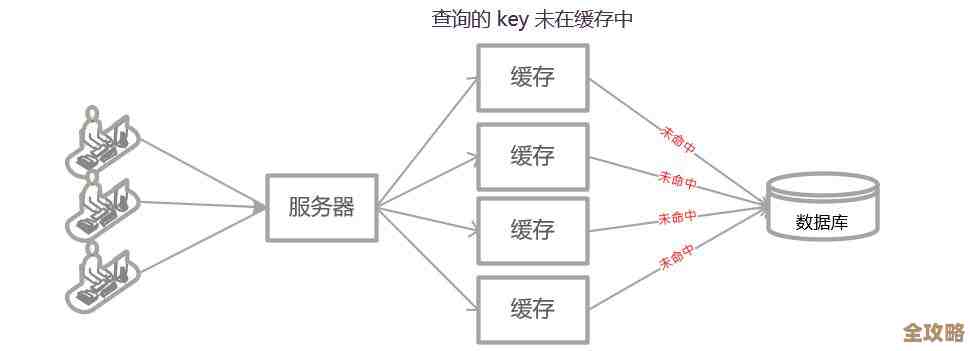

它把清理缓存的责任完全推给了Redis自身的内存淘汰策略,当内存满了,Redis会根据你设置的策略(比如LRU,最近最少使用)来淘汰一些键,但这是一种被动的、不可控的行为,你无法预测哪些关键数据会被意外淘汰,可能导致某个冷门但重要的功能突然访问数据库,引发雪崩风险,大量永不过期的键也可能导致内存无法及时释放,最终拖慢整个Redis实例。

时间是缓存可靠性的第一道防线

聪明的做法是主动给缓存数据一个合理的“生命期限”,也就是过期时间(TTL),这是保障数据最终一致性和系统健康度的最基本、最有效的手段。

-

常规过期时间设置:对于大多数业务场景,给缓存设置一个固定的过期时间是标准做法,用户会话信息可以设置30分钟过期,一些不常变的基础数据可以设置1小时甚至24小时,这确保了即使没有外部更新,旧数据也会在一定时间后自动失效,下次查询时能重新从数据库加载最新数据,保证了数据的“最终正确”。

-

延迟双删策略:在数据更新非常频繁,对一致性要求高的场景下,可以结合“延迟双删”,具体就是:当更新数据库时,先删除缓存中的旧数据,然后更新数据库,可以异步延迟几百毫秒)再删一次缓存,这个第二次删除是为了防止在“更新数据库”这个极短的时间窗口内,有其他请求误将旧数据再次写入缓存,这通过精细的时间控制,大大降低了脏数据出现的概率。

-

主动更新与续期:对于一些特别热门的关键数据,还可以采用主动更新的策略,在缓存数据即将过期前,由一个后台任务主动去查询数据库并刷新缓存,延长其存活时间,这样可以保证热点数据始终可用,避免了大量请求在缓存失效的瞬间同时涌向数据库。

存储是缓存稳定性的坚实底座

光管理好时间还不够,如果存储本身不可靠,一切都是空中楼阁,这里的“存储”主要指Redis的内存管理和持久化机制。

-

内存是核心资源:Redis的数据全部放在内存里,所以内存大小直接决定了你能缓存多少数据,必须根据业务量合理规划内存容量,并设置监控告警,避免内存耗尽,一定要配置合适的内存淘汰策略(如volatile-lru),告诉Redis当内存不足时,应该优先淘汰那些设置了过期时间的键,而不是报错或者随机淘汰,这为系统提供了缓冲余地。

-

持久化是数据安全的保障:虽然缓存可以丢失,但完全丢失后重建的成本可能很高,尤其是当数据库压力很大时,Redis提供了两种主要的持久化方式:RDB(快照)和AOF(日志),RDB定期生成数据快照,恢复速度快,但可能会丢失最后一次快照后的数据,AOF记录每一次写操作,数据安全性更高,但文件更大,恢复更慢,通常建议两者结合使用,用AOF保证数据安全,用RDB做冷备和快速恢复,这样即使Redis服务器重启,也能最大程度地减少数据丢失,快速恢复服务。

(关于持久化的具体细节,在Redis官方文档中有最权威的阐述)

回到最初的问题,Redis缓存永远不过期?这绝对不是一个好主意,它用一时的便利换来了长期的数据不一致和系统不稳定风险,真正让缓存发挥价值的,是我们对“时间”和“存储”这两个关键因素的精心设计。

通过设置合理的过期时间、运用延迟双删等策略,我们像一位精准的计时员,确保了缓存数据的鲜活性与一致性,通过对内存容量、淘汰策略和持久化机制的周密规划,我们又像一位坚实的守护者,保障了缓存服务本身的稳定与可靠,只有将这两方面都做到位,Redis才能真正成为提升系统性能的利器,而不是一个隐藏的故障点,在缓存的世界里,没有一劳永逸的捷径,只有对细节的把握才是关键。

本文由钊智敏于2026-01-03发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/73386.html