Redis高并发访问那些事儿,聊聊怎么用技术解决瓶颈问题

- 问答

- 2026-01-08 07:53:05

- 6

说到Redis高并发访问,这确实是很多互联网公司都会遇到的热门话题,想象一下,双十一抢购或者热门新闻爆出的那一刻,海量的用户请求像潮水一样涌向服务器,而Redis作为缓存和数据存储的关键一环,很容易就成为那个最拥挤的“路口”,要解决这个瓶颈,不能只靠买更好的硬件,更得靠一些巧妙的技术设计和策略,下面我们就来聊聊这些实实在在的解决办法。

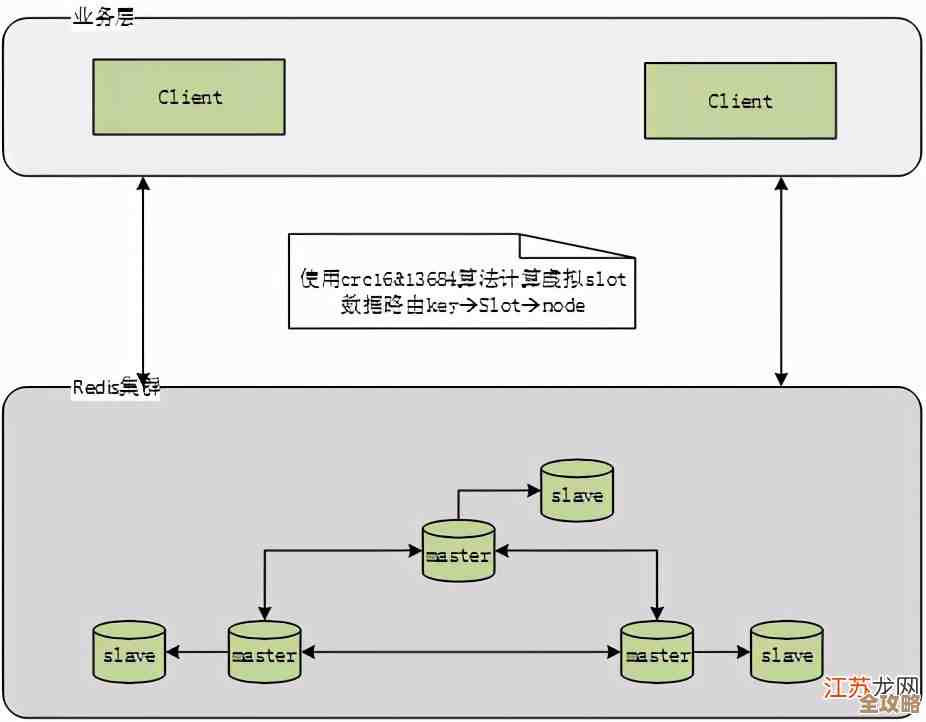

最直接也最有效的招数之一,就是搭建Redis集群,这就像是一个超市只有一个收银台,排队的人肯定多到爆,为了解决这个问题,我们多开几个收银台,把顾客分流,Redis集群也是这个道理,通过把海量的数据分散到多个Redis节点(也就是多台服务器)上,让每个节点只负责处理一部分数据和请求,这样一来,压力就被分摊了,整体的处理能力自然就上去了,这是应对高并发和海量数据的基本操作。(来源:Redis官方文档关于分布式集群的架构说明)

光有集群还不够,热点数据”会成为意想不到的瓶颈,比如某个顶流明星突然发布恋情,他的一条微博数据可能会在瞬间被上百万次地读取,即使有集群,如果这条数据只存在某一个节点上,那么这个节点就会承受巨大的压力,这就是所谓的“热点Key”问题,解决这个问题,可以从几个小处着手,一个办法是本地缓存,在访问Redis之前,业务服务器自己可以先在本地内存里存一份热点数据,这样大量的重复读取就不用每次都跑到Redis那里了,大大减轻了Redis的压力,很多公司内部的缓存架构都采用了这种多级缓存的思路,另一个办法是对热点Key进行备份,通过一些技术手段,将一个热点Key在集群中复制多份,存放在不同的节点上,读取的时候可以随机访问任何一个副本,从而将流量打散。(来源:应对电商大促场景中热点Key问题的常见工程实践)

除了读的问题,高并发下的写操作也很棘手,比如一个热门商品的库存,在秒杀时会被频繁扣减,如果每次扣减都直接对Redis进行写操作,Redis可能会扛不住,这时候,异步化和批量处理就成了法宝,我们可以先把这些写请求接收下来,放在一个消息队列里“排队”,然后后端再以可控的速度从队列里取出请求,批量地、顺序地更新到Redis中,这样就把一瞬间的猛烈冲击变成了一个平稳的流水线作业,虽然数据有一点点延迟,但保证了系统不被冲垮,对于秒杀这种可以接受短暂延迟的场景非常有效。(来源:大型电商平台在秒杀场景下对写操作进行削峰填谷的通用方案)

用好Redis本身的一些特性也能事半功倍,比如管道(pipeline)技术,正常情况下,客户端发一个命令给Redis,然后等待它返回结果,再发下一个命令,这中间网络来回的时间(网络延迟)累积起来就很可观,管道技术允许客户端一次性打包多个命令发送给Redis,然后一次性读取所有返回结果,极大地减少了网络通信次数,在高并发场景下对性能提升非常明显,这就像是你去超市买东西,一件一件结账和把所有东西一次结账,效率差别巨大。(来源:Redis官方文档中关于管道技术提升性能的说明)

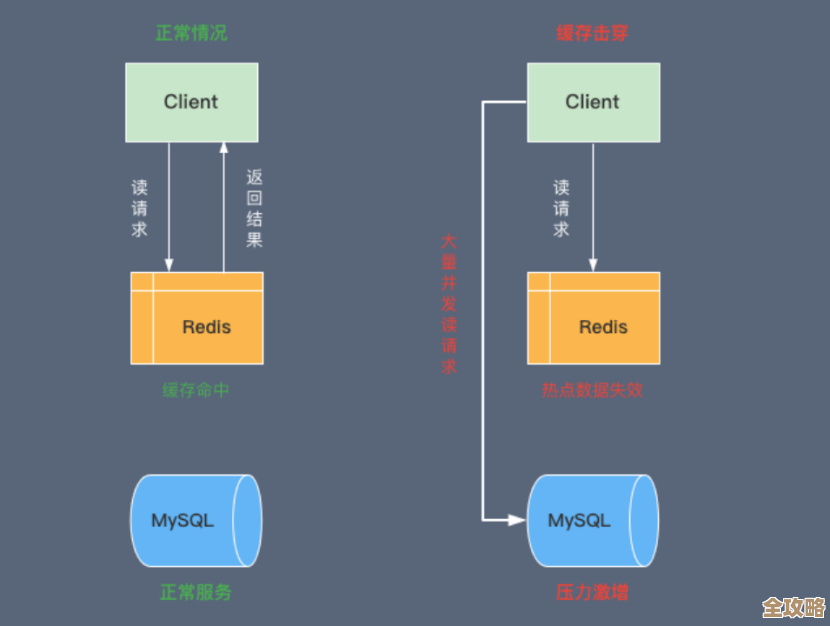

还有一个不能忽视的方面是Key的设计,胡乱设置Key的过期时间可能会导致某个时间点有大量Key同时失效,这时所有请求都会直接打到后端的数据库上,造成数据库压力激增,这就是“缓存雪崩”,为了避免这种情况,可以给Key的过期时间加上一个随机值,让它们分散失效,也要避免使用非常长的Key或者存储过大的Value,因为这会消耗更多内存和网络带宽。(来源:关于缓存雪崩、缓存击穿等经典问题的分析与解决方案讨论)

解决Redis的高并发瓶颈不是一个单点技术就能搞定的,它需要一个组合拳,从宏观的集群架构分摊压力,到微观上对热点数据、读写命令、Key本身设计的精细优化,再加上异步队列这样的缓冲机制,层层设防,才能稳稳地扛住流量的洪峰,这些方法都是在实际的生产环境中被反复验证过的,是保障系统高可用的宝贵经验。

本文由钊智敏于2026-01-08发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/76692.html