云原生环境里,迁移和灾备那些不得不考虑的事儿

- 问答

- 2026-01-09 21:53:43

- 2

在云原生环境里,谈到迁移和灾备,很多人可能会觉得既然已经用了云,天然就高可用、易迁移,但实际情况远非如此简单,云原生架构,尤其是基于微服务、容器和动态编排的特性,带来巨大灵活性和弹性的同时,也让传统的迁移和灾备思路面临挑战,这里有几个你不得不仔细考虑的关键点。

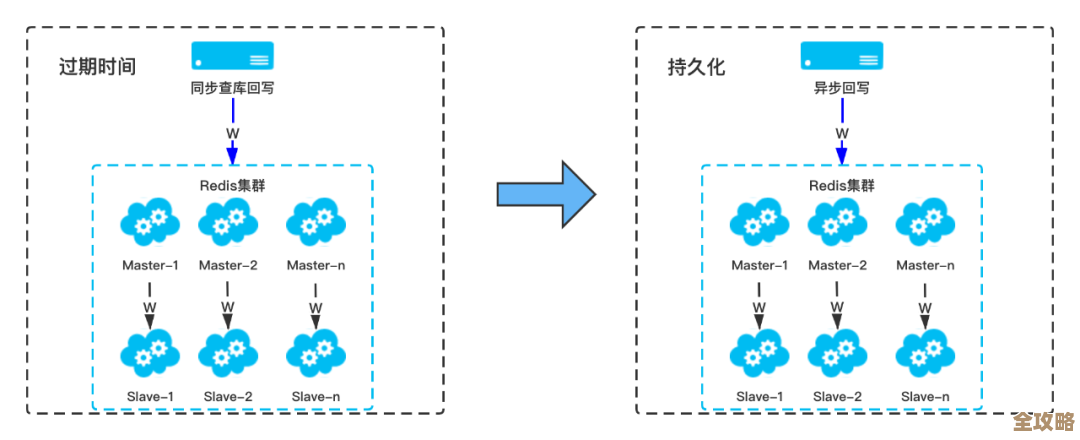

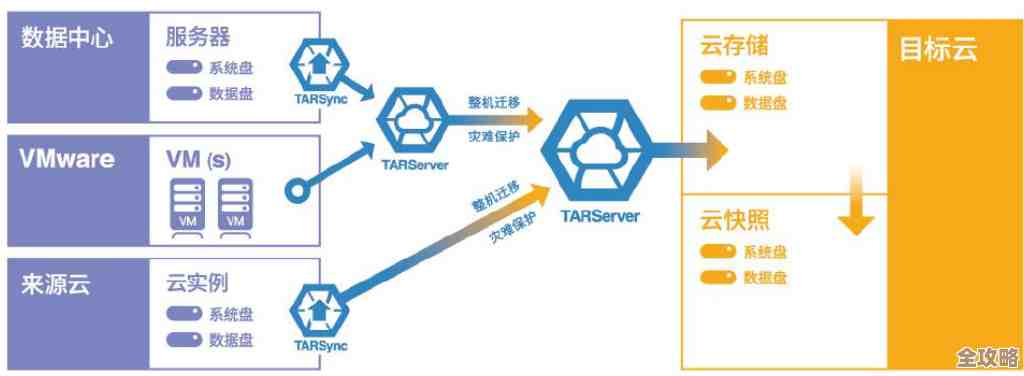

你得想清楚,你的“状态”放在哪里,这是云原生灾备最核心的问题,在传统的单体应用里,状态(比如用户的会话信息、应用内存中的数据)可能和应用本身紧耦合,或者存在一个集中的数据库里,但在微服务架构下,情况复杂得多,有些服务可能是无状态的(比如一个图片处理服务),这类服务的迁移和恢复最简单,因为只要在新环境拉起新的容器实例就行,但更多服务是有状态的,比如购物车服务、用户配置服务,根据云原生领域的常见实践(例如CNCF社区中对于有状态工作负载的讨论),你必须明确这些状态数据是如何管理的:是保存在容器内部(这非常危险,容器重启数据就丢了),还是通过持久化卷挂载?如果是持久化卷,那么这些卷的快照和跨区域复制能力,就成了灾备方案的生命线,你不能假设应用能无缝切换,而数据却跟不上,在规划灾备时,数据同步的RPO(能容忍丢失多少数据)和目标,直接取决于你选择的存储方案的数据复制能力。

应用依赖的配置和密钥管理,不能再用老办法,在云原生环境中,应用配置(比如数据库连接地址、功能开关)通常不会硬编码在容器镜像里,而是通过ConfigMap、Secret等资源对象动态注入,同样,根据十二要素应用准则的精神,配置应该与代码分离,当你需要将一个应用从一个Kubernetes集群迁移到另一个(比如从自建集群迁到云托管集群,或者从一个云区域迁到另一个),这些配置信息也需要一并迁移,更重要的是,这些配置信息很可能因为环境不同而需要修改,比如测试环境的数据库地址和生产环境肯定不一样,你需要一套可靠的机制来管理多套环境的配置,并确保在灾备切换时,应用能自动获取到正确的、对应于新环境的配置,手动修改不仅效率低下,而且极易出错,在紧急的灾备场景下可能是灾难性的。

第三,网络和服务发现是另一个大坑,在云原生里,服务之间通过服务名(而不是IP地址)来相互发现和通信,这是由集群内的DNS等服务发现机制实现的,当你把整个应用栈迁移到一个新的集群或新的区域时,服务的网络拓扑很可能发生了变化,原来在同一个集群内部的服务间调用,在灾备场景下,可能会变成跨区域甚至跨云的调用,这必然会引入更高的网络延迟和不稳定性,你必须测试在这种新的网络环境下,你的应用是否还能正常工作,超时设置是否合理,服务间的熔断和降级机制是否能有效触发,对外的访问入口(Ingress/LoadBalancer)的配置也需要重新映射到新的集群,如果灾备方案是热备(备用环境一直运行),你还需要考虑如何将流量平滑地切换到备用站点,这通常需要借助全局负载均衡器等更上层的网络设备或服务。

第四,持续部署流水线本身也需要具备灾备能力,现代应用开发强调CI/CD(持续集成/持续部署),你的应用代码和基础设施可能都是通过代码来定义的,当生产环境的主集群瘫痪时,你用来修复bug和重新部署的CI/CD工具链是否也高可用?如果构建服务器、代码仓库、镜像仓库都部署在同一个可能故障的区域,那么灾备恢复过程就会变得非常被动和缓慢,业界的最佳实践是,你的CI/CD关键组件,尤其是存放“唯一真相源”(如Docker镜像仓库、Helm Chart仓库、基础设施代码库)的部分,本身就应该具备跨区域冗余的能力,这样才能确保在灾难发生时,你仍然有能力在备用环境快速、准确地重建整个应用。

但极其重要的是:别指望理论,必须频繁演练,云原生环境的复杂性决定了,没有一个灾备方案可以“一次设计,永久有效”,服务的增减、依赖关系的变化、配置的更新,都可能让之前测试通过的灾备方案失效,你必须像进行消防演习一样,定期进行灾备演练,这种演练不能只是纸上谈兵,而是要真实地模拟故障,执行切换流程,并验证备用环境的应用是否真正可用、数据是否一致、性能是否达标,只有通过反复的演练,你才能发现方案中的漏洞,熟悉操作流程,缩短真正的灾难发生时的恢复时间,很多云服务商也提供了类似“故障注入”的工具来帮助进行这类测试。

云原生环境的迁移和灾备,考验的不是单个技术点,而是对整个应用架构、数据流、配置管理和运维流程的综合把控能力,它要求你放弃“一劳永逸”的想法,转而建立一种持续验证和优化的韧性运维文化。

本文由邝冷亦于2026-01-09发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/77678.html