聊聊Zookeeper那些核心设计和实战中遇到的分布式协调问题

- 问答

- 2026-01-10 10:24:51

- 3

主要参考自技术博客“Zookeeper深度解析”与开源社区实践讨论)

Zookeeper本质上是一个为分布式应用提供协调服务的小文件系统,它的核心设计目标就一个字:稳,为了实现这个“稳”字,它做了几个特别关键的设计。

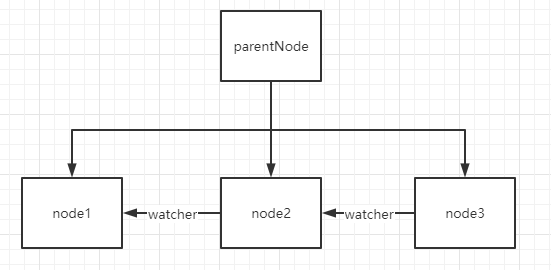

它把自己设计成了一个类似文件目录树的结构,你不用把它想得太复杂,就把它当成一个共享的文件夹就行了,不同的应用都可以来这个文件夹里创建自己的子文件夹(ZNode),或者在这些文件夹里存一点点信息(比如几个字节的配置数据),这个设计的好处是特别直观,开发者很容易理解,用创建文件、监听文件变化这些简单的操作,就能实现很多复杂的协调功能。

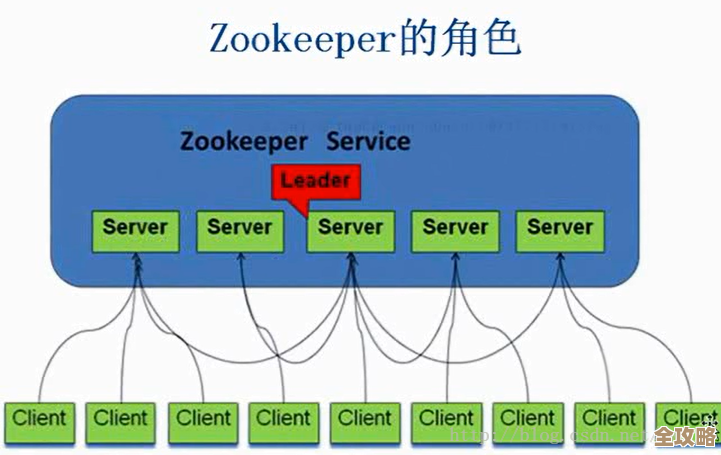

但光有这么一个共享文件夹还不够,万一这个文件夹所在的机器宕机了,那整个系统不就全挂了吗?Zookeeper的第二个核心设计是集群模式,它通常由奇数台机器(比如3台、5台)组成一个集群,这些机器之间通过一个叫Zab协议的机制来保持数据的一致性,你可以把这个协议理解为一个严谨的“开会表决”流程,每当有应用要修改数据(比如创建一个新文件),这个请求不会立刻执行,而是会先发给集群中的一台机器,这台机器作为“临时主席”,会把修改提议广播给所有其他机器,只有当超过半数的机器回复“同意”后,这个修改才会被最终确认并执行,这样,即使其中一两台机器坏掉了,只要还剩下超过半数的机器是好的,整个Zookeeper服务就能继续正常工作,数据也不会丢,这就是它高可用的秘密。

第三个核心设计是会话机制,一个应用连上Zookeeper集群后,会建立一个会话(Session),这个会话是有“生命”的,需要客户端和服务端通过心跳来保持活跃,如果因为网络问题,客户端长时间没“心跳”了,Zookeeper服务器就会认为这个客户端“挂了”,然后它会自动清理掉这个客户端创建的所有临时文件(Ephemeral ZNode),这个特性非常有用,是实现服务发现和分布式锁等功能的基础,一个服务实例启动时,在Zookeeper上创建一个临时节点作为自己的注册信息,它如果意外宕机,会话失效,这个节点会被自动删除,其他服务就能立刻感知到它下线了。

聊完了核心设计,再说说实战中经常遇到的让人头疼的协调问题。

第一个常见问题是脑裂,虽然Zookeeper用“过半机制”很大程度上避免了脑裂,但在复杂的网络环境下,问题依然可能存在,一个3节点的集群,可能因为网络故障,被分成了两部分:一部分是A、B两台机器(它们之间网络是通的),另一部分是孤立的C机器,A、B构成了多数派,它们会继续对外服务,而C因为无法联系到多数派,会自动停止服务,这没问题,但麻烦的是客户端,如果有些客户端只连着C,它们会认为Zookeeper服务不可用了;而连着A或B的客户端则认为服务正常,这就造成了系统状态的不一致,虽然Zookeeper服务本身没分裂,但客户端视角分裂了,解决这类问题通常需要在客户端侧也增加一些容错和重连策略,不能完全依赖一次连接。

第二个是羊群效应,这在使用Zookeeper实现分布式锁时尤其典型,有上百个客户端同时竞争一把锁,它们都会去监听锁文件的变化,当锁被释放,文件消失的那一刻,上百个客户端会同时收到通知,然后一窝蜂地发起创建锁文件的请求,这会给Zookeeper服务器带来巨大的瞬时压力,可能直接打垮服务器,正确的做法是使用“顺序临时节点”,每个客户端不是直接争抢一个锁文件,而是都在一个父目录下创建顺序编号的临时文件,编号最小的那个客户端获得锁,没获得锁的客户端,只需要监听排在自己前面的那个编号的文件就行了,这样,锁释放时,只会有一个客户端(即下一个编号的持有者)被触发,完美避免了惊群问题。

第三个是ZooKeeper的性能瓶颈,Zookeeper的设计目标是保证强一致性和高可用,而不是极高的吞吐量,它的写操作(比如创建节点)因为要走“过半表决”流程,延迟会比读操作高很多,所有写请求都必须由同一个Leader节点来处理,这也限制了写性能的扩展,它非常适合存储那些“读多写少”的元数据配置信息(比如几十KB以内),如果你试图用它来频繁地存储大量业务数据或者做消息队列,那性能肯定会成为灾难,在实际架构中,一定要根据它的特性把它用在合适的场景。

Zookeeper通过简洁的数据模型和严谨的共识协议,为解决分布式环境下的协调问题提供了一个非常可靠的基础工具,但用好它,不仅要知道它能做什么,更要清楚它的边界和陷阱,这样才能在实战中避免踩坑。

本文由水靖荷于2026-01-10发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/78007.html