数据库扩容失败背后的那些坑和常见误区你真的注意到了吗

- 问答

- 2026-01-11 01:25:11

- 4

在数字化时代,数据量爆炸式增长,数据库扩容成了许多技术团队必须面对的课题,扩容并非简单地给服务器增加内存或硬盘那么简单,它像一次对系统架构、团队协作和风险管控能力的综合大考,很多团队兴冲冲地启动扩容项目,却一头栽进了事先未曾预料到的深坑里,导致服务长时间不可用、数据丢失甚至更严重的业务事故,这些失败背后的坑和误区,往往比想象中更常见。

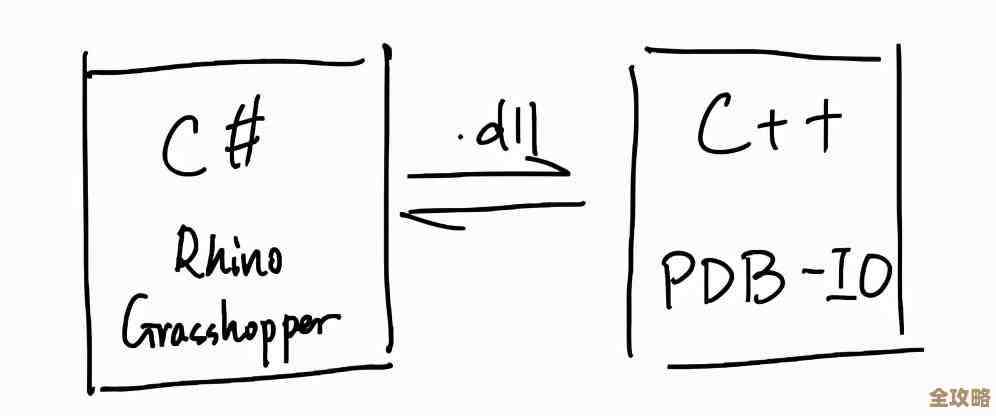

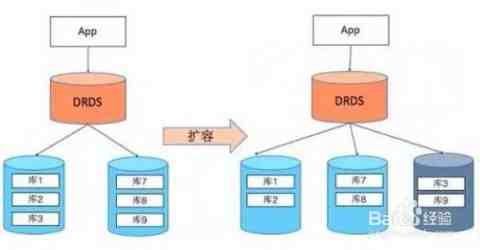

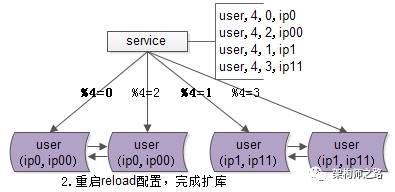

第一个常见的巨大误区是“只关注硬件,忽视架构”,很多决策者认为扩容就是“花钱买平安”,只要采购更高配置的服务器,把数据库迁移过去就万事大吉,这其实是最危险的认知,如果数据库本身是单点架构(比如一个庞大的单机数据库),那么单纯升级硬件只是在延缓“单点故障”这颗炸弹的爆炸时间,并没有从根本上解决问题,一旦数据量或并发量超过新硬件的极限,系统会再次崩溃,而且届时扩容的成本和风险会更高,正确的思路应该是,趁扩容之机,审视并优化架构,例如引入读写分离,将数据分片(Sharding),或者采用更适合的分布式数据库,架构上的改进,才能为未来的增长提供弹性的空间。

第二个坑是“认为扩容是纯技术活,缺乏全盘业务规划”,技术团队在封闭的环境里设计扩容方案,却没有和业务部门充分沟通,这会导致几个问题:一是容量规划不准,技术团队可能只根据当前数据量翻倍来规划,但业务可能正计划下个季度推出一个爆款活动,流量会呈指数级增长,二是对业务影响评估不足,扩容往往伴随着数据迁移,期间可能需要停机或服务降级,如果没提前和业务方确定好停机时间窗口(比如必须避开促销日),并通知到用户,仓促执行就会直接冲击业务,引起客户投诉,三是忽略了数据一致性的业务含义,在分布式架构下,有时为了性能会采用最终一致性模型,但如果业务是金融交易场景,要求强一致性,技术上的妥协就可能造成资损。

第三个非常隐蔽的误区是“测试不充分,尤其是忽略了‘放大效应’”,在测试环境中,数据量小,一切运行顺畅,团队便认为方案可行,但真实的数据量和并发压力会将一些在测试中无法显现的问题放大,某个在百万数据量下效率尚可的SQL查询语句,在数据量达到十亿级别时可能会瞬间拖垮整个数据库,又比如,网络带宽在数据迁移过程中成为瓶颈,导致迁移时间远超预期,延长了系统风险窗口,测试必须尽可能模拟真实场景,进行全量数据压测,并重点关注那些在数据量增长后可能出现的性能瓶颈。

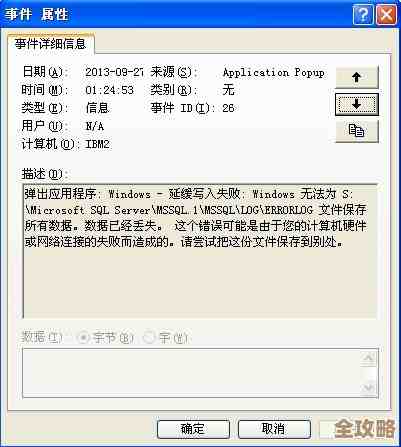

第四个坑是“只考虑扩容过程,忽视扩容后的稳定运行”,团队可能花费大量精力保证了数据平滑迁移,但系统切换成功后便松了一口气,认为任务完成,新的架构或更大的集群会引入新的复杂性,监控系统是否覆盖了所有新节点?告警阈值是否重新设定?原有的运维脚本和备份策略是否依然适用?如果监控不到位,新集群中某个节点出现异常可能无法被及时发现,最终酿成大祸,扩容后必须有完善的运维保障体系,确保能掌控新环境的运行状态。

第五个常见错误是“缺乏详尽的回滚预案”,任何涉及数据迁移的核心操作都必须有“后悔药”,扩容过程中一旦发现数据不一致、性能不达标或出现无法解决的异常,必须能快速、安全地回退到扩容前的状态,回滚预案不能只存在于想象中,它需要详细的、经过验证的步骤:如何暂停新服务?如何将流量切回老库?如果迁移了一部分数据,如何保证回滚后老库的数据完整性?没有经过演练的回滚方案,在真正的危机面前很可能失效,导致团队陷入进退两难的境地。

数据库扩容是一个系统工程,它考验的不仅是技术实力,更是项目管理、风险意识和跨部门协作的综合能力,成功避开这些坑和误区,意味着团队不能只埋头于技术细节,而要以更广阔的视角,从业务目标出发,经过严谨的规划、充分的测试和周全的预案,才能确保扩容行动真正成为业务发展的助推器,而不是一场技术灾难的导火索。

本文由芮以莲于2026-01-11发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/78397.html