用Redis缓存搞定定时入库,效率蹭蹭往上涨的感觉

- 问答

- 2026-01-11 19:25:49

- 3

行,那咱们就直接开聊怎么用Redis这个“内存高速路”来搞定定时入库,让系统效率真正“蹭蹭往涨”,这事儿说白了,就是面对那种数据来得又猛又快,如果每次都直接往数据库里硬写,数据库肯定吃不消,轻则变慢,重则直接“罢工”,我们得找个中间商……不不,是找个高效的中间层来帮我们扛一下,先把数据稳稳接住,然后再找个合适的时机,有条不紊地存进数据库。

核心思路:先接住,再慢炖

想象一下双十一秒杀的场景,或者是一个热门App上突然爆发的用户活动,成千上万条数据(比如订单、点击记录、日志)瞬间涌来,如果你的程序傻乎乎地每条都直接“INSERT INTO database...”,那数据库的连接池可能瞬间被占满,CPU和磁盘IO也会飙升到顶点,整个系统感觉就像早高峰堵死的环路,谁也动不了。

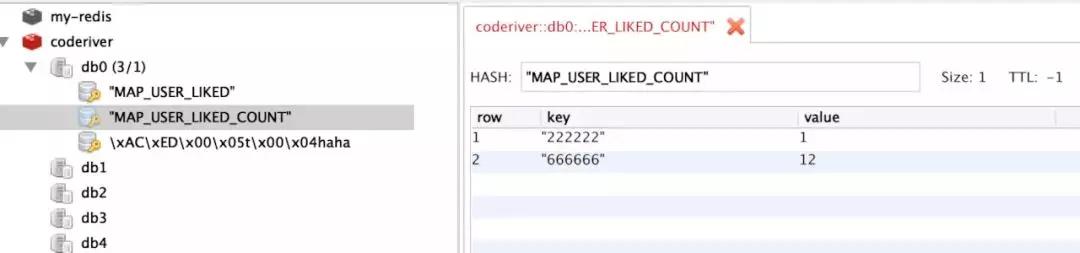

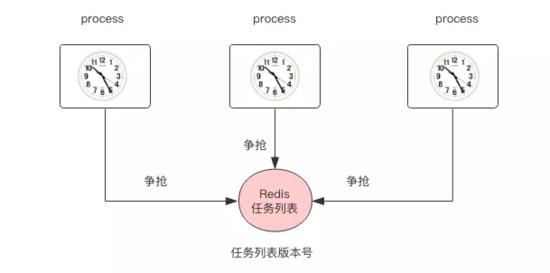

这时候,Redis就闪亮登场了,它的最大特点就是快,因为它把数据都存在内存里,我们可以让应用程序在产生数据后,不做复杂的计算,也不直接碰数据库,就干一件事:以最简单的动作,把数据快速地“扔”进Redis,用一个列表(List)或者集合(Set)来当这个临时的“蓄水池”或“中转站”,来自“知乎”的一些技术分享里常提到,这个过程通常能在毫秒级别完成,对应用程序的性能影响极小,用户体验自然就流畅了。

具体怎么“接”?姿势很重要

光有个池子还不行,怎么往里放数据也有讲究,你不能乱丢一气,得有点策略。

-

列表(List)大法好:这是最直观的一种方式,用户每产生一个行为,我们就用

LPUSH或RPUSH命令,把数据作为一条新消息追加到某个指定的List末尾,这样,数据就像在流水线上一样排起了队,它的好处是顺序保证,先来的数据在List的头部(如果用LPUSH就是最后来的在头部),处理起来不会乱,特别适合需要严格保证先后顺序的场景,比如某些金融交易记录。

-

发布/订阅(Pub/Sub)来帮忙:如果我们的系统架构更复杂一点,有多个不同的服务都需要处理这批数据,或者负责入库的程序不止一个,那Pub/Sub模式就派上用场了,应用程序不直接保存数据,而是作为一个发布者(Publisher),把数据作为一个消息“发布”到一个频道(Channel)里,专门负责入库的后台服务(一个或多个订阅者,Subscriber)会一直监听这个频道,一旦有消息进来,它们就能立刻收到并开始处理,这种方式解耦得更彻底,发布数据的应用根本不用关心后面谁来处理、怎么处理。

光接不存可不行,“定时入库”是关键

数据在Redis里躺舒服了,但内存是有限的,而且一旦服务器重启,数据可能就丢了,我们必须定期地把这些数据“搬运”到硬盘上的数据库(比如MySQL)里进行持久化,这就是“定时入库”的精髓。

我们得有一个独立的、后台运行的服务(比如用Python、Java等写的脚本或服务),这个服务啥也不干,就盯着Redis里的那个“蓄水池”。

- 定时触发:这个服务会设置一个定时器,比如每隔5秒钟,或者每隔一分钟执行一次,来自“CSDN”的很多实践文章建议,这个时间间隔需要根据业务对数据实时性的要求和数据量的大小来权衡,实时性要求不高,可以设长点,减少对数据库的压力;要求高,就设短点。

- 批量操作:定时器一到,这个后台服务就动起来,它会一次性从Redis的List里取出多条数据(比如用

LRANGE命令一次取100条,或者用RPOP命令循环弹出直到空),而不是一条一条地取,它再把这些数据组装成一条批量插入的SQL语句(比如MySQL的INSERT INTO table VALUES (...), (...), ...),一次性提交给数据库。

批量操作带来的效率飞跃

为什么批量操作这么神奇?你想啊,数据库执行一条插入10个记录的SQL,和循环执行10条每次插入1个记录的SQL,开销是天差地别的,后者需要建立/断开10次网络连接(如果连接池充足则主要是会话开销)、解析10次SQL语句、可能还要处理10次事务,而前者,绝大部分开销只有一次,这个性能提升是指数级的,正是这种“化零为整”的操作,让数据库的压力骤减,效率可不就“蹭蹭往上涨”了么?

得注意的几个坑

这办法好归好,但用的时候也得留个心眼,别掉坑里。

- 数据丢失的雷区:这是最大的风险,你用List的

RPOP命令,它是弹出并移除元素,万一你的后台服务在取出数据后、还没来得及存入数据库的时候就崩溃了,那这部分数据可就真丢了,更稳妥的做法是使用LRANGE读取数据,等确认数据库成功插入后,再用LTRIM命令来删除已经处理掉的数据,或者,可以考虑使用更可靠的消息队列,比如Redis的Stream数据结构(5.0版本后),它支持消息确认机制,能更好地保证数据不丢。 - Redis本身的持久化:虽然Redis是缓存,但我们把它用作了临时存储,所以最好配置一下Redis本身的持久化策略(RDB或AOF),防止服务器突然断电导致大量数据丢失。

- 监控不能少:你得时刻关注Redis里那个“蓄水池”的水位(列表长度),如果发现数据堆积得越来越快,入库程序处理不过来,那就要考虑是不是要优化入库程序的效率,或者增加更多的后台处理服务了。

用Redis做定时入库,本质上是一种“空间换时间”和“缓冲削峰”的思想,它把瞬间的暴雨转化成持续的细流,再引入数据库这个“水库”,完美地保护了数据库这座“大山”,让整个系统在洪峰来临时也能举重若轻,体验那种顺畅飞起的快感,这招在应对高并发、大数据量写入的场景时,绝对是一把利器。

本文由符海莹于2026-01-11发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/78867.html