Redis集群到底怎么搞才能真提升性能,别光说理论了实操才关键

- 问答

- 2026-01-14 00:19:52

- 2

第一,别一上来就集群,先看看是不是真的需要。

很多人一听高并发,就想当然要上集群,但Redis单机性能非常猛,除非你的数据量大到一台机器内存根本装不下(比如超过64G),或者写操作的QPS高到单机CPU扛不住了,否则盲目上集群只会增加复杂性和维护成本,来自阿里云开发者社区的一篇实践总结提到,他们很多场景下优先考虑升级单机硬件(比如用更强的CPU、更大的内存),或者通过优化数据结构、使用Pipeline等方式,就能解决问题,这比搞集群简单多了。

第二,如果数据量是硬伤,非上集群不可,那关键是怎么分片。

Redis集群用的是分片机制,也就是把数据分散到不同的节点上,这里最大的坑就是“热点Key”,比如你有一个超级大V的微博信息,这个Key被频繁访问,即使你集群有100个节点,但这个Key只存在其中一个节点上,导致这个节点的网卡被打满,其他99个节点闲得慌,整个集群的性能瓶颈就是这个节点,这叫“木桶效应”。

那怎么办?实操中有几个土办法:

- 拆Key:比如那个大V的信息,别存成一个巨大的Key叫

user:12345,你可以拆成user:12345:base_info、user:12345:fans_list、user:12345:latest_posts,这样通过合理的命名,这些被拆开的小Key可能会被散列到不同的节点上,分摊压力,这是来自腾讯云数据库团队在解决实际热点问题时的常用技巧。 - 本地缓存:对于那种读远多于写的热点数据,比如商品详情页的头部信息,可以在业务应用层加一个本地缓存(比如Guava Cache),设置一个短的过期时间(比如几秒钟),这样绝大部分请求在应用层就返回了,根本不会打到Redis集群上,这是高并发场景下的标准做法。

- 避免大Key:一个Key对应的Value值太大(比如一个List里塞了10万条数据),在读取、删除甚至迁移时,都会严重阻塞集群,导致性能抖动,平时开发时就要有意识地把大Key打散。

第三,管住客户端的嘴,别让它乱说话。

客户端是直接跟集群打交道的,它的行为直接影响集群性能,这里有三个必须要注意的操作:

- 一定要用连接池:禁止每次操作都创建新连接!连接建立和销毁的成本很高,使用连接池,让连接复用,像Jedis、Lettuce这些客户端都有连接池配置,要根据业务量合理设置最大最小连接数,不然连接数不够会报错,太多又会压垮服务器。

- Pipeline(管道)批量操作:如果你要连续执行很多个SET或GET命令,别一个个发,网络来回一次(网络延迟)的时间可能比Redis处理本身还长,Pipeline能把多个命令打包成一个请求发过去,服务器处理完再一次性返回结果,极大减少网络往返次数,这对手动挡车型来说是提升性能的必杀技,根据京东零售技术团队的实践,在批量写入场景下,使用Pipeline可以将性能提升数倍甚至十倍。

- *禁止使用Keys 这种命令**:在生产环境,尤其是在集群里,这个命令会扫描所有Key,直接导致Redis假死,模糊查询请用

SCAN命令,它是游标式的,不会阻塞服务。

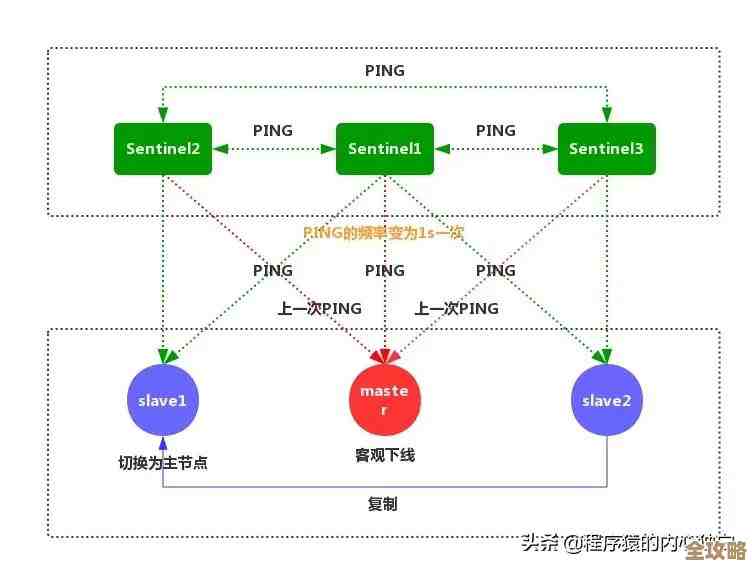

第四,主从配置不是摆设,读写分离要用起来。

Redis集群每个分片都是主从结构,默认情况下,写操作走主节点,读操作也默认走主节点,这会造成主节点压力大,你得让客户端支持“读写分离”,把读请求合理地分发到从节点上去,这样主节点专心处理写操作,读的压力由多个从节点分担,整体吞吐量就上去了,不过要注意,从节点同步主节点数据有毫秒级的延迟,对数据一致性要求极高的读操作(比如读了马上要写)还是要走主节点。

第五,监控和慢查询日志是你的眼睛。

性能优化不能瞎猜,必须打开Redis的慢查询日志(slowlog),设置一个阈值(比如5毫秒),凡是超过这个时间的命令都会被记录下来,你定期去分析慢查询日志,就能找到是哪些操作拖慢了集群,是某个复杂命令?还是出现了大Key?要用监控工具(如Prometheus+Grafana)实时监控集群的QPS、内存使用率、网络流量、连接数等指标,发现哪个指标异常,比如某个节点连接数飙升,就能马上定位问题。

提升Redis集群性能的实操核心就是:

- 分片前:想想能不能避免,避免不了就精心设计Key,防热点、防过大。

- 分片后:管好客户端,用池化、用批量、禁用危险命令。

- 运行时:用好读写分离分摊压力,用监控工具时刻掌握集群健康状况。

理论告诉你集群能扩展,但只有把这些实操细节做到位,才能真正把集群的性能榨出来,否则可能就是买个拖拉机发动机装在了法拉利上,根本跑不起来。

本文由芮以莲于2026-01-14发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/80233.html