用直接内存配合Redis,系统性能压力这事儿其实能缓解不少,真挺管用的

- 问答

- 2026-01-14 03:30:57

- 5

这事儿得从Redis的一个痛点说起,我们都知道Redis快,快得离谱,它把数据都放在内存里,读写操作直接跟内存打交道,速度自然不是硬盘能比的,这个“快”是有前提的,就是你的网络得跟得上,数据从Redis服务器传到应用服务器的这个过程,不能成为瓶颈。

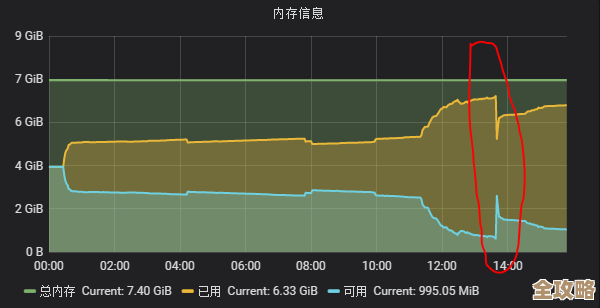

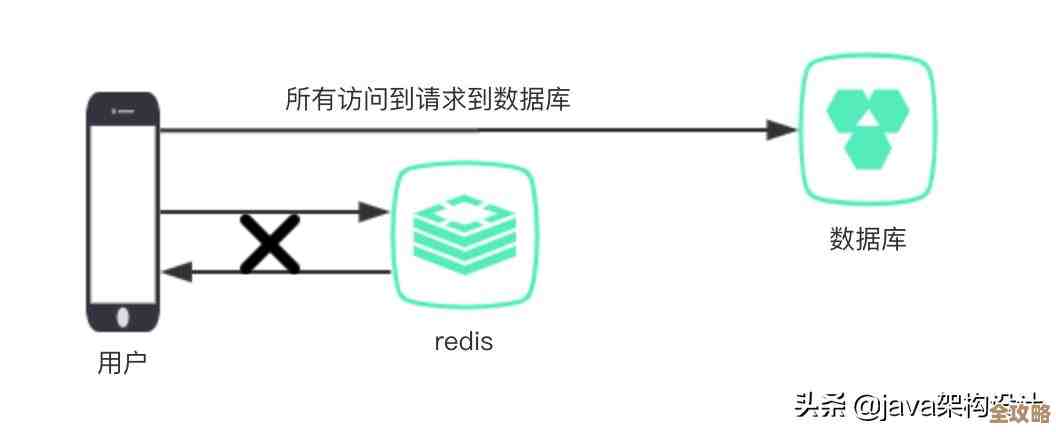

你想啊,一个最简单的GET操作,应用服务器得先给Redis服务器发个网络请求,Redis在内存里找到数据,再通过网络把数据传回来,这一来一回,网络延迟和网络带宽的消耗就加进来了,平时数据量小的时候感觉不出来,可一旦碰上高并发场景,或者需要频繁读取大对象(比如几MB的图片、长文本),这个网络传输的开销就非常可观了,Redis服务器本身CPU可能还很闲,但网络接口可能已经快被打爆了,应用端感觉到的就是响应变慢,性能压力一下子就上来了。

那怎么解决这个“最后一公里”的传输问题呢?这时候,“直接内存”的思路就派上用场了,这个想法的核心特别直接:既然网络传输是瓶颈,那我们能不能想办法让应用程序像Redis自己访问内存那样,直接去读数据,完全绕过网络呢?

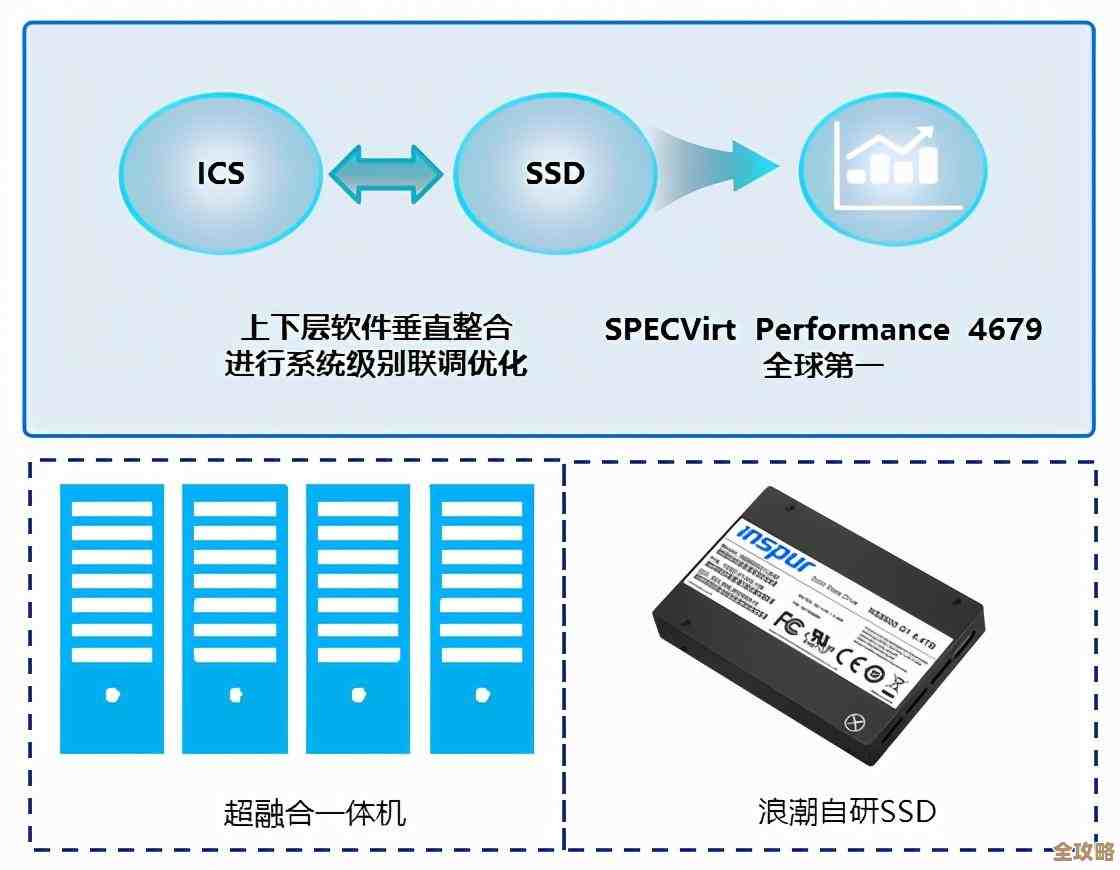

还真能,业界有一种成熟的方案,就是利用像“PCIe闪存卡”这样的硬件,它的玩法不是取代Redis,而是给它当“僚机”,你可以把Redis想象成中央仓库,里面放着全量的、最重要的热数据,而这个直接内存(比如一块高速的PCIe闪存卡),就像是分布在每个应用服务器身边的“前线补给点”。

具体怎么做呢?我们可以设计一个机制,当Redis中的数据更新时,除了在自身内存中完成操作,它还同时把这个更新后的数据,通过网络发送到各个应用服务器上的直接内存里,这个同步过程可以异步进行,不影响Redis主线程的性能,这样一来,每台应用服务器自己的直接内存里,都存有一份热数据的副本。

当应用程序需要读取数据时,它就不再需要千里迢迢地去访问远端的Redis了,而是直接扭头访问自己本机上的那块直接内存,这种访问是本地访问,速度极快,延迟极低,几乎就跟访问本地内存一个量级,这就相当于把数据的“远程调用”变成了“本地调用”,性能的提升是立竿见影的。

这种做法,其实有点类似CPU缓存的设计思想,CPU有自己的高速一级缓存、二级缓存,用来存放最常用的指令和数据,避免每次都去访问速度更慢的主内存,我们在这里就是把直接内存当作应用服务器的一个“大数据缓存”,专门缓存从Redis来的热数据。

天下没有免费的午餐,这种方案也有它的代价和需要注意的地方,最主要的就是数据一致性问题,因为数据现在有了多个副本(Redis主库一份,每台应用服务器的直接内存里各一份),当主数据在Redis中被修改后,如何及时、可靠地让所有副本都更新,就是个挑战,如果同步延迟了,应用就可能读到旧数据,这招更适合那些读多写少,且对数据的实时性要求不是那么极端苛刻的场景,电商网站的商品信息、新闻网站的新闻文章,这类数据更新不频繁,但读取压力巨大,用上直接内存分担Redis的读压力,效果会非常显著。

成本也是个考虑因素,虽然PCIe闪存卡比内存便宜,但毕竟也是一笔额外的硬件开销,你需要评估的是,性能提升带来的业务收益(比如更好的用户体验、能支撑更高的并发量从而带来更多收入),是否大于这块硬件的投入。

就像电脑发烧友会给自己的电脑加装高速固态硬盘来提升体验一样,用直接内存来配合Redis,本质上是一种“把钱花在刀刃上”的架构优化,它没有否定Redis的价值,而是巧妙地弥补了Redis在网络传输方面的天然短板,通过一种软硬件结合的方式,把系统的整体性能瓶颈往上推高了一大截,在那些读压力巨大的系统里,这个办法确实真挺管用的。

本文由太叔访天于2026-01-14发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/80314.html