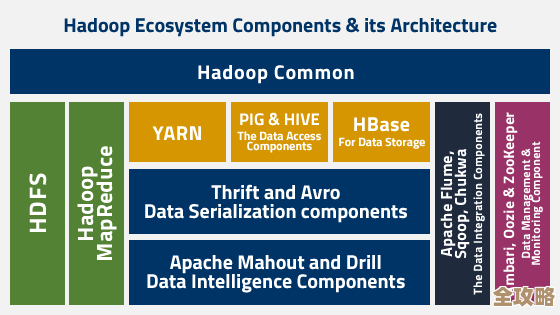

怎么用Sqoop选定某个数据库导数据,步骤和注意点讲解

- 问答

- 2026-01-16 10:01:32

- 2

要使用Sqoop从一个特定的数据库(比如MySQL)中导出数据,核心步骤可以概括为:准备好环境、写好命令、执行并检查,下面我以一个具体的例子,详细说明每一步怎么做,以及过程中需要注意哪些容易出错的地方。

第一步:确认前提条件都满足

在开始敲命令之前,有几件事必须确保已经搞定,这就像出门前要带好钥匙和手机一样。

- Sqoop本身已安装:你用的机器上(通常是Hadoop集群的一个节点)必须已经正确安装了Sqoop,你可以通过在命令行输入

sqoop version来检查,如果能看到版本信息,说明安装好了。 - 数据库驱动jar包:Sqoop需要连接具体的数据库,比如MySQL,那么就必须把MySQL的JDBC驱动jar包(通常是一个类似

mysql-connector-java-8.0.xx.jar的文件)放到Sqoop的lib目录下,不然Sqoop根本不认识怎么跟MySQL对话,这是最常见的一个错误。 - 网络连通性:确保你运行Sqoop命令的机器能够通过网络访问到目标数据库服务器的IP地址和端口(MySQL默认是3306),可以用

telnet <数据库IP> 3306这样的命令测试一下。 - 账户权限:你手里要有那个特定数据库的账号和密码,并且这个账号必须有读取你要导出的那个表(甚至整个数据库)的权限,最好提前用这个账号在别的MySQL客户端(如Navicat、DBeaver)上试一下能不能连上并查数据。

第二步:编写并执行Sqoop导入命令

假设我们要从MySQL数据库source_db中的user表,把数据导入到HDFS的/user/hive/warehouse/user路径下,一个最基础的命令长这样:

sqoop import \ --connect jdbc:mysql://数据库服务器IP:3306/source_db \ --username your_username \ --password your_password \ --table user \ --target-dir /user/hive/warehouse/user \ --m 1

我们来拆解一下这个命令的每个部分和注意点:

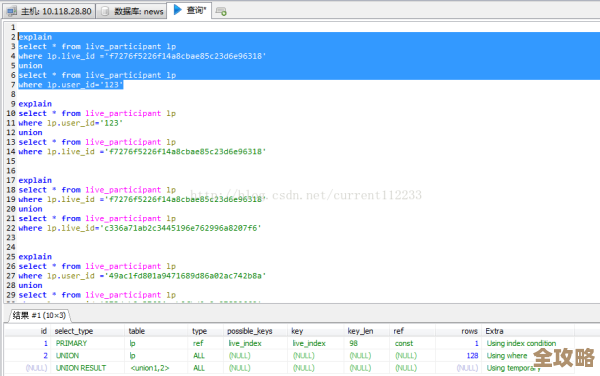

sqoop import:这是Sqoop的核心动词,表示这是一次导入操作(从数据库到HDFS)。--connect:这是最关键的参数,它指定了你要连接的“特定数据库”的地址,格式是JDBC的标准格式:jdbc:mysql://[主机名或IP]:[端口]/[数据库名],这里一定要写对,特别是数据库名(source_db),它指定了是哪个库。--username和--password:就是你的数据库登录凭证。注意点:直接在命令里写密码是明文的,有安全风险,在生产环境中,更推荐使用-P参数,这样Sqoop会提示你交互式输入密码,或者将密码保存在一个文件中,用--password-file参数指定。--table user:这指定了要导出的是source_db库里的哪张表,这里就是user表。--target-dir:指定数据导入到HDFS上的哪个目录。重要注意点:这个目录在导入前必须不存在,否则Sqoop会报错,这是为了防止误覆盖已有数据。--m 1:指定使用几个MapReduce任务来并行导入数据,数字1表示只用1个任务,适合小数据量,如果表很大,可以设置更大的数字(比如4),这样可以加快速度,但注意点:如果要用多个任务并行,就必须同时指定一个--split-by参数,选择一个能够均匀分割数据的列(通常是整数主键),Sqoop会根据这个列的值把数据分成几份,每个任务处理一份,如果没指定,Sqoop会报错。

第三步:处理可能遇到的情况和高级选项

实际工作中,我们很少会导整个表,通常会有一些筛选和转换需求。

-

只想导部分数据:可以使用

--where参数添加查询条件,只导入id大于100的用户:--where "id > 100"

或者,使用更灵活的

--query参数,写完整的SQL语句(SELECT ... FROM ... WHERE ...)。注意点:使用--query时,必须同时指定--target-dir,并且不能在SQL语句中包含WHERE $CONDITIONS,如果使用了-m参数指定多于1个并行度,则SQL中必须包含WHERE $CONDITIONS,Sqoop会自动用不同的条件替换它来实现数据分片。 -

导数据时遇到特殊字符:如果数据库表的字段内容里包含HDFS默认的字段分隔符(比如逗号、制表符),可能会造成导入到HDFS后的文件格式错乱,这时候需要用

--fields-terminated-by参数指定一个不常用的分隔符,例如\001。--fields-terminated-by '\001'

-

增量导入:如果表数据很大,而且只会新增,每次全量导入太浪费资源,Sqoop支持增量导入,常用的是

append模式,基于一个递增的列(如自增IDid)。--incremental append \ --check-column id \ --last-value 1000

这个命令的意思是,只导入

id大于1000的新数据。关键注意点:你必须自己记录下每次导入成功后最大的id值(比如1000),作为下一次导入的--last-value,不然就会漏数据或者重复导。

第四步:检查执行结果

命令执行完成后,不要以为就万事大吉了,一定要做检查。

- 看日志:Sqoop命令会在控制台输出大量日志,重点关注最后有没有

Job completed successfully这样的成功信息,如果中间有ERROR级别的日志,说明导入失败了,需要根据错误提示去排查。 - 检查HDFS:用HDFS的命令去查看一下目标目录是否生成,里面的数据文件(part-m-00000等)大小是否合理。

hadoop fs -ls /user/hive/warehouse/user hadoop fs -tail /user/hive/warehouse/user/part-m-00000

总结一下最重要的注意点:

- 驱动jar包:忘了放是最低级的错误。

- 连接信息:IP、端口、库名、表名务必准确。

- 目标目录:导入前不能存在。

- 密码安全:尽量不要在命令行明文显示。

- 并行任务:如果

-m大于1,必须指定--split-by列。 - 增量导入:妥善管理好

--last-value。

按照这些步骤和注意点,你就能比较顺利地用Sqoop从选定的数据库里导出数据了。

本文由帖慧艳于2026-01-16发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/81727.html