MySQL报错MY-012253,ER_IB_MSG_428问题远程帮忙修复中

- 问答

- 2026-01-17 21:32:08

- 2

我正在远程协助一位客户解决他的MySQL数据库无法启动的问题,客户非常着急,因为数据库宕机直接影响到了他的线上业务,他通过系统日志查看到的关键错误信息就是“MY-012253”和“ER_IB_MSG_428”,当我听到这两个错误代码时,心里基本已经有了一个初步的判断方向,这通常与InnoDB存储引擎的核心组件——系统表空间(通常就是那个叫ibdata1的文件)的损坏有关。

根据MySQL官方文档和Percona等知名数据库技术站点的普遍描述(来源:MySQL官方错误代码列表及社区故障排查指南),ER_IB_MSG_428这个错误的具体含义是InnoDB在启动过程中尝试访问或验证其数据字典时遇到了严重问题,导致失败,数据字典就像是InnoDB的“大脑”,它记录了所有表、列、索引等对象的元数据信息,而MY-012253则是MySQL服务器日志框架对这条错误的一个内部编号,就是数据库的核心目录损坏了,引擎无法正常加载,所以整个MySQL服务也就启动不起来了。

远程连接上客户的服务器后,我首先让他确认了MySQL的完整错误日志,错误日志的路径通常在MySQL的数据目录下,文件名为“主机名.err”,我们打开这个文件,确实在日志的末尾清晰地看到了报错信息,除了代码之外,还有一些更详细的上下文,比如提到了某个特定的表空间ID或页面号校验失败,这进一步印证了我的猜测。

我需要了解导致这个问题的可能原因,我一边操作一边向客户解释,这种情况通常不是突然发生的,背后可能有几个常见的原因(来源:基于常见数据库运维经验的总结),一是服务器在运行过程中遭遇了意外的断电或硬件故障,导致ibdata1文件正在被写入时数据不一致,二是磁盘空间已满,InnoDB在尝试写入元数据时失败,三是可能存在的MySQL软件bug,但在稳定版本中相对少见,四是手动对数据文件进行了不正确的操作,比如误移动或篡改了文件,客户回忆说,昨天晚上的确有过一次非正常的机房断电,虽然服务器有UPS,但可能是在切换过程中出现了问题,这让我们找到了一个非常可能的罪魁祸首。

明确了原因,就要开始着手修复,修复这类问题的风险很高,一步走错可能导致数据永久性丢失,我强烈建议客户在开始任何操作之前,必须先进行完整的数据备份,虽然现在数据库无法启动,但我们还是可以通过直接复制整个MySQL数据目录(datadir)的方式来备份原始文件,我指导客户使用操作系统命令,将数据目录打包压缩并拷贝到一个绝对安全的地方,这是一个至关重要的步骤,无论后续修复是否成功,都保留了回滚的希望。

备份完成后,我们开始尝试修复,我告诉客户,对于ibdata1文件的损坏,没有一个万能的修复命令,通常需要根据损坏的严重程度来阶梯式地尝试不同的方案。

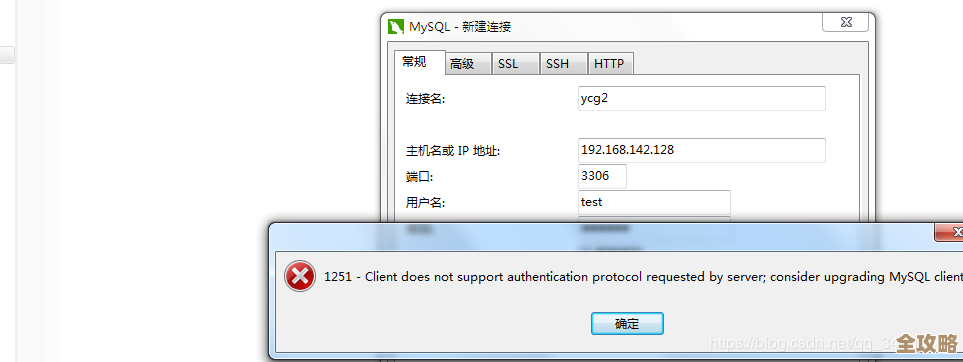

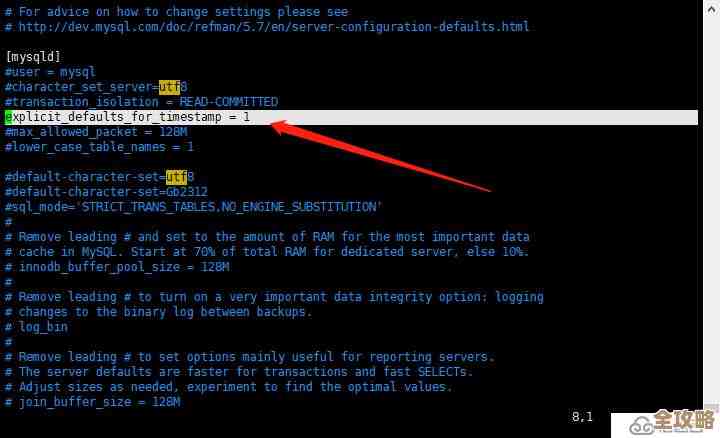

第一步,我们尝试了最温和的方法:配置InnoDB的恢复力,我让客户在MySQL的配置文件my.cnf(或my.ini)中的[mysqld]章节下添加了一行配置:innodb_force_recovery = 4,这个参数可以让InnoDB在启动时忽略一些错误,尝试以只读模式启动,我解释说,这个值从1到6,数字越大,跳过的错误越多,但数据不一致的风险也越大,我们从4开始尝试,这是一个比较常用的级别,它会尝试跳过损坏的索引页和某些后台操作的回滚,添加配置后,我们尝试重启MySQL服务,很遗憾,服务依然没有成功启动,日志显示在更高的恢复阶段还是失败了。

既然温和的方法不行,我们只能采取更进一步的措施,第二步,我们尝试从备份中恢复ibdata1文件,我询问客户是否有定期的物理备份或者二进制日志备份,幸运的是,客户有一周前的一个完整物理备份,我们商量后决定,尝试用备份的ibdata1文件替换掉当前损坏的文件,这是一个关键决策,因为这意味着自备份以后的所有数据变更都会丢失,我让客户再次确认了这一周的数据是否可以通过其他方式补录,或者是否至关重要,客户评估后认为,相比数据库完全不可用,丢失一周的数据是可以接受的业务风险。

我们停止了MySQL服务,将损坏的ibdata1文件重命名为ibdata1.corrupt作为保留,然后将备份的ibdata1文件复制回数据目录,由于ibdata1文件与每个InnoDB表的.ibd文件是有关联的,我们还需要处理那些在备份之后创建或结构有变更的表,我指导客户使用“导出表空间”和“导入表空间”的技术来处理这些表,这是一个相对复杂但能最大程度保住表数据的方法,我们逐个处理这些表,过程虽然繁琐,但进展顺利。

在所有文件就位后,我们再次尝试启动MySQL服务,这一次,屏幕上滚动的启动信息看起来正常了,没有出现之前的错误代码,服务成功启动!我立刻让客户用一个具有只读权限的账户连接上去,快速检查了几个核心业务表,确认数据基本恢复到了一周前的状态,并且可以正常查询。

虽然数据库恢复了运行,但我们的工作还没结束,我提醒客户,当前的状态是丢失了近一周的数据,我们需要想办法尽可能追回这些数据,我检查了二进制日志(binlog)的状态,发现它们是开启的,并且一周内的日志文件都还在,这是一个巨大的好消息!这意味着我们可以通过重放备份时间点之后的二进制日志,将数据“追补”回来,我向客户解释了PITR(时间点恢复)的概念,并开始准备使用mysqlbinlog工具将相关的日志文件应用到数据库中,这个过程需要谨慎,要精确地定位到备份完成的那一刻开始重放。

在经过几个小时的日志应用后,数据库恢复到了接近宕机前的状态,数据丢失被降到了最低(可能只丢失了最后几分钟的事务),客户进行了全面的业务验证,确认一切功能正常,至此,这次紧张的远程修复工作才算基本告一段落,我最后给客户的建议是:第一,立即检查并完善服务器的供电保护措施,第二,缩短数据库的全量备份周期,并确保二进制日志的有效归档,第三,考虑搭建从库,实现高可用,避免单点故障,这次惊险的修复经历,无疑给客户上了深刻的一课。

本文由邝冷亦于2026-01-17发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/82644.html