怎么在扩展分布式数据库里搞好隔离级别的优化和调整

- 问答

- 2026-01-24 00:13:12

- 1

在扩展分布式数据库时,搞好隔离级别的优化和调整是一个核心挑战,这就像在一个大型协作项目中,既要保证各个小组(数据库节点)能高效、独立地工作,又要确保他们之间的协作不会产生混乱和冲突,你不能简单地照搬单机数据库的设置,因为分布式环境引入了网络延迟、节点故障和数据分片等新问题。

要理解分布式数据库中隔离级别的本质变化。

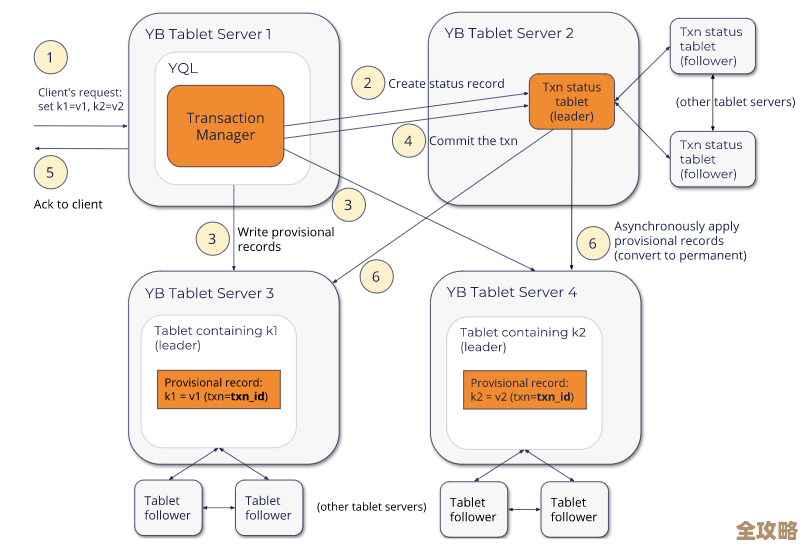

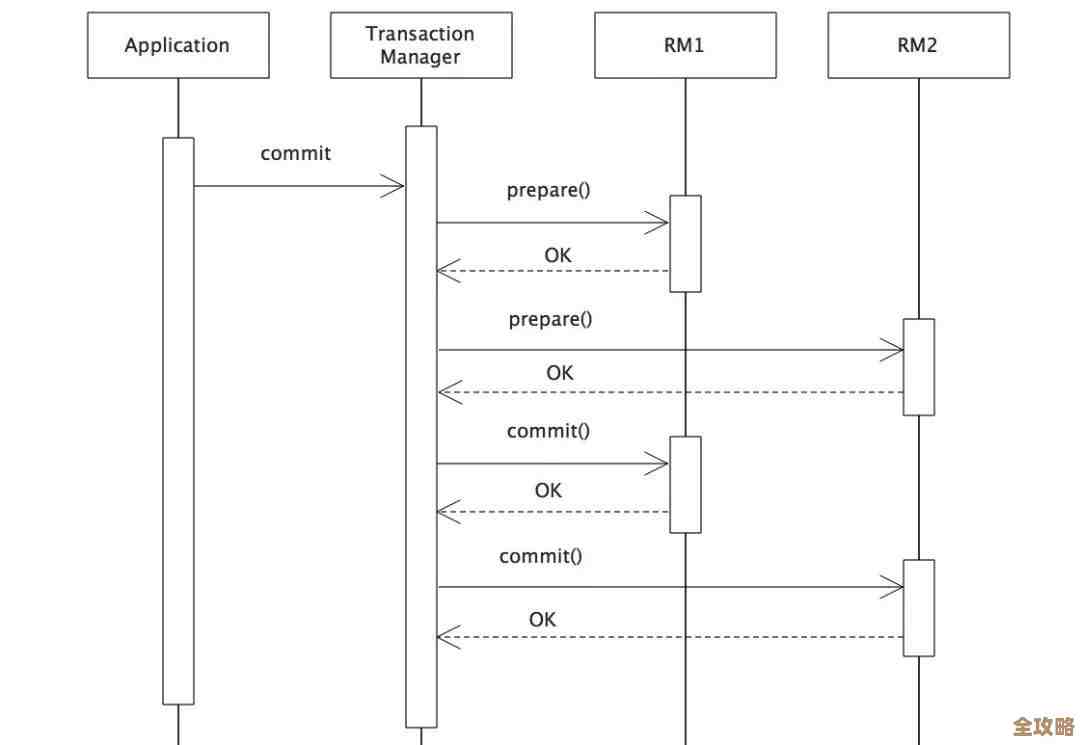

在单机数据库里,隔离级别(如读未提交、读已提交、可重复读、序列化)主要是通过锁或多版本并发控制(MVCC)等机制在单一服务器内实现的,数据都在本地,协调起来相对简单,但在分布式数据库中,数据被分割成多个部分,存储在不同的服务器(节点)上,一个事务可能涉及更新位于北京、上海和广州的三个节点上的数据,这时,要保证整个事务的隔离性,就需要这些节点之间进行大量的通信和协调,以确保所有节点对事务顺序的看法达成一致,这个协调过程会带来显著的性能开销,分布式数据库通常无法以可接受的性能代价,提供与单机数据库完全相同的、最严格的“可序列化”隔离级别,它们往往会提供一些略有弱化但性能更高的隔离级别,或者使用新的术语来描述其隔离保证。

核心的优化思路是在“数据一致性”和“系统性能/可用性”之间找到适合你业务的最佳平衡点。

这没有放之四海而皆准的方案,完全取决于你的具体应用场景能容忍什么样的异常情况,以下是几个关键的优化和调整方向:

选择最合适的隔离级别:从业务需求出发,而非技术极限。

不要一味追求最强的隔离性,你应该像挑选工具一样,根据业务场景来选择。

- 如果业务对读写一致性要求极高,不能接受任何幻读或数据回滚: 例如金融交易的核心账务系统,这时你可能需要选择数据库提供的最高级别的隔离(如某些数据库的“可序列化”或“线性一致性”),但必须清醒地认识到,这通常会以牺牲写入延迟和整体吞吐量为代价,在高并发下,事务失败(因冲突而中止)的概率会显著增加。

- 如果业务以读为主,可以接受短暂的数据不一致: 例如新闻网站的文章阅读、商品详情页展示,读已提交”甚至更弱的隔离级别可能是更好的选择,许多分布式数据库默认的隔离级别就是“读已提交”,它在性能和一致性之间取得了不错的平衡,对于读多写少的场景,可以显著提升系统的响应速度。

- 如果业务是社交媒体的点赞、评论计数: 这种对少量数据的更新,且对绝对精确性要求不高的场景,有时甚至可以考虑使用最终一致性,先更新成功,然后异步同步到其他副本,这能获得极高的性能和可用性。

(参考来源:Google Cloud Spanner 和 Amazon Aurora 的文档中都强调了根据应用模式选择隔离级别的重要性。)

巧妙利用读写分离和副本一致性级别。

分布式数据库通常有多个数据副本,你可以通过配置这些副本的一致性级别来优化读操作。

- 强一致性读: 每次读操作都要求从主副本或经过同步确认的副本读取,能获得最新的数据,但延迟较高。

- 最终一致性读: 允许从任意副本(可能是稍旧的副本)读取数据,延迟低、吞吐量高,但可能读到过时数据。

优化实践: 在你的应用程序中,可以将对数据 freshness(新鲜度)要求高的查询(如下单后查看订单详情)设置为强一致性读,而将那些对数据实时性要求不高的查询(如生成历史报表、浏览商品列表)设置为最终一致性读,从而将读请求分散到多个副本上,极大减轻主节点的压力,这种设计模式常被称为“写主读从”。

(参考来源:AWS DynamoDB 和 Azure Cosmos DB 都明确提供了可配置的一致性级别,并建议根据查询类型混合使用。)

优化事务设计,减小其影响范围和持续时间。

无论隔离级别如何,一个设计糟糕的事务都是性能杀手,在分布式环境中,这一点被放大了。

- 避免跨分片的大事务: 尽量让一个事务只在一个数据分片(节点)内完成,事务跨越的节点越多,协调成本呈指数级增长,这需要在数据分片设计(分片键选择)时就充分考虑业务事务的边界。

- 保持事务短小精悍: 尽快提交事务,不要在事务内进行网络调用、复杂的业务逻辑计算或等待用户输入,这些操作会长时间持有锁或资源,增加与其他事务冲突的概率。

- 使用重试机制: 在弱于可序列化的隔离级别下,或者即使在可序列化级别下由于冲突,事务都可能失败,在应用程序代码中必须实现健壮的重试逻辑,当事务因冲突失败时,能够自动回滚并重试整个事务流程,但重试逻辑要小心设计,避免重复提交(如支付)等副作用。

借助数据库提供的特殊机制。

现代分布式数据库提供了一些高级功能来帮助优化。

- 悲观锁与乐观锁的选择: 悲观锁(如

SELECT ... FOR UPDATE)在事务开始时即加锁,适合冲突频繁的场景,但容易导致死锁和等待,乐观锁(如基于版本号或时间戳的检查)在提交时才检查冲突,冲突少时性能极佳,你需要根据数据争用的程度来选择。 - 使用快照隔离: 很多分布式数据库基于MVCC实现了快照隔离,它为每个事务提供一个数据快照,读操作不会阻塞写操作,写操作也不会阻塞读操作,非常适合读写混合的长事务场景,虽然它不能完全防止幻读,但对很多应用来说已经足够。

(参考来源:CockroachDB 和 TiDB 这类NewSQL数据库的文档详细解释了其基于MVCC和乐观并发控制的事务模型。)

优化调整的过程是一个持续的循环:

- 分析业务场景: 明确每个操作对一致性、延迟和吞吐量的要求。

- 初始配置: 为不同的操作选择合适的隔离级别和读一致性级别。

- 压力测试与监控: 在模拟真实负载的压力下,密切监控事务中止率、延迟、吞吐量等关键指标。

- 识别瓶颈: 发现是锁冲突过多?还是网络延迟太高?或者是跨节点事务比例太大?

- 迭代优化: 根据瓶颈调整:是修改隔离级别?还是重构事务代码?或者是调整数据模型和分片策略?

最终目标不是达到理论上的最优,而是在满足业务需求的前提下,让整个分布式数据库系统能够平稳、高效地扩展。

本文由黎家于2026-01-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/84760.html