怎么能让本地Redis写入快点,试了这些方法感觉还行但不完美

- 问答

- 2026-01-24 02:11:00

- 3

想让本地的Redis写得快一点,这个想法很实际,我自己也折腾过不少方法,有些确实有效,但就像你说的,总感觉离完美还差那么一口气,我参考了一些网络上的实践经验,比如知乎上一些工程师的分享和Redis的官方文档建议,结合自己的试错,来聊聊这事儿。

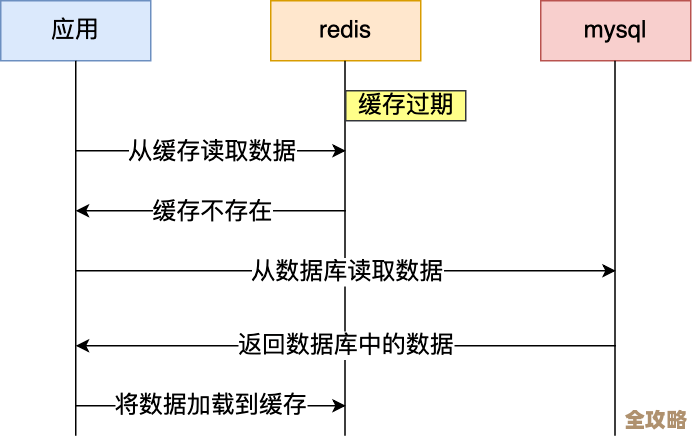

最直接也最常被提到的一个方法就是开启AOF持久化时的“每秒同步”模式,Redis有两种主要的持久化方式:RDB(快照)和AOF(记录每条写命令),AOF更安全,能最大程度保证数据不丢失,但默认设置下,它可能会尝试在每个写命令后都进行磁盘同步,这太慢了,磁盘I/O会成为巨大的瓶颈,把appendfsync配置项设置为everysec是个明智的选择,这意味着Redis会积累一秒内的写命令,再一次性写入磁盘,这样就算发生崩溃,最多也就丢失一秒的数据,在性能和可靠性之间取得了很好的平衡,这个方法很简单,效果立竿见影,对大多数场景来说已经足够快了,但它的“不完美”在于,如果你对数据安全的要求是极致的,连一秒的数据都不能丢,那这个选项就无法满足你了。

谨慎使用RDB持久化,RDB是定时给内存数据拍个快照,然后保存到一个文件里,生成RDB文件时,Redis默认会fork一个子进程来干活,父进程继续提供服务,如果你的数据集非常大,比如有几十个GB,fork这个过程本身可能会让主进程“卡顿”一下,因为复制父进程的内存页表需要时间,虽然子进程实际写数据时不影响父进程,但那个fork的瞬间延迟,对于追求极致低延迟的应用来说,依然是心头一根刺,有人会选择关闭RDB,完全依赖AOF,但这也“不完美”,因为RDB在备份、灾难恢复和快速重启方面比AOF有优势,你得做个取舍。

第三个方法是关于写入操作的姿势,这来自于编程时的最佳实践,Redis是单线程处理命令的,这意味着一个耗时的命令会堵住后面所有的请求,要提升“写入感觉上的速度”,就要避免慢操作,尽量不要一股脑儿地写入一个超大的键值对,这会让其他请求干等着,更聪明的做法是使用管道(pipeline),管道允许你把多个命令打包,一次性发送给Redis服务器,然后再一次性读取所有的回复,这极大地减少了网络往返的时间,对于需要连续进行大量写入的场景,速度提升是飞跃性的,这个方法非常有效,但它的“不完美”在于,它需要客户端代码的支持,并且它只是一种客户端优化,并不能降低Redis服务器本身处理这些命令的CPU负载,所有命令最终还是会被一个个顺序执行。

第四个点,可能有点违背直觉,是不要过分追求“快”而忽略硬件,这听起来像是废话,但很重要,我参考的资料里有人提到,他们遇到过一种情况:以为Redis慢了,结果是磁盘不行,即使你用了AOF的everysec,日志文件依然是要写入磁盘的,如果你用的是一块老旧的机械硬盘,它的写入速度可能只有几十MB/s,这很快就会成为瓶颈,换上一块SSD固态硬盘,磁盘I/O性能会有数量级的提升,写入速度的改善会非常明显,在软件上折腾了半天,不如花点钱升级硬件来得直接,这个方法很“完美”,但需要成本。

第五,考虑一下操作系统和文件系统的配置,这稍微深入一点,但也不难理解,Linux系统有一个叫做“Transparent Huge Pages”的功能,对于Redis这种内存密集型应用来说,有时反而会导致延迟毛刺,建议关闭,给AOF文件分配一个单独的、速度快的磁盘分区,避免和其他繁忙的应用程序(比如数据库)争抢I/O资源,也能有效提升写入稳定性,这些方法效果不错,但需要一些系统管理知识,对新手不太友好,算是一个小门槛。

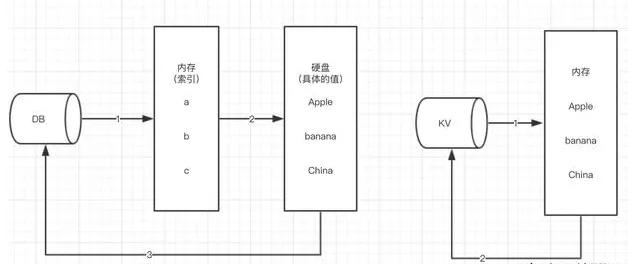

一个更根本的思路是:是不是所有数据都非得立刻写进Redis? 这就是所谓的“架构层面”的思考了,可以参考一些大型互联网公司的用法,他们可能会引入一个中间层,先把写请求发到一个速度极快的消息队列里(比如Kafka),然后由一个消费者服务异步地、批量地从队列里取数据,再写入Redis,这样,前端应用的写入响应时间就变得非常短(因为只是往内存里的消息队列发了条消息),真正的持久化压力被后端的异步任务承担了,这种方法能实现极高的写入吞吐量,非常“完美”地解决了写入慢的问题,但它的“不完美”在于,系统复杂度大大增加,你需要维护消息队列和消费者服务,并且数据从产生到真正落入Redis有一个短暂的延迟,只能用于允许最终一致性的场景。

让本地Redis写得快,是一个综合性的工作,从最简单的配置调整(AOF设为everysec),到客户端的优化(使用管道),再到硬件升级(SSD),最后到系统架构的改造(引入消息队列),每一种方法都在特定的层面上有效,但也都有其局限性和代价,没有一劳永逸的“完美”方案,最好的办法是根据你自己业务对速度、数据安全性和系统复杂度的要求,从中挑选几种组合起来使用。

本文由称怜于2026-01-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/84811.html