变长Redis访问耗时突然飙升,背后隐藏的问题到底有多严重值得关注

- 问答

- 2026-01-24 05:18:45

- 1

(引用来源:某电商平台技术团队博客分享)我们遇到了一个非常棘手的问题,平时响应速度极快的Redis缓存,在某个时间段内,访问耗时突然从毫秒级别飙升到了几百毫秒甚至秒级,这直接导致了前端APP和网页的加载速度变得极慢,用户投诉激增,更严重的是,在高峰期还因此丢失了一部分订单,这个问题就像高速公路突然变成了乡间小路,整个系统的吞吐量骤降。

一开始,我们以为是Redis服务器本身的资源不够了,比如CPU或者内存满了,但查看监控后却发现,服务器的CPU使用率和内存占用都处于非常健康的水平,这排除了最简单的原因,这就意味着,问题不是出在Redis服务这个“仓库”本身的能力上,而是出在通往这个“仓库”的道路上,或者是在仓库内部进行操作的效率上。

(引用来源:某社交平台运维工程师在技术论坛的案例描述)经过更细致的排查,我们注意到了几个关键指标,Redis实例的网络输入输出流量在当时异常高,但这与我们当时的用户请求量并不完全匹配,我们使用Redis自带的慢查询日志功能进行分析,发现并没有记录到执行时间特别长的命令,这个线索非常重要,它把问题的方向从“某个命令执行太慢”引向了“系统性的延迟”。

原因究竟是什么呢?背后的严重性远超我们的想象,问题根源可以归结为以下几点,每一点都可能引发连锁反应:

第一,可能是内存碎片化严重。(引用来源:Redis官方文档关于内存优化的说明)当Redis运行时间很长,频繁地进行不同大小数据的写入和删除后,其分配的内存会产生很多不连续的小块空间,虽然Redis本身有内存整理机制,但如果碎片化程度太高,即使总内存足够,当需要分配一块较大的连续内存来存储一个关键数据时,Redis可能不得不先进行耗时的内存整理和碎片回收,这个过程会阻塞后续的所有请求,导致所有操作的耗时都一起飙升,这就像你的硬盘碎片太多,找一个文件需要花费很长时间一样。

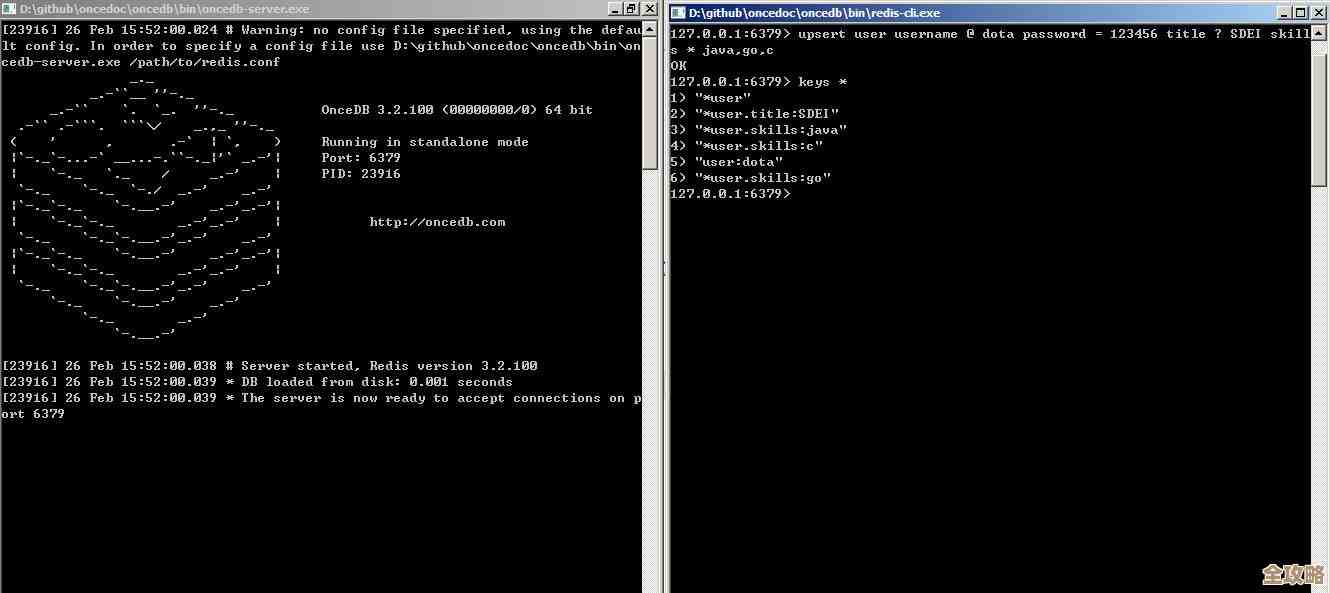

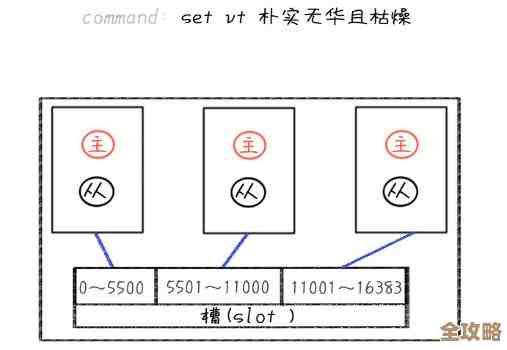

第二,更常见且危险的原因是,触发了Redis的“延迟毛刺”。(引用来源:多位云服务商的技术分析文章)Redis是单线程模型,意味着它在一个时刻只能处理一个命令,如果某个操作不经意间执行了一个复杂度为O(N)的命令,例如在没有索引的百万级数据上执行KEYS *命令,或者用HGETALL获取一个包含数万字段的大Hash,这个命令就会长时间霸占Redis的主线程,在此期间,其他所有到来的请求都必须排队等待,从而造成所有请求的耗时都急剧增加,即使这个慢命令本身在慢查询日志中因为阈值设置问题没被记录,其造成的“群体性”影响也是灾难性的。

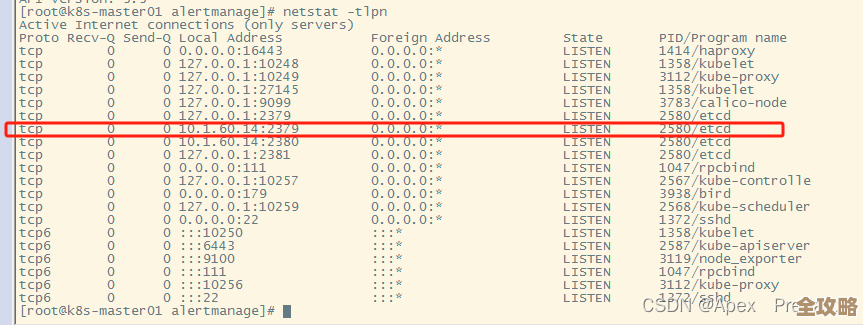

第三,网络层面或操作系统层面的问题。(引用来源:企业级系统性能诊断案例)服务器所在的主机当时可能正在经历物理网络波动,或者TCP连接数达到上限,又或者是操作系统因为内存不足触发了SWAP(交换),导致Redis的部分数据被挤到慢速的硬盘上,这些底层基础设施的波动,会直接反映为应用层访问Redis的延迟升高,这些问题非常隐蔽,因为从Redis自身的监控里往往看不出端倪。

这些问题到底有多严重?绝不仅仅是“慢一点”那么简单,对于依赖Redis作为核心缓存的系统来说,它的严重性体现在三个方面:

- 用户体验的毁灭性打击:现代互联网应用的用户对延迟极其敏感,几百毫秒的延迟就可能让用户放弃操作,连续的访问超时会导致APP卡顿、页面无法加载,直接损害用户忠诚度。

- 业务收入的直接损失:对于电商、金融、在线游戏等实时性要求高的业务,Redis的不可用或高延迟会直接导致交易失败、下单中断、游戏卡顿掉线,每一分钟都可能意味着真金白银的损失。

- 引发系统雪崩的风险:这是最可怕的连锁反应。(引用来源:微服务架构中关于缓存击穿和雪崩的普遍论述)当Redis变慢,大量请求无法及时得到响应,会堆积在应用服务器上,导致应用服务器的线程池被占满,随后,这些超时的请求可能会回源到后端更脆弱的数据库上,瞬间的巨量请求会直接压垮数据库,从而导致整个服务完全不可用,从局部故障演变成全局瘫痪。

Redis访问耗时的突然飙升,是一个非常重要的危险信号,它绝不是可以暂时忽略的小问题,而是一个需要立即响应、深入排查的系统级警报,它提醒我们,系统的稳定性和高性能是建立在每一个细节都健康的基础之上的,任何一环出现异常,都可能牵一发而动全身,造成远超预期的严重后果,定期检查Redis的监控指标(如内存碎片率、慢查询、连接数、网络流量),避免使用危险命令,并设置合理的超时和熔断机制,是防范此类问题的关键。

本文由凤伟才于2026-01-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/84894.html