Oracle数据同步老出问题,咋整才靠谱和有效的思路分享

- 问答

- 2026-01-24 17:58:16

- 2

Oracle数据同步老出问题,确实让人头疼,别急着找具体技术,咱们先捋一个靠谱的解决思路,这就像看病,得先找准病根,再开药方,不能头疼医头脚疼医脚。

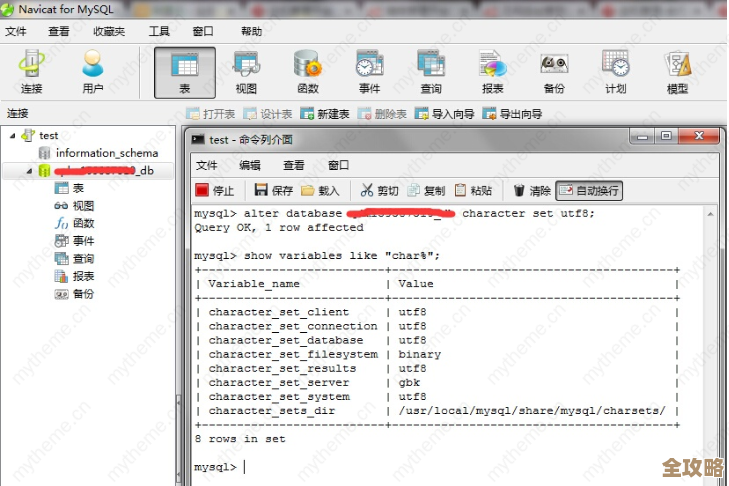

第一步:先把“病根”摸清楚,别瞎折腾 同步出问题,表现无非是数据对不上、同步延迟高、甚至直接中断,这时候,第一反应不应该是去重启服务或者胡乱调参数,你得像个侦探一样,把问题发生时的现场信息收集全。

- 记下准确时间和错误信息:什么时候开始的?报错代码或提示是什么?是源库的问题,还是目标库的问题,或者是网络抽风?

- 检查“变化”:问题发生前,有什么变动?是不是有人改了表结构(比如加了字段)?是不是数据量突然暴增(比如跑了个大报表)?是不是网络调整了?根据Oracle官方支持体系中的思路,绝大多数故障都源于“变更”。

- 分清是偶发还是常态:是突然一次,还是每天都定时发生?偶发可能是网络波动或资源瞬间抢占;常态则说明方案或配置本身有缺陷。

第二步:根据你的“家底”和“需求”,选对路子 搞清楚问题后,得看看你手里有什么牌,到底想实现什么,数据同步方法很多,没有最好的,只有最适合的。

- 如果你要的是实时性,数据量不大,且允许短时停顿:可以考虑Oracle GoldenGate,它比较成熟,对源库影响相对小,能实现准实时同步,但部署和维护需要一定技术功底,出了问题排查起来有点复杂,根据一些资深DBA的分享,GoldenGate的配置文件和参数管理是门学问,配错了就容易出幺蛾子。

- 如果你同步是为了做报表、分析,允许延迟:那用物化视图(Materialized View)可能更简单直接,设定好刷新间隔,让它定时跑,省心,但要注意,如果数据量大,刷新时可能会锁表,影响源库性能。

- 如果你只是定期把数据从一个库搬到另一个库,对实时性要求不高:用ETL工具(比如Oracle Data Integrator)或者甚至自己写可靠的存储过程+作业调度,可能更可控,逻辑自己掌握,每一步都能做检查和日志。

- 如果数据库版本够新(12c以上),且同步主要是为了容灾:一定要了解Oracle自带的Data Guard,它是在数据库级别通过传输和重做日志来同步,非常稳定可靠,但通常用于整库容灾,不太适合只要同步部分表的情况。

第三步:盯紧那些“不起眼”的角落 很多时候,问题不出在同步工具本身,而在它周围。

- 网络是最大的隐形杀手:一定要保证源库和目标库之间的网络稳定、延迟低、带宽够,同步大量数据时,网络抖动一下就可能导致超时中断,有运维专家在案例分享中强调,他们曾花大力气优化同步工具,最后发现问题根源是机房之间的专线在特定时段拥塞。

- 硬件资源要留足:同步进程本身要吃CPU和内存,写目标库更要吃IO,如果目标库的磁盘已经快满了,或者IO性能很差,同步肯定快不起来,甚至卡死,定期看看两边数据库服务器的资源使用情况。

- 别忽视日志和清理:像GoldenGate这类工具,运行过程中会产生跟踪文件和检查点信息,如果不管不顾,它们可能把磁盘撑爆,导致程序崩溃,建立定期检查和清理日志的机制。

第四步:把“监控”和“后路”准备好 别指望一次配置就能永逸,必须建立监控和应急机制。

- 做关键指标监控:不能只监控同步进程是否在运行,要监控延迟时间(数据从产生到同步完成花了多久)、数据对比差异(定期抽样核对两边关键数据是否一致),有延迟或差异,马上报警,而不是等用户发现。

- 日志一定要详细、要保存:确保同步工具的日志级别够详细,并且妥善保留一段时间,出了问题,这是你唯一的“破案线索”。

- 设计好“补数据”和“重跑”的流程:同步中断了,修复后,如何把中断期间缺失的数据补上?是手动补,还是有自动化的脚本?这个流程必须提前准备好并测试过,最怕的就是中断后,面对一堆数据缺口不知道怎么办。

- 定期做数据校验:哪怕同步正常,也建议每周或每月,对核心表做一次全量或智能比对,确保数据一致性万无一失。

最后说点实在的 Oracle数据同步是个细致活,想一劳永逸很难,靠谱的思路就是:先静下心来找准真问题,然后根据实际场景选简单够用的方案,别追求最先进的技术,把网络、硬件这些基础打牢,最后配上严格的监控和清晰的应急手册。 平时多积累,遇到报错别慌,仔细看日志,很多答案就在日志里,技术社区(如Oracle官方社区、一些靠谱的技术论坛)里有很多前辈分享的实际踩坑经验,比官方文档更“接地气”,遇到具体难题时去搜搜,往往能有启发。

把它当成一个需要持续维护和观察的系统工程,而不是一个配置完就甩手不管的工具,心态摆正了,问题就解决了一半。

本文由召安青于2026-01-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/85229.html