说说除了Redis还有啥好用的类似产品,简单对比下那些选择

- 问答

- 2025-12-23 16:01:06

- 1

说到缓存或者类似Redis这种内存数据存储,其实选择还挺多的,各有各的绝活,Redis虽然名气大,但也不是所有场合都通吃,咱们就聊聊几个常见的,用大白话讲讲它们的特点和区别。

首先一个绕不开的就是 Memcached,这个可以说是Redis的老前辈了,非常纯粹简单,它的目标就一个:当个又快又稳的分布式内存缓存,它只支持最简单的键值对,而且值只能是字符串或者二进制数据,不像Redis有列表、集合这些复杂的数据结构,正因为简单,Memcached在多核CPU上的性能表现非常极致,尤其是在只进行简单的读写操作时,有时候比Redis还要快那么一点点,但是它的功能就弱很多了,没有持久化功能(服务器一重启数据就全没了),没有主从复制,所以它就是个纯粹的“缓存”,不能当数据库用,简单总结:如果你需要一个超级简单的分布式缓存层,只做快速的键值查询,对数据丢失无所谓,那Memcached是个轻量又高效的选择,这个特点在很多技术社区的讨论里都有共识,比如一些开发者会提到“Memcached更专注于缓存场景”。

然后说说 KeyDB,这个可以看作是Redis的一个强力变种,它和Redis完全兼容,也就是说你用Redis的客户端可以直接连KeyDB,命令都一样,但它做了个大改造:Redis是单线程的(虽然新版本有改进,但核心模型还是单线程),而KeyDB是多线程的,这意味着它能更好地利用现代服务器的多核CPU性能,在高并发场景下表现可能更出色,KeyDB还原生支持“主动复制”等更高级的集群功能,简单说,如果你觉得Redis的单线程可能成为性能瓶颈,但又不想改动太多代码,想找一个性能更强的“替代品”,KeyDB是个很顺滑的升级选项,它的官网就明确标榜自己是“Redis的多线程替代品”。

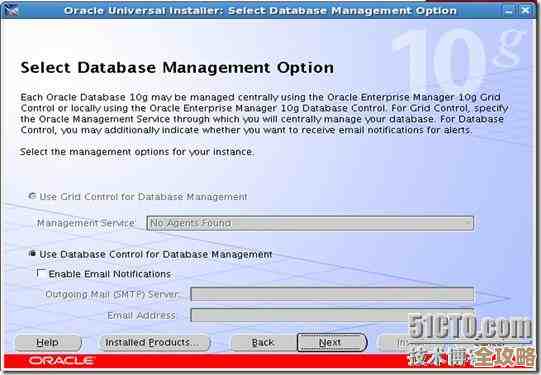

再来一个重量级的:Amazon ElastiCache for Memcached 或 Redis,这其实不是一个新的软件,而是亚马逊云(AWS)提供的托管服务,你不需要自己折腾服务器去安装、配置、维护Redis或Memcached集群,AWS都帮你搞定了,它自动处理故障转移、备份、打补丁这些麻烦事,你直接拿来用就行,按用量付费,这对于很多不想在基础设施上投入太多精力的团队来说,吸引力巨大,缺点就是会被云厂商“绑定”,而且成本可能比自己维护要高,但它的好处是省心、可靠、可扩展性强,AWS的官方文档里详细介绍了这种托管服务带来的运维负担减轻。

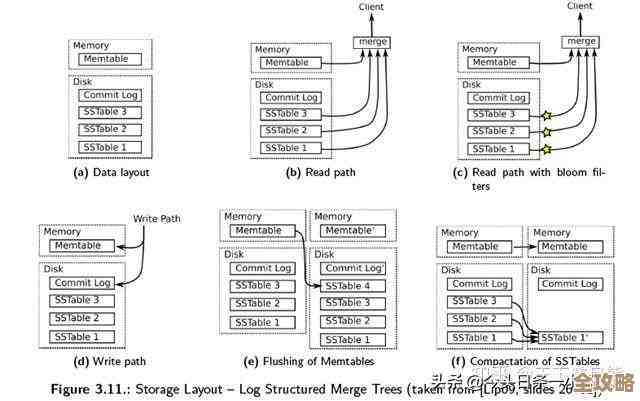

除了这几个,还有一个思路不同的产品叫 Apache Cassandra,它虽然也常被拿来比较,但定位不太一样,Cassandra本质上是一个分布式的、宽列数据库,它的设计目标是处理海量数据,并且保证高可用性和无单点故障,它也可以将数据存储在内存中以求高速,但它的数据模型和查询方式比Redis复杂得多,Redis的数据都在内存里,所以快,但容量受内存限制,Cassandra的数据主要放在硬盘上,但通过巧妙的设计也能有很好的读写性能,并且可以存储TB、PB级别的数据,简单说,当你需要处理的数据量巨大,远远超过一台服务器内存容量,同时又要求系统具备极强的可扩展性和可靠性时,Cassandra这类数据库可能比Redis更合适,在数据库领域的对比文章中,常将Cassandra视为面向超大规模数据的解决方案。

最后提一下 etcd 和 Consul,这两个和前面的区别更大一些,但它们也经常被用于需要强一致性的小数据量存储场景,比如服务发现、配置管理、分布式锁,Redis通过一些模块也能实现类似功能,但etcd和Consul是专为此设计的,它们使用Raft协议来保证集群中所有节点的数据强一致性,这是它们最大的特点,如果你的核心需求是可靠地存储一些关键配置信息,并且绝对不能出现数据错乱,那么etcd或Consul可能比Redis更专业,在云原生和微服务相关的技术讨论中,etcd和Consul是作为服务网格和协调服务的基石被频繁提及的。

总结一下:

- 追求极简缓存:选 Memcached。

- 需要丰富数据结构且兼容Redis:标准 Redis 就很好。

- 想要更强多线程性能且兼容Redis:看看 KeyDB。

- 不想自己运维:用云厂商的托管服务,Amazon ElastiCache。

- 数据量超大,追求水平扩展:考虑 Apache Cassandra 这类分布式数据库。

- 核心需求是强一致性的配置协调:专精的 etcd 或 Consul 可能更合适。

没有最好的,只有最适合你当前需求的,关键是想清楚你最需要的是单纯的快,是丰富的功能,是海量存储,还是省心的运维。

本文由盈壮于2025-12-23发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/67004.html