其实就是想说说分布式系统那些原理,怎么理解它们的运行和设计逻辑

- 问答

- 2025-12-31 22:42:48

- 3

其实想理解分布式系统,我们可以把它想象成一家大公司,而不是一个单打独斗的个体户,个体户什么都自己干,所有东西都在自己脑子里,决策快,但能力有限,万一他生病了,整个店就得关门,而大公司呢,部门众多,员工遍布各地,大家一起协作完成一个巨大的目标,分布式系统就是这样一个“大公司”,它由许多台独立的计算机(我们叫它们服务器)通过网络连接在一起,共同对外提供服务。

为什么要把简单的事情复杂化,搞这么一个“大公司”出来呢?核心目的就三个:干更大的事、不能轻易垮掉、要能长大。

干更大的事(可扩展性),双十一的淘宝,每秒要处理几十万笔订单,一台再厉害的计算机也顶不住这种压力,怎么办?那就用成千上万台普通的计算机一起扛,这就像搬一块大石头,一个人搬不动,找一百个人来,每人出一份力,就搬动了,分布式系统通过增加机器来提升整体的处理能力。

不能轻易垮掉(高可用性),如果淘宝的服务器只有一台,那这台机器一旦出故障,整个网站就瘫痪了,这是灾难性的,但在分布式系统里,一台机器宕机了,还有其他成千上万的机器在运行,服务基本不受影响,这就像大公司里一个员工请假了,他的工作可以由其他同事暂时接手,公司照常运转,这就是高可用性,目标是让服务“永远在线”。

要能长大(可扩展性,另一个角度),随着业务发展,用户越来越多,数据量越来越大,系统需要能够平滑地增加新的机器来应对增长,而不是推倒重来,一个好的分布式系统设计,应该能像搭积木一样,方便地添加新的“积木”(服务器)。

把这么多机器组织起来一起工作,会带来一系列在单机系统中不存在的问题,理解这些问题的核心,也就理解了分布式系统的设计逻辑,最关键的有以下几点:

通信不可靠: 在单机系统里,一个程序调用另一个程序,基本是瞬间完成、肯定成功的,但在分布式系统里,服务器之间通过网络通信,网络是不稳定的,消息可能会延迟、可能会丢失,甚至对方服务器可能根本就没收到,这就好比在公司里,你给另一个城市的同事发邮件,你无法确定他是否及时收到、是否会看、网络会不会中断,分布式系统里的所有组件都必须默认“通信可能会失败”,并为此设计应对机制,比如重试、超时、确认应答等。

没有全局时钟: 在单机系统里,所有操作都有一个先后顺序,因为大家共用一个时钟,但在分布式系统里,每台机器都有自己的本地时钟,这些时钟很难做到完全同步,当两笔订单几乎同时发生时,谁先谁后?如果仅凭各自机器的时间来判断,可能会产生矛盾,这就好比公司北京和纽约的办公室各自记录会议时间,如果不统一使用一个标准(比如格林威治时间),就会乱套,分布式系统中处理事件顺序是一个大难题,为此产生了像“逻辑时钟”、“向量时钟”这样的概念来部分解决这个问题。

状态不一致的风险: 为了保证高可用,重要的数据通常会在多台机器上存有副本(备份),问题来了:当需要更新数据时,如何保证所有副本都能同时、一致地更新?在网络可能延迟、机器可能故障的情况下,这极其困难,著名的“CAP原理”(来源:Eric Brewer)指出,一个分布式系统无法同时完美满足一致性(所有节点数据在同一时刻相同)、可用性(每次请求都能得到响应)、分区容错性(系统能容忍网络分区故障)这三者,必须有所取舍,这就像公司里发布一个重要通知,你希望全公司所有人(一致性)立刻都收到并确认,但可能有些人当时联系不上(网络分区),你是选择等到所有人都联系上再继续工作(牺牲可用性),还是先让能联系上的人开始执行(牺牲一致性)?不同的业务场景会做出不同的选择。

容错与恢复: 机器总会出故障,这是必然的,分布式系统的设计必须假设故障随时会发生,它需要有机制来检测故障(比如心跳检测,定期问一句“你还活着吗?”),并能自动处理故障,一旦某台机器被确认为宕机,系统要能把它负责的工作自动转移到其他健康的机器上,等它修好后再重新融入系统,这个过程要尽可能自动化,减少人工干预。

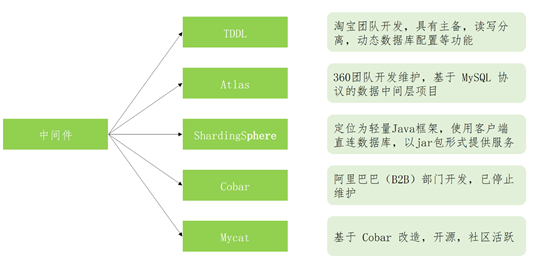

理解了这些核心挑战,再看分布式系统的各种技术和协议,比如用于协调服务的ZooKeeper、用于数据存储的HDFS、用于计算的MapReduce,你就会发现,它们本质上都是在用不同的方法解决上述一个或多个问题,它们是在“通信不可靠、无全局时钟、故障是常态”的这个残酷现实下,努力为上层应用构建一个相对“可靠、一致、可扩展”的运行环境。

分布式系统的设计和运行逻辑,其精髓不在于追求完美的理想环境,而在于在充满不确定性的现实环境中,通过巧妙的架构和算法,找到一种平衡与妥协,最终实现业务所需的可靠性、扩展性和性能,它是一场与“不完美”和“失败”共舞的艺术。

本文由召安青于2025-12-31发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/72100.html