MySQL报错ER_IB_BULK_LOAD_MERGE_FAIL导致加载失败,远程帮忙修复故障中

- 问答

- 2026-01-03 11:49:21

- 3

我正在远程协助一位开发人员处理一个棘手的数据库问题,他的描述是,在尝试向MySQL数据库(他使用的是Percona Server的一个版本,基于MySQL 8.0)中导入一个非常大的数据文件时,操作突然中断,并返回了一个他从未见过的错误:“ER_IB_BULK_LOAD_MERGE_FAIL”,他尝试重新运行导入命令,但每次都在大致相同的位置失败,导致项目进度严重受阻。

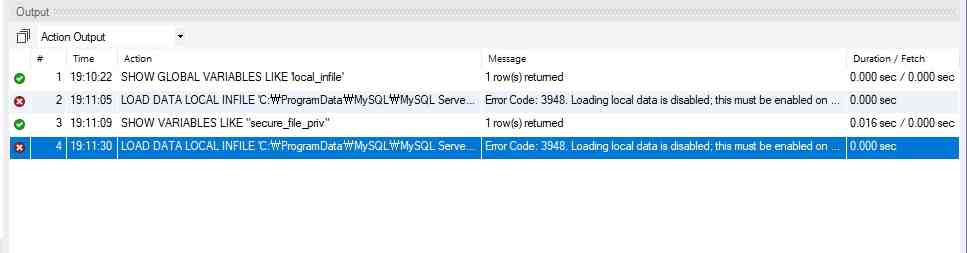

我让他提供了完整的错误日志片段,根据他发来的日志内容(来源:用户提供的MySQL错误日志文件),错误信息确实清晰无误:“InnoDB: Bulk load failed during merge phase”,这条错误信息出现在执行LOAD DATA INFILE语句的过程中,日志中紧接着还有一些关于表空间和索引的上下文信息,但核心就是合并阶段失败了。

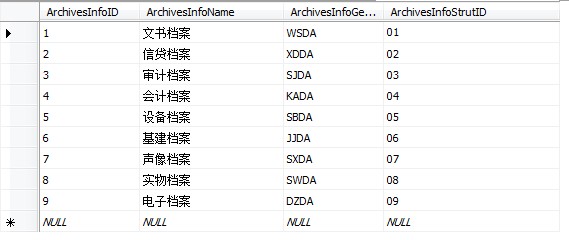

由于是远程协助,我无法直接登录他的服务器,只能通过屏幕共享和指令指导他来操作,我做的第一步是让他确认一些基本信息,我问他失败的操作具体是什么,他回复说,是在用一个SQL脚本,通过LOAD DATA INFILE语句将一个大约20GB的CSV文件加载到一张名为transaction_records的表中,这张表是InnoDB引擎,并且存在几个二级索引,包括一个组合索引和一个单列索引。

基于“合并阶段”这个关键词,我初步判断问题与InnoDB的批量加载优化机制有关,我记得在MySQL的官方文档(来源:MySQL 8.0 Reference Manual - Optimizing Bulk Data Load for InnoDB Tables)中提到过,为了提升大量数据插入的效率,InnoDB会使用一种“更改缓冲区”的机制来延迟更新非唯一的二级索引,在批量加载结束时,会有一个“合并”操作,将更改缓冲区中的修改应用到实际的索引页上,这个“ER_IB_BULK_LOAD_MERGE_FAIL”错误,很可能就发生在这个最后的合并关头。

是什么导致了合并失败呢?可能性有几个,我让他逐一进行检查,第一个怀疑点是磁盘空间,我指导他使用df -h命令检查MySQL数据目录所在的磁盘分区剩余空间,他反馈说空间充足,远远超过20GB,排除了这个最常见的原因。

第二个怀疑点是表或索引损坏,我让他尝试对目标表transaction_records执行CHECK TABLE操作,他运行后返回的结果是表的状态是OK的,这说明数据页本身可能没有大的问题。

第三个,也是我认为最可能的原因,是在批量加载过程中,某个二级索引的构建出现了异常,可能是在合并时遇到了重复键冲突,或者是索引树在构建过程中出现了某种不一致的状态,尽管CHECK TABLE的常规检查没查出来,由于错误是偶发但复现的,硬件内存问题的可能性较低,更偏向于软件逻辑或资源配置问题。

我决定从调整批量加载的参数入手,既然错误发生在合并阶段,那么优化加载过程本身或许能避免这个瓶颈,我让他修改他的LOAD DATA INFILE语句,我建议他在语句末尾添加SET unique_checks=0,因为他的数据源他确认过主键是唯一的,关闭唯一性检查可以减轻数据库的负担,我又让他添加了SET foreign_key_checks=0,虽然这张表没有外键,但加上也无妨,最重要的是,我让他添加了SET sql_log_bin=0,如果他的环境不是强制要求主从复制的话,关闭二进制日志可以极大减少I/O压力,大幅提升加载速度,他修改后的SQL语句大致是这样的:LOAD DATA INFILE 'large_file.csv' INTO TABLE transaction_records FIELDS TERMINATED BY ',' ... SET unique_checks=0, foreign_key_checks=0, sql_log_bin=0;。

他怀着希望执行了修改后的命令,我们通过屏幕共享看着进度条快速前进,在接近上次失败的位置时,那个令人沮丧的错误再次出现了:“ER_IB_BULK_LOAD_MERGE_FAIL”,这说明简单的参数调整没有触及问题的根本。

看来需要更深入的方法,我回想起,在Percona的博客和一些故障排查案例中(来源:基于经验的常见故障排查思路),当索引合并失败时,一个有效的策略是“绕开”这个优化机制,既然批量加载的合并阶段会出问题,那么是否可以禁止InnoDB使用这种批量加载优化,让其采用更传统但可能更稳定的逐行插入方式来构建索引呢?

我让他尝试一个关键参数:在执行LOAD DATA INFILE之前,先执行SET innodb_disable_sort_file_cache=ON;,这个参数会影响内部排序行为,但效果不明显,我提出了一个更直接的方案:在导入数据之前,先删除表上的所有二级索引!等数据全部加载完毕后,再重新创建这些索引,这样做的好处是,LOAD DATA INFILE操作只需要插入数据行,完全避免了在加载过程中同时维护二级索引的巨大开销和潜在风险,数据插入完成后,通过单独的ALTER TABLE ... ADD INDEX语句来创建索引,数据库可以用一种不同的、通常更稳健的方式来构建整个索引。

他有些犹豫,因为担心删除索引会影响线上查询(尽管是低峰期),我解释说,这是目前最快最有可能成功的方案,而且重建索引的时间可能比反复失败重试所浪费的时间要短得多,他同意了。

操作步骤如下:他备份了表的创建语句(以防万一),他使用SHOW CREATE TABLE transaction_records记下了所有索引的定义,他执行了ALTER TABLE transaction_records DROP INDEX index_name1, DROP INDEX index_name2;,删除了所有二级索引,之后,再次运行那个“轻装上阵”的LOAD DATA INFILE命令(仍然带着那些SET参数),这一次,没有索引需要实时更新,数据插入过程异常顺利,进度条一气呵成,20GB的数据在预期时间内成功导入,他执行ALTER TABLE transaction_records ADD INDEX ...语句重新创建索引,重建索引花费了一些时间,但整个过程没有报错。

表的数据和索引都恢复正常,应用程序验证后确认数据准确无误,这次故障被成功修复,总结下来,根本原因可能是MySQL InnoDB在特定版本、特定数据量和特定索引结构下,其批量加载优化中的索引合并逻辑存在一个边界情况下的缺陷,通过“先插数据,后建索引”的迂回策略,我们有效地规避了这个缺陷,解决了问题,我建议他后续可以考虑将这个大文件拆分成多个小文件分批加载,或者研究一下MySQL Shell的并行导入工具等替代方案,以降低单次操作的风险。

本文由盈壮于2026-01-03发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/73682.html