用Redis队列来搞批量删数据,效率和策略怎么安排比较好呢

- 问答

- 2026-01-07 08:37:19

- 2

关于如何使用Redis队列来高效、策略性地进行批量数据删除,核心思想是把一个庞大且耗时的删除任务,从“一次性硬扛”转变为“细水长流地消化”,这就像搬家,与其叫一帮朋友一口气把所有东西从六楼搬下来累个半死,不如利用传送带或者小推车,一批一批、有条不紊地运送,既能避免把系统“累垮”,也能随时控制节奏。

为什么用队列?解决什么问题?

直接进行大规模删除,比如在数据库里执行一个DELETE FROM huge_table WHERE condition,或者在Redis里用KEYS模式匹配后一次性删除,会带来几个严重问题:

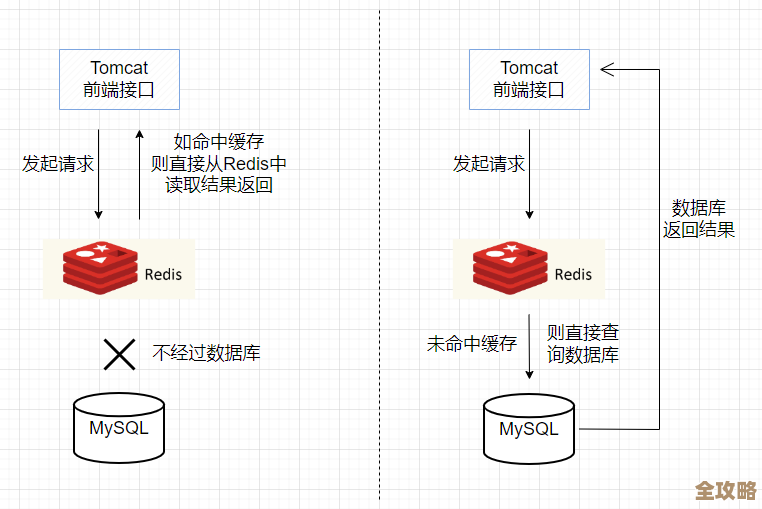

- 数据库/Redis瞬时压力巨大:大量的删除操作会瞬间占用极高的CPU和I/O资源,可能导致正常业务请求被阻塞,服务响应变慢甚至超时,引用自《Redis实战》中的观点,类似

KEYS这样的命令在生产环境要绝对避免,因为它会阻塞服务器。 - 长事务风险:对于关系型数据库,一个超长的事务可能会填满事务日志,并长时间锁住一些数据行,影响并发。

- 不可中断性:一旦开始,很难中途停止,如果删除到一半发现条件有误,或者需要优先保障其他业务,很难优雅地中断和恢复。

而引入Redis队列,就是把要删除的“目标清单”本身先准备好,而不是立刻执行,这个过程可以概括为“生产”和“消费”两个阶段。

策略安排:如何“生产”和“消费”

生产阶段:生成待删除的任务清单

这个阶段的目标是,精准、高效地找出所有需要被删除的数据标识(比如数据库的主键ID、Redis的Key等),并放入一个Redis的列表(List)或流(Stream)中。

- 策略选择:

- 分批扫描源数据:不要用

SELECT * FROM table WHERE condition一次性把所有ID捞出来,这会给数据库造成压力,应该使用分页查询,比如SELECT id FROM table WHERE condition LIMIT 1000 OFFSET 0,然后OFFSET 1000,再OFFSET 2000……这样一批批地获取ID,这样对源数据库的压力是可控的。 - 直接写入队列:每扫描出一批ID(比如1000个),就立即使用Redis的

LPUSH或XADD命令,将它们作为一个任务单元放入队列,确保生产数据的过程本身不会压垮任何系统。 - 信息存储:队列里放什么?最好不要只放一个ID,而是放一个简单的JSON字符串,包含更丰富的信息,例如

{"type": "user", "id": 12345, "action": "delete"},这样消费端拿到后,能清楚地知道要删除什么类型的对象,从哪里删,逻辑更清晰,便于后续扩展。

- 分批扫描源数据:不要用

消费阶段:从队列中取出并执行删除

这是核心环节,重点在于如何控制消费速度,做到高效且不影响主业。

- 策略选择:

- 使用多消费者(Worker):这是提高效率的关键,可以启动多个独立的进程或线程(统称为Worker),同时从Redis队列中获取任务并执行删除,这就像开了多条传送带同时搬家,速度自然快,Redis的列表是线程安全的,多个消费者同时操作不会有问题,可以使用

BRPOP(阻塞式弹出)命令,这样Worker在队列为空时会自动休眠,避免空转消耗CPU。 - 控制消费速率(限流):这是保证系统稳定的生命线,不能任由Worker全速删除,必须对消费速度进行限制。

- 简单限流:在Worker代码中,每处理完一个任务后,让线程睡眠一小段时间,比如

time.sleep(0.1),表示每秒最多处理10个任务,可以根据对数据库/Redis的监控指标来调整这个睡眠时间。 - 令牌桶等高级限流:如果需要更精确的控制,可以实现一个令牌桶算法,保证无论有多少Worker,每秒能拿到的令牌数是固定的,从而严格控制总体删除速率。

- 简单限流:在Worker代码中,每处理完一个任务后,让线程睡眠一小段时间,比如

- 错峰执行:将消费进程安排在业务低峰期(例如凌晨)运行,最大限度地减少对线上服务的影响,这是最直接有效的策略。

- 失败重试机制:网络抖动或临时性故障可能导致某个删除失败,对于失败的任务,不应直接丢弃,而应将其放入另一个“死信队列”(Dead-Letter Queue)中,之后可以有一个单独的进程来分析和重试这些失败的任务,确保数据最终能被清理掉。

- 使用多消费者(Worker):这是提高效率的关键,可以启动多个独立的进程或线程(统称为Worker),同时从Redis队列中获取任务并执行删除,这就像开了多条传送带同时搬家,速度自然快,Redis的列表是线程安全的,多个消费者同时操作不会有问题,可以使用

一个具体的效率优化例子

假设要删除一亿条用户日志。

- 糟糕的做法:

DELETE FROM logs WHERE create_time < '2023-01-01';数据库可能直接“死”给你看。 - 采用Redis队列的优化做法:

- 生产:一个脚本在凌晨低峰期,分页扫描日志表(每次取5000条ID),将ID列表写入Redis的

log:delete:queue,这个过程可能持续几个小时,但对数据库压力很小。 - 消费:启动5个Worker进程,每个进程循环从

log:delete:queue中用BRPOP取任务,每个Worker每删除完一条记录,休息0.05秒(每秒最多删除20条),那么5个Worker合计每秒删除约100条。 - 效率计算:一亿条数据,以每秒100条的速度删除,大约需要 1,000,000秒 ≈ 11.5天,这个时间看起来长,但它是“无感”的,是在后台平稳进行的,完全不影响白天高峰期的正常业务,如果你觉得太慢,可以在业务允许的情况下,增加Worker数量或减少休息时间,比如将速率提升到每秒500条,那么总时间就缩短到约2.3天。

- 生产:一个脚本在凌晨低峰期,分页扫描日志表(每次取5000条ID),将ID列表写入Redis的

总结与要点

用Redis队列做批量删除,效率不是指“秒完”,而是指“在对系统造成最小影响的前提下,稳定可靠地完成”,策略安排的核心就是 “分解、缓冲、限流、异步”。

- 分解:将大任务拆成小任务。

- 缓冲:用Redis队列作为缓冲区,解耦生产者和消费者。

- 限流:严格控制消费者速度,充当“油门踏板”。

- 异步:删除操作与主业务逻辑分离。

这种模式非常灵活,你可以通过调整Worker数量和控制休眠时间这两个“旋钮”,非常精细地控制删除任务对现有系统的压力,实现真正的平滑删除,引用自常见的系统设计原则,这本质上是背压(Backpressure)机制的一种应用,即当下游(删除操作)处理不过来时,上游(任务生产)或自身(消费速率)会慢下来,避免系统被冲垮。

本文由水靖荷于2026-01-07发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/76095.html