Redis资源池释放出问题了,导致资源没法正常回收,引起一堆疑问和麻烦

- 问答

- 2026-01-14 03:14:19

- 7

Redis资源池释放出问题了,导致资源没法正常回收,这事儿可真不是一般的麻烦,它不像那种界面卡了一下或者某个功能突然用不了那么明显,能让你立刻发现并着手解决,这个问题是藏在系统深处的,像一根血管慢慢渗血,一开始你可能完全感觉不到,但等系统开始喊疼、出现各种稀奇古怪的症状时,往往已经造成了一堆烂摊子,收拾起来特别费劲。

最开始的迹象可能非常隐蔽,有同事在测试环境跑一个平时没啥问题的批处理任务,发现运行速度越来越慢,最后干脆超时失败了,重启一下应用,嘿,又正常了,大家一开始的反应通常是:“是不是测试环境机器不行?”“是不是数据库压力大了?”很少有人会第一时间想到是Redis连接池的事儿,因为Redis本身给人的印象就是飞快、稳定,谁会怀疑它呢?这种误判就浪费了最初的排查时间。

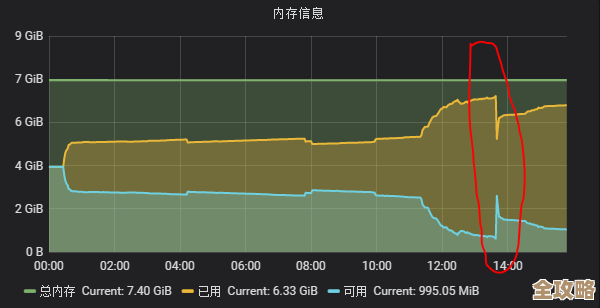

随着时间推移,问题会逐渐浮出水面,变得无法忽视,应用日志里开始零星出现一些“获取连接超时”的警告,一开始可能几分钟一次,后来变成几十秒一次,负责运维的同学可能会发现,服务器上Redis的客户端连接数在缓慢但持续地增长,即使是在半夜业务低峰期,连接数也只增不减,画出来的曲线图像个只上不下的楼梯,这时候,大家才真正紧张起来,意识到不是偶尔的网络抖动,而是有连接确实“漏”了,没有被还回池子里。

麻烦就麻烦在,定位这个“泄漏点”极其困难,一个稍微复杂点的应用,会在成百上千个地方使用Redis:用户登录会话存一下、商品信息缓存一下、消息队列用一下、甚至某个页面上的小图标也缓存一下,到底是哪个环节出了岔子?是哪个程序员在写某段业务逻辑时,只记得欢天喜地地从池子里借走连接,却忘了在finally块里写上归还的代码?还是说,在处理一个复杂事务时,某个异常分支没有覆盖到,导致归还连接的代码被跳过了?又或者是用了某个第三方库,它对资源释放的处理方式和我们预期的不一样?

为了找到根源,团队不得不投入大量人力,开发人员要像侦探一样,一遍遍 Review 涉及Redis操作的代码;运维人员则要不停地盯着监控大盘,试图找到连接数暴涨和哪个业务接口的调用峰值在时间上吻合,这个过程非常磨人,因为问题可能只在特定条件下触发,比如只有某种类型的用户执行某个特定操作时才会发生,这期间,为了避免连接被彻底耗尽导致服务完全不可用,可能还需要定时重启应用服务来强制释放连接,但这完全是治标不治本,而且重启本身也会影响线上用户的体验。

当终于找到问题代码时,那种心情往往是既庆幸又恼火,庆幸的是问题终于找到了;恼火的是,原因可能非常简单,可能就是少写了一行代码,或者一个不起眼的逻辑错误,但就是这么一个小疏忽,却引发了连锁反应。

更深远的影响在于,这件事会动摇团队对系统稳定性的信心,以后每次系统出现一点性能波动,大家心里都会犯嘀咕:“是不是资源池又漏了?” 它还会引发一系列后续的疑问和检讨:我们的代码审查流程是不是不够严格?为什么这样的bug能进入到生产环境?我们的监控报警是不是做得太滞后了,能不能在连接数刚开始异常增长时就发出警报?是否需要引入更严格的资源管理规范,或者使用一些能自动检测资源泄漏的工具?

别看只是一个资源池释放的小毛病,它就像堤坝上的一个蚁穴,短时间内看不出啥,但任由发展,足以引发一场让整个技术团队焦头烂额的“洪水”,它消耗的不仅是服务器资源,更是开发、运维人员大量的时间和精力,以及对系统可靠性的信任感,解决它,远不止是修复一行代码那么简单,往往伴随着一场对开发习惯、运维体系和监控手段的深刻反思。

本文由凤伟才于2026-01-14发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/80308.html