系统负载突然变化时,如何快速应对和有效管控的实用方法分享

- 问答

- 2026-01-15 01:01:25

- 1

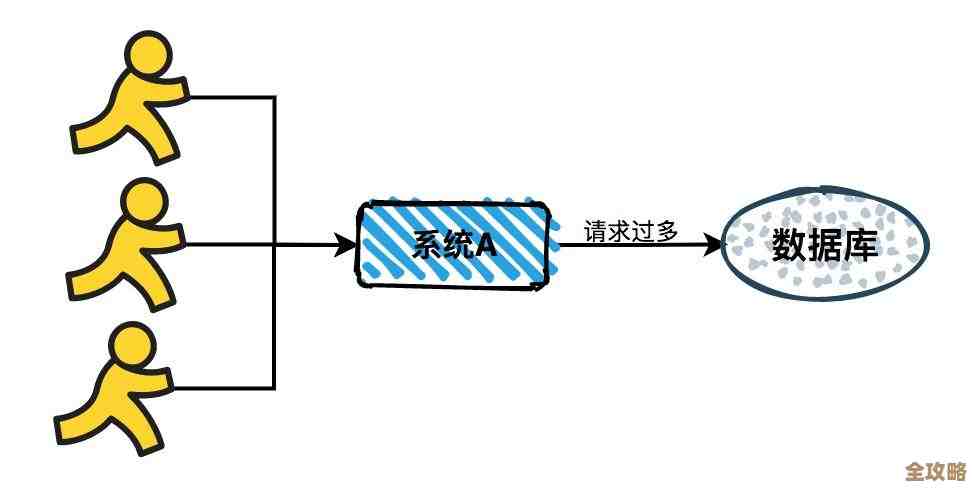

当系统的访问量或处理任务量突然间猛增或骤降,就像一条原本平静的公路突然涌入大量车流,或者车流瞬间消失,这对系统的稳定运行是个巨大的挑战,要快速应对和有效管控这种情况,不能只靠临时抱佛脚,需要一个从准备、发现、应对到复盘的全套方法。

第一,提前准备,打好地基是核心。

俗话说,“养兵千日,用兵一时”,应对突发负载,功夫大多下在平时。

-

建立监控告警的“瞭望塔”:你必须时刻知道你的系统“健康状况”,这需要建立一套完善的监控系统,关键指标要像汽车仪表盘一样一目了然,核心指标包括:CPU使用率(像电脑的脑子有多忙)、内存使用量(像临时工作台用了多少)、磁盘读写速度(像仓库进货出货的速度)、网络流量(像公路上的车流量)以及对于网站或应用特别重要的应用层指标,如每秒请求数、请求响应时间、错误率等,为这些指标设置合理的告警阈值,一旦超过正常范围,系统能立即通过短信、电话、钉钉或企业微信等渠道通知到负责人,这是争取宝贵应对时间的第一步,这个方法在阿里巴巴的运维实践中被反复强调,监控是发现问题的眼睛。

-

进行常态化的压力测试:不要等到“双十一”那天才知道系统能扛住多少人,要定期对系统进行压力测试,模拟大量用户同时访问,摸清系统的性能瓶颈在哪里,最大承载能力是多少,知道了系统的“天花板”,当流量真的来袭时,你心里才有底,这就像消防演习,平时多演练,真着火时才不会慌乱。

-

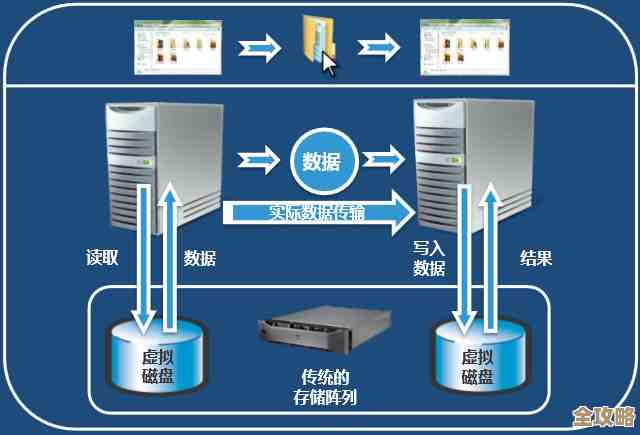

设计弹性伸缩的架构:这是应对负载波动的“自动驾驶”模式,利用云计算的弹性伸缩能力,可以设定规则,当CPU使用率持续高于70%时,自动增加服务器实例;当负载降下来后,再自动减少实例,这样既能顶住流量高峰,又能在平时节约成本,亚马逊AWS和阿里云等云服务商都提供了成熟的产品,关键在于提前做好应用的无状态化改造,让服务器可以像乐高积木一样随时增减。

第二,快速发现,争分夺秒是关键。

当负载真的突然变化时,早一秒发现就意味着早一秒解决,可能就避免了一次严重的故障。

-

告警的“战时”响应:一旦收到告警,必须立即响应,团队需要有一个清晰的应急预案和分工流程,谁负责看监控图表?谁负责登录服务器排查?谁负责对外沟通?这些都要在平时约定好,避免故障发生时,一群人像无头苍蝇一样,在群里七嘴八舌却没有行动。

-

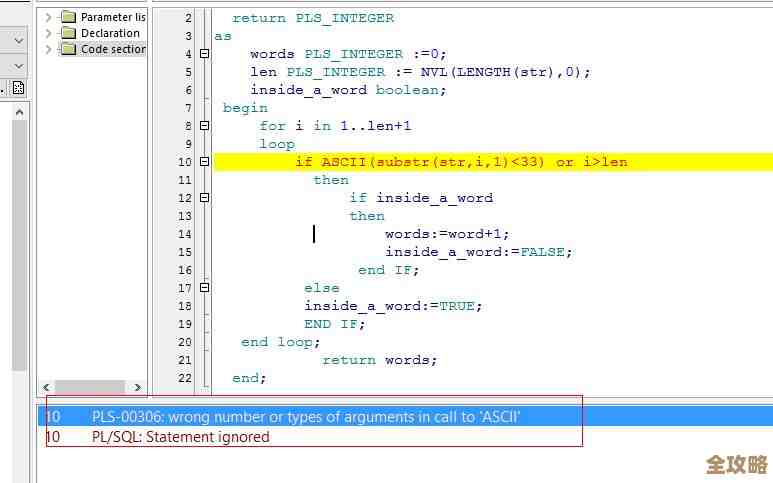

快速定位问题根源:收到“系统响应慢”的告警后,不能盲目行动,要顺着监控指标的线索,像侦探一样快速定位瓶颈,是数据库的查询慢了?还是某个后台任务占用了大量CPU?或者是网络带宽被打满了?使用一些简单的命令行工具(如Linux下的top, iostat, netstat)或更高级的APM(应用性能管理)工具,可以快速帮你找到问题的源头,谷歌在《Site Reliability Engineering》(站点可靠性工程)一书中指出,明确问题影响范围和根源是应急处理的首要步骤。

第三,果断应对,先止血再疗伤。

找到问题后,要采取果断但有序的措施,优先恢复服务,而不是追求完美解决。

-

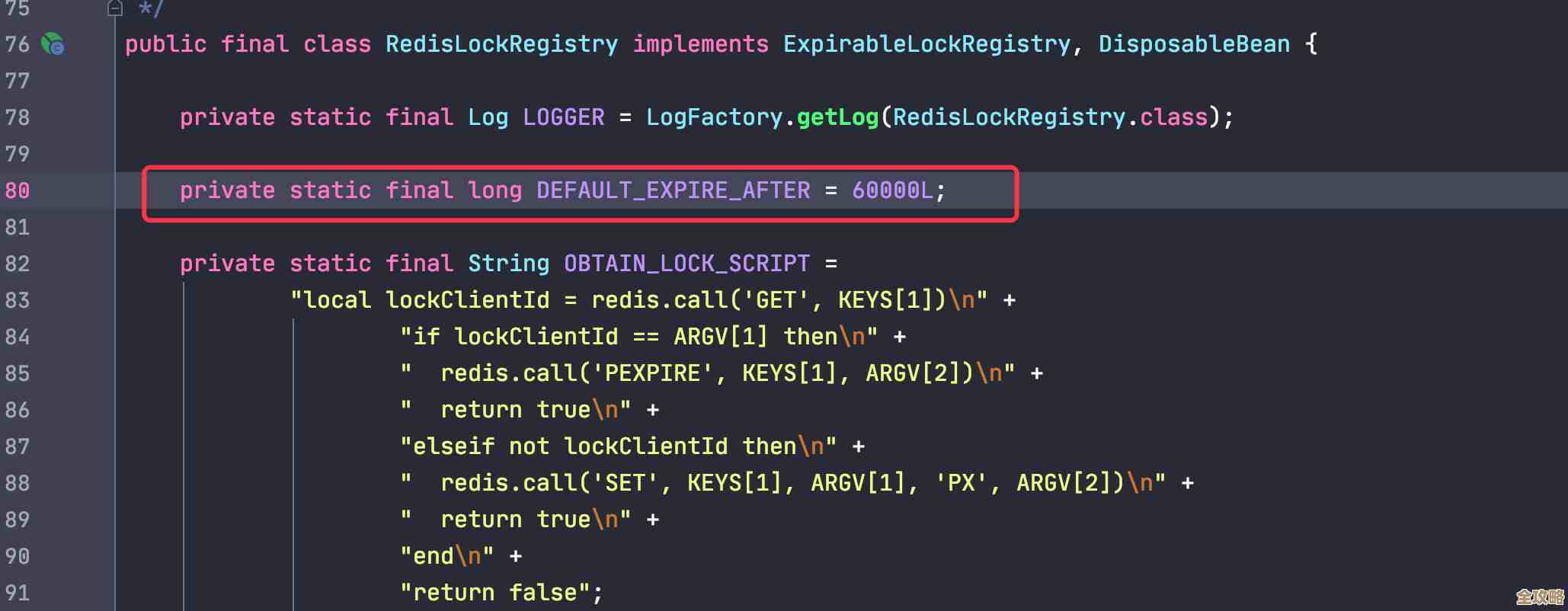

“限流”与“降级”:保护系统的两道保险:

- 限流:当流量超过系统处理能力时,果断拒绝部分请求,好比银行在人多时发放排队号码,满了就停止发号,保证厅内客户能得到服务,这虽然会影响一部分用户,但保护了整个系统不崩溃,让大部分用户还能正常使用,这是一个非常有效的临时措施。

- 降级:暂时关闭系统中一些不重要的功能,把有限的资源保障核心业务流程,在购物高峰时,可以暂时关闭商品评论、推荐列表等非核心功能,全力保障用户登录、浏览商品、下单支付的流程畅通,这就像船要沉了,先把不必要的货物扔下水,保证船不沉。

-

扩容与重启:如果条件允许,最快的方法就是增加资源,立即执行弹性伸缩策略,增加服务器实例,对于一些因为程序bug导致内存泄漏、CPU飙高的问题,有时候快速重启相关服务也能立即缓解症状,为彻底修复争取时间。

-

有效沟通:在应对过程中,一定要有专人负责对内和对外的沟通,对内,让所有相关同事清楚故障现象、处理进展;对外,通过公告、站内信等方式告知用户当前系统正在面临压力,正在紧急修复,安抚用户情绪,透明化的沟通能赢得理解,避免谣言和更大的负面影响。

第四,事后复盘,吃一堑长一智。

故障处理完,服务恢复正常,但工作远未结束,最重要的环节是复盘。

- 召开复盘会议:召集所有相关人员,在抛开追责的氛围下,客观回顾整个事件。 timeline(时间线)是怎样的?我们是怎么发现的?应对措施是否有效?哪里可以做得更好?

- 撰写故障报告:详细记录故障的根本原因、影响范围、处理过程、经验教训以及后续的改进项,这份报告不是“检讨书”,而是宝贵的知识库。

- 落实改进措施:复盘的关键在于行动,是代码bug就要修复,是架构缺陷就要优化,是流程问题就要完善预案,确保每一个重大的负载变化事件,都能让系统变得比以前更健壮,腾讯等互联网公司普遍实行的“蓝军”演练,就是通过模拟故障来不断检验和优化这套应对机制。

应对系统负载突变,是一个系统性工程,它考验的不仅是技术,更是团队的准备程度、协作效率和持续改进的能力,通过“平时重建设、战时快响应、事后深复盘”的闭环管理,才能让系统在风云变幻的流量面前,始终保持韧性和稳定。

本文由酒紫萱于2026-01-15发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/80863.html