用Redis来搞统计命中率,感觉效率能蹭蹭往上涨,数据查找更快了

- 问答

- 2026-01-15 05:42:43

- 4

行,那咱们就直接聊聊怎么用Redis来搞统计命中率这事儿,一说起统计,尤其是那种要高频率记录、实时查看的数据,比如网页的点击量、广告被点了多少次、或者某个功能模块的使用情况,传统做法经常是“来一次请求,就往数据库里插一条记录”,听着挺合理对吧?但一旦量大了,比如一秒来个几千上万次请求,数据库可能就扛不住了,写入速度跟不上,查询起来更是慢得像蜗牛,整个系统的效率立马就掉下来了。

这时候Redis的优势就显出来了,Redis这东西,它把数据都放在内存里捣鼓,读写速度飞快,比去硬盘里翻来翻去的数据库操作快了几个数量级,用它来做统计,特别是那种“计数”型的统计,简直就是量身定做,你想想,统计命中率,核心不就是计数吗?总共请求了多少次,命中了多少次,两个数一比,命中率就出来了。

那具体怎么个搞法呢?思路其实特别直接,比方说,我们要统计一个缓存系统的命中率,你可以给每个需要统计的对象(比如一个缓存键前缀,或者一个API接口)在Redis里设置两个简单的键,一个就叫它 total_requests:your_key ,用来记录总的请求次数;另一个叫 hits:your_key ,专门记录命中的次数,每次有请求来了,第一步,先通过 INCR 命令把 total_requests:your_key 这个键的值加1,这个 INCR 是原子操作,意思是哪怕一万个请求同时来给它加1,也不会出错,最后肯定是个准确的数,这在高并发环境下太关键了,你去查缓存,如果发现想要的数据在缓存里(这就是命中了),好,那就再用 INCR 命令把 hits:your_key 这个键的值也加1。

这样一来,所有的计数工作都在内存里瞬间完成了,对后端的数据库几乎没压力,等你需要看命中率的时候,比如每隔5分钟或者每小时要汇总一次,你就用Redis的 GET 命令,分别取出 hits:your_key 和 total_requests:your_key 的值,假设命中数是 hits,总请求数是 total,那么命中率就是 (hits / total) * 100%,这个计算过程非常简单,可以在应用层瞬间完成。

你看,整个过程,频繁的写入操作(计数)由Redis高速承接,而最终的计算只是两次简单的读取和一次除法,这比每发生一次事件都去写一次数据库,然后还要用复杂的SQL语句去COUNT来COUNT去,效率不知道高到哪里去了,数据查找能不快吗?感觉效率蹭蹭往上涨,真不是吹的。

这里说的是基本思路,实际用的时候,还能玩出更多花样,让效率和准确性更高,为了避免这两个计数键(总请求和命中数)不同步,我们可以利用Redis的管道(pipeline)功能,管道可以把好几个命令打包,一次性发给Redis服务器,减少网络来回通信的次数,在一个请求处理逻辑里,我们可以先把 INCR total_requests:your_key 和判断是否命中的逻辑准备好,如果命中,就把 INCR hits:your_key 也打包进管道,一起执行,这样既保证了速度,又在很大程度上确保了数据的一致性。

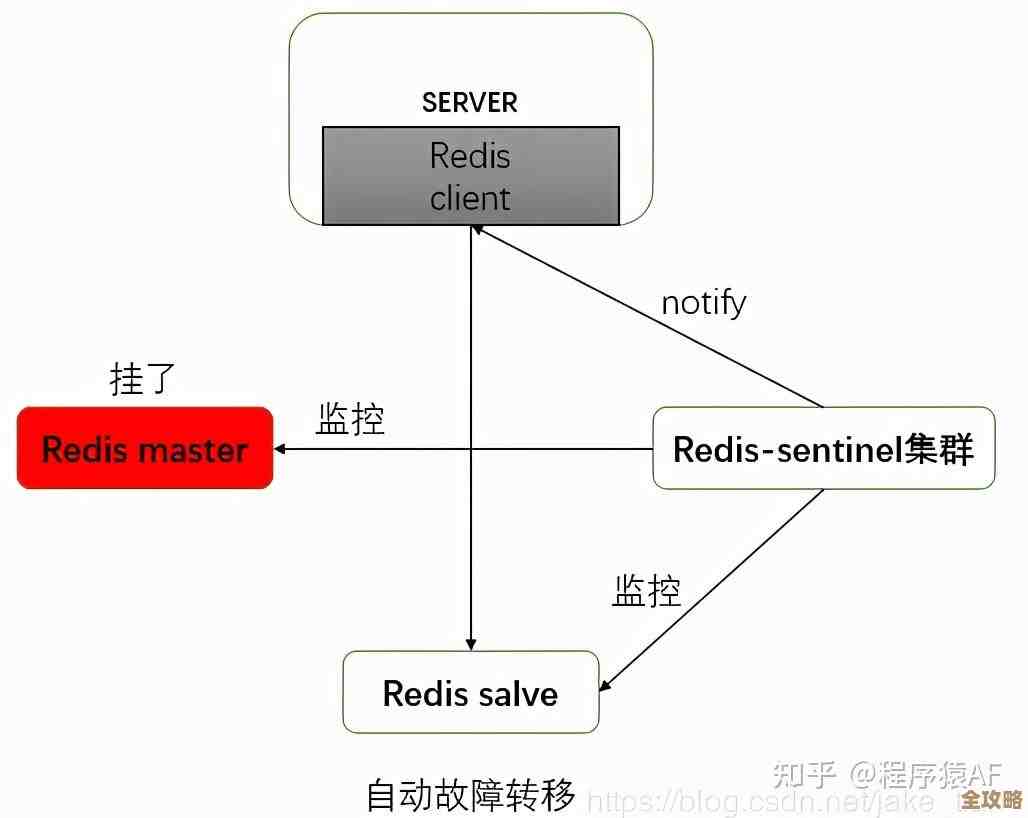

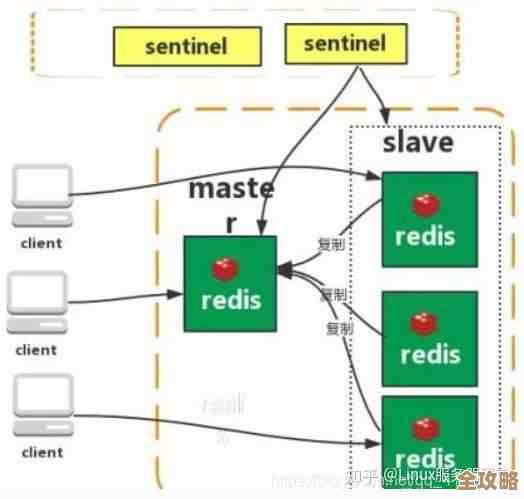

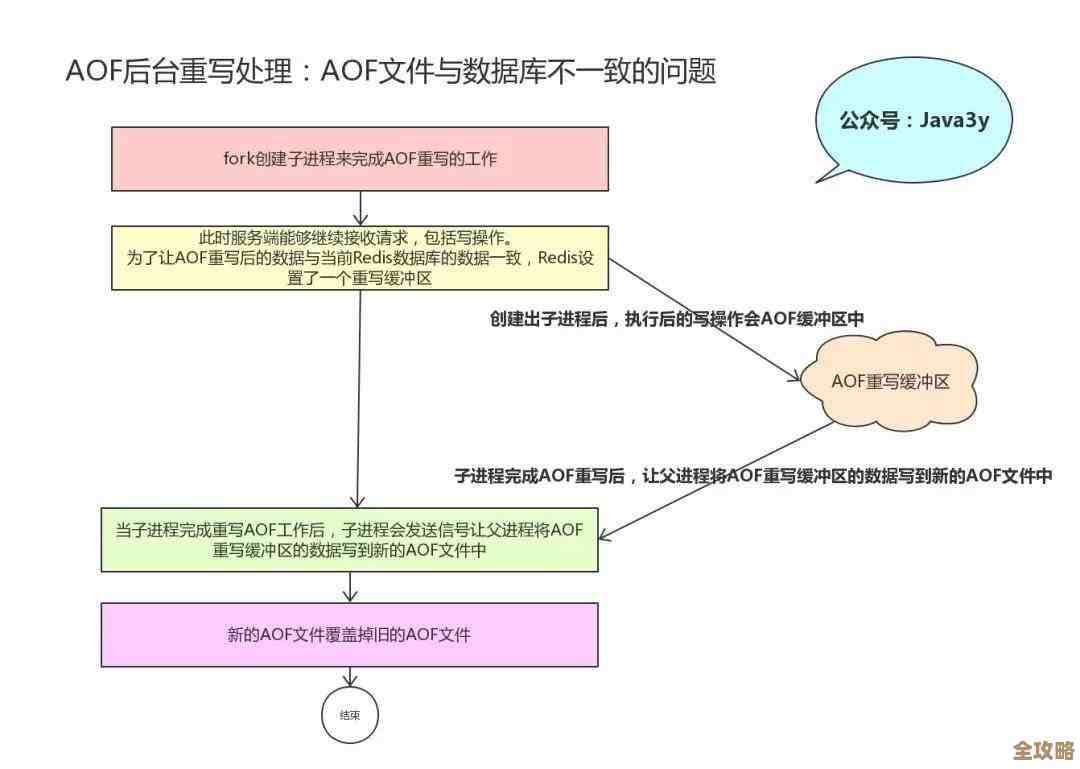

还有一点,Redis虽然快,但数据都在内存里,你得想着万一Redis服务重启了,数据不能丢啊,所以通常需要配置持久化机制,比如RDB快照或者AOF日志,定期把内存里的数据备份到硬盘上,这样就算重启,也能从硬盘恢复数据,保证统计结果不会全丢,不过持久化策略要根据实际情况来定,如果对一两分钟的数据丢失不那么敏感,可以配置成每隔一段时间存一次,这样对性能影响最小。

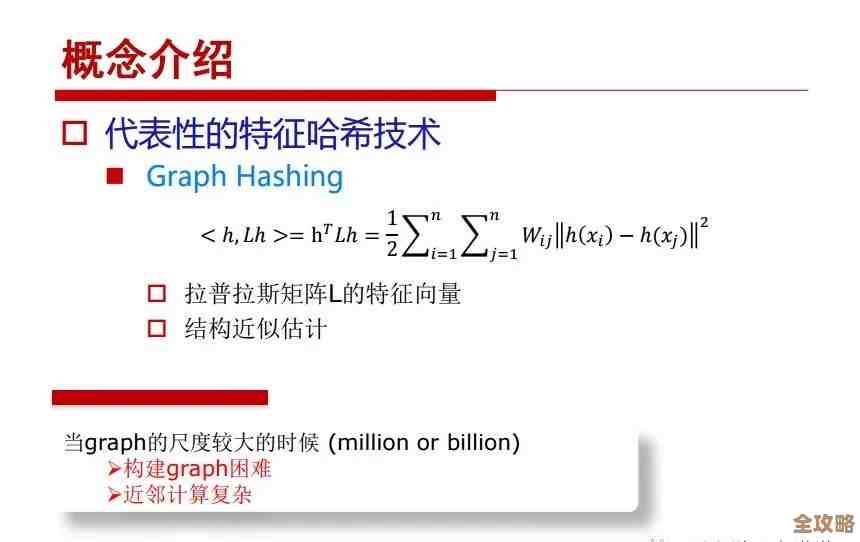

如果统计的维度特别多,比如要给成千上万个不同的商品分别统计点击率,那就会创建出大量的键,这时候要注意给Redis设置合理的内存大小,并可能需要对旧数据进行归档清理,也可以考虑使用Redis的哈希(Hash)结构,把一个主题下的多个计数器放在同一个哈希里,稍微节省一点内存开销。

用Redis搞命中率统计,其高效性主要就体现在:用内存操作应对高频写入,用原子命令保证计数准确,用简单的键值读取替代复杂查询,这把原本可能是系统瓶颈的统计环节,变成了一个轻松高效的事情,自然就让整个应用的数据查找和响应速度都跟着快了起来,这种方案对于需要实时监控、快速响应的业务场景来说,性价比非常高。

本文由钊智敏于2026-01-15发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/80987.html