Redis运维那些事儿,怎么才能既高效又稳妥地搞定框架问题

- 问答

- 2026-01-18 01:53:20

- 1

说到Redis运维,很多刚开始接触的朋友可能会觉得头大,感觉这东西虽然快,但动不动就出点幺蛾子,不是内存满了就是响应变慢了,搞不好还会丢数据,其实吧,想把Redis用得既高效又稳妥,没那么玄乎,关键是把一些常见的“坑”提前踩明白,然后准备好应对办法,这就像开车,你知道了哪些路段容易出事,提前减速慢行,备好备胎,心里就不慌了。

最常遇到也最让人头疼的,就是内存问题,Redis是把所有数据都放在内存里的,所以内存对它来说就是命根子。(参考《Redis设计与实现》中关于内存管理的讨论)内存一旦用满,Redis就开始“闹脾气”了,它会根据你设定的策略(maxmemory-policy)来淘汰一些数据,比如淘汰最近最少使用的键(LRU),或者直接拒绝新的写入请求,要是你的应用没考虑到数据会被淘汰,那可就乱套了,高效稳妥的第一步,就是给Redis的内存设置一个上限,并且选一个符合你业务逻辑的淘汰策略,如果是缓存场景,用LRU淘汰旧数据很合适;但如果有些数据是绝对不能丢的,那可能就得考虑别的方案了,比如扩容,平时呢,得养成习惯,用info memory命令看看内存使用情况,别等快满了才手忙脚乱。

数据持久化也是个大学问,Redis为啥能重启之后不丢数据?全靠持久化。(参考Redis官方文档关于持久化的章节)它主要有两种方式:RDB和AOF,RDB就像是给数据拍个快照,在某个时间点把整个数据库存成一个文件,这个方式恢复起来快,但可能会丢失最后一次快照之后的数据,AOF呢,像是写日记,把每一个写命令都记录下来,这样数据丢失少,但日子久了日记本(AOF文件)会很大,恢复起来也慢,那怎么选?小孩子才做选择,成年人可以都要!通常稳妥的做法是同时开启RDB和AOF,用RDB做定期的完整备份,用AOF来保证数据的安全性,你可以配置AOF每秒同步一次,这样即使宕机,最多也就丢一秒的数据,在大多数业务里这都是可以接受的,记得定期检查AOF文件大小,必要时让Redis重写一下,瘦瘦身。

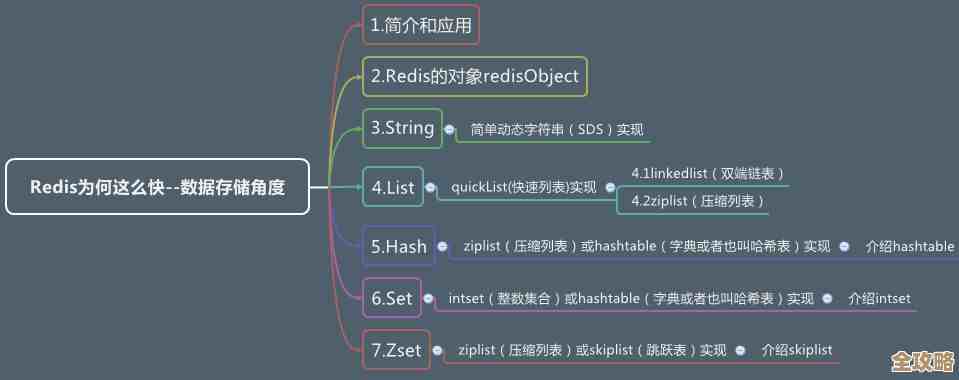

再说说性能问题,Redis本来是以快著称的,但要是用得不小心,也会慢得像蜗牛。(参考博客“Redis Latency Problems Troubleshooting”)一个常见的坑就是使用keys *这种命令,这个命令会遍历所有键,如果数据库里有几百万个键,那这个命令就会直接卡死Redis,让其他请求全都排队等着。绝对不要在生产的Redis上使用keys命令!想查找键,可以用scan命令,它虽然慢一点,但是分批次的,不会阻塞服务,如果发现平时很快的Redis突然变慢了,可以用redis-cli自带的--latency和--latency-history命令来检测一下延迟情况,看看是不是网络问题,或者有没有执行什么慢查询,还有,如果Redis的CPU占用很高,可以看看是不是有 big key(大键),比如一个hash里面存了几十万个字段,操作这种key会很耗资源,尽量把它拆开。

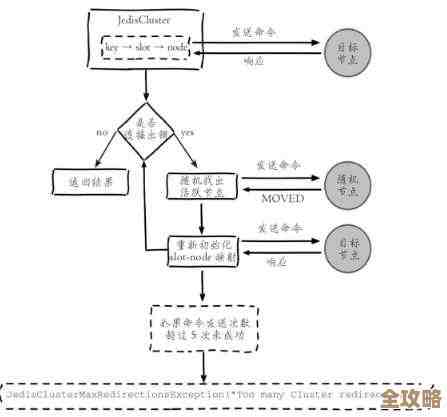

然后是高可用和扩容,单机的Redis万一挂了,整个服务就瘫了,这肯定不行,所以对于重要的业务,搭建一个主从复制(replication)架构是基本操作。(参考《Redis开发与运维》中复制相关的章节)主节点(master)负责写,从节点(slave)负责读和备份,这样既能分担读的压力,主节点挂了还能让从节点顶上去,不过这里有个细节,主从之间的数据同步是异步的,所以可能会有一点点数据不一致的窗口期,如果这都接受不了,那就得上Redis Sentinel(哨兵)或者Redis Cluster(集群)了,哨兵能自动监控主节点,并在它宕机时自动选一个新主节点出来,实现故障自动切换,而集群则主要是为了解决单机内存不够用的问题,能把数据分片存放在多个节点上,上哨兵或集群算是进阶玩法,搭建和运维起来会复杂一些,但为了稳妥,业务量大了之后这是必经之路。

日常的监控和备份是绝对不能省的“笨功夫”。(参考多种运维实践社区经验)光靠人肉盯着肯定不行,得用监控工具(比如Prometheus+Grafana)把Redis的关键指标管起来,比如内存使用率、连接数、命中率、延迟等等,设置好报警阈值,一旦有异常马上就能知道,备份也一样,就算你开了AOF和RDB,也最好定期把持久化文件拷贝到别的机器上,做个冷备,以防万一。

搞定Redis的运维,就是想尽办法让它“别饿着”(内存充足)、“别累着”(避免慢查询和阻塞命令)、“别摔着”(做好持久化和备份)、“别单着”(搭建高可用架构),把这些事儿都想在前面,做在前面,Redis就能成为一个既高效又靠谱的好帮手。

本文由钊智敏于2026-01-18发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/82759.html