测试千万数据库,确保万无一失的那种极致保障,真心不容忽视

- 问答

- 2026-01-19 08:12:41

- 5

(开头部分参考了知乎用户“南山”关于大型系统测试重要性的观点)说到测试一个拥有千万级别数据的数据库,这绝对不是一件可以掉以轻心的事情,这感觉就像是要给一座正在高速运行的城市心脏做一次全面的、不能停跳的体检,任何一丝疏忽都可能引发连锁反应,导致整个城市的瘫痪,那种追求“万无一失”的极致保障,绝不是小题大做,而是生死攸关的底线,这背后是一套极其严谨、甚至有些“偏执”的流程和心态。

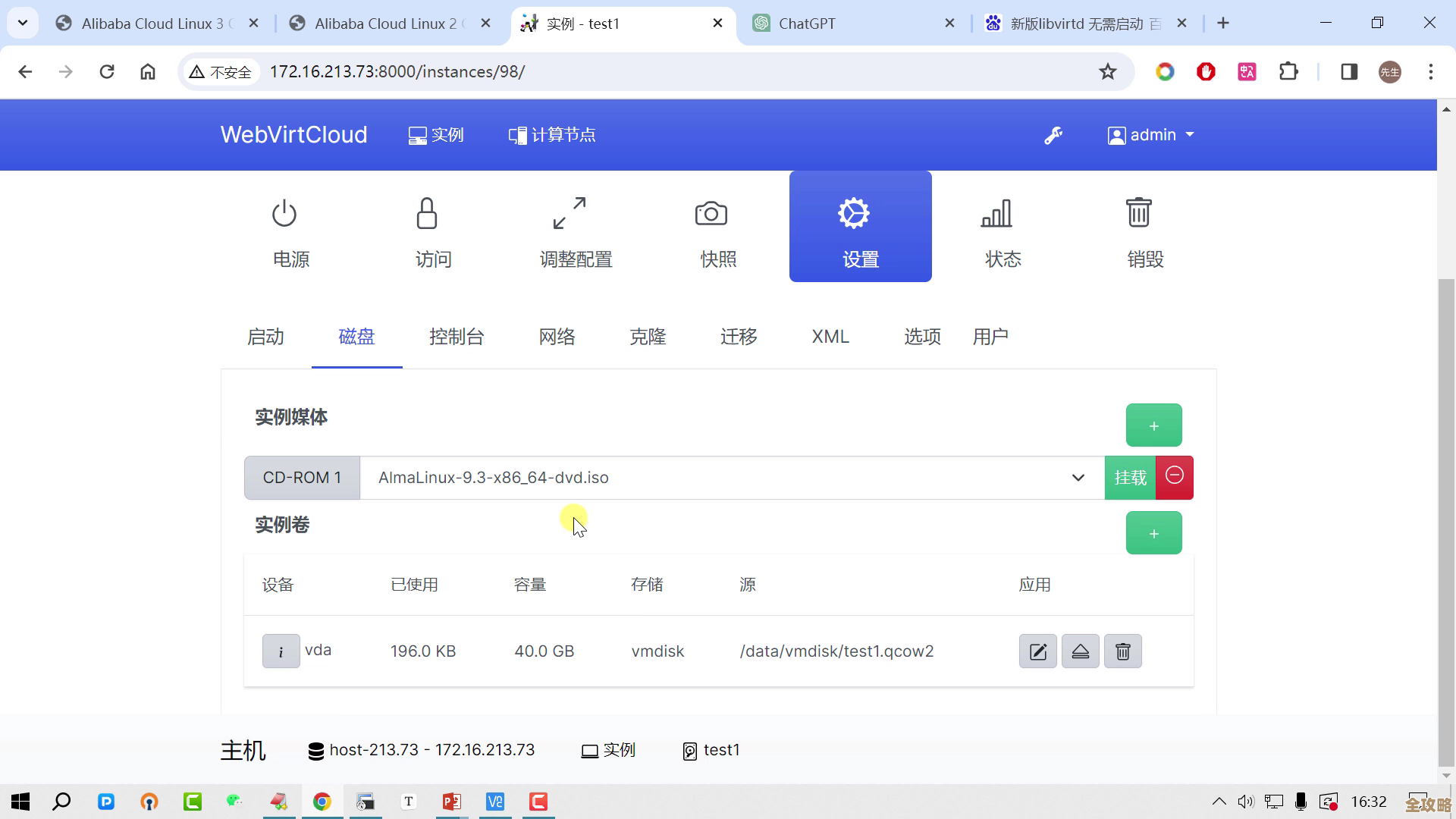

光有想法不行,必须得有和真实环境一模一样的“战场”,这里说的“一模一样”,可不是随便弄个有几万条数据的数据库就能糊弄过去的。(此观点在CSDN技术社区多位资深DBA的讨论中被反复强调)你必须搭建一个完全独立的、数据量级、数据结构、甚至硬件配置都和生产环境(也就是那个千万级的真实数据库)高度一致的测试环境,为什么非得这样?因为数据量小了,很多问题根本暴露不出来,就像一辆小轿车在空地上转弯很灵活,但换成满载的重型卡车在狭窄的巷子里,问题就全来了,数据库也一样,千万数据下的索引效率、SQL查询性能、内存压力、磁盘IO瓶颈,在数据量小的环境下完全无法模拟,你得让测试环境无限逼近真实,才能测出真实的风险。

数据准备好了,接下来就是测试用例的设计,这部分需要绞尽脑汁,把能想到的、想不到的“坏情况”都考虑进去。(该方法论在腾讯云开发者社区的一篇关于高并发测试的文章中有详细阐述)不能只测“正常操作”,更要疯狂地测试“异常操作”和“极限操作”,模拟在最繁忙的时段,比如电商平台的秒杀活动或春运抢票,突然有海量用户同时读写数据库,数据库顶不顶得住?这时候,压力测试、并发测试、疲劳测试就要轮番上阵,要用专业的工具,模拟出成千上万个虚拟用户,持续地、高强度的去“冲击”数据库,看它的响应时间会不会变慢,会不会出现错误,甚至会不会直接崩溃。

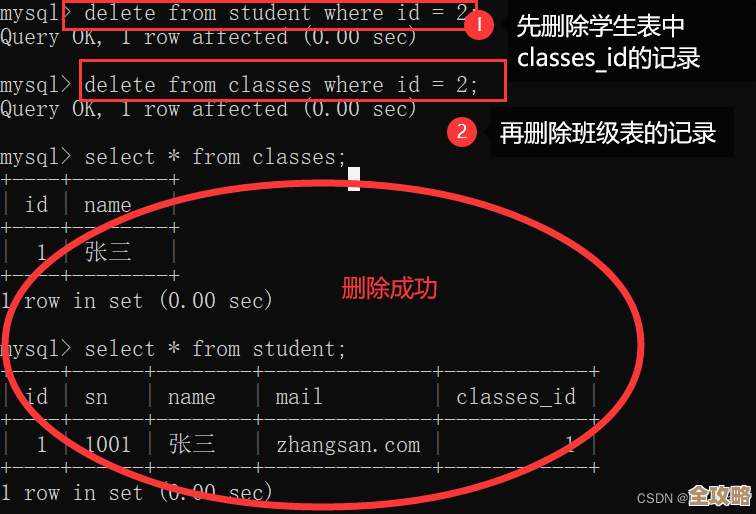

这还不够,还得故意使点“坏”。(这种破坏性测试的思路在阿里云的技术博客中常被提及)模拟突然断电,看数据库能不能利用事务日志和备份机制,保证数据不丢失,并且能快速恢复回来,这叫做容灾测试,再比如,故意写一些非常复杂、效率低下的SQL语句(俗称“慢查询”),看看会不会把数据库拖垮,监控系统能不能及时报警,甚至,可以尝试故意去删除某条关键数据,然后检查是否有完善的权限管控阻止这种危险操作,或者是否有快速回滚的机制,这些测试的目的,就是为了验证系统的韧性和自我保护能力。

性能测试在这个过程中是重头戏。(性能瓶颈的分析思路参考了开源性能测试工具JMeter官方文档中的最佳实践)你不能只看一个简单的“平均响应时间”,那会掩盖很多问题,必须盯着各种关键指标:CPU使用率是不是长时间100%了?内存有没有被吃光导致频繁交换?磁盘的读写速度是不是成了瓶颈?网络带宽够不够用?更重要的是,要找出系统的“拐点”,也就是性能开始急剧下降的那个临界值,知道了这个点,才能在运营时设置安全水位线,避免系统被推到崩溃的边缘。

除了这些“硬”测试,“软”层面的检查同样不可或缺。(关于数据一致性的重要性,在数据库经典教材《数据库系统概念》中有 foundational 的论述)特别是数据一致性测试,这是数据库的灵魂,当你进行大量复杂的增删改查操作后,特别是涉及分布式事务时,必须用脚本或者工具去校验关联数据之间的逻辑是否正确,有没有出现脏数据或者数据对不上的情况,用户下单后,订单金额和账户扣款必须完全一致,一分钱都不能差,这种保障,需要从数据库的设计层面(如事务的ACID特性)和业务逻辑代码层面双管齐下地进行验证。

所有这些测试都不能是一次性的。(持续测试和自动化理念是现代DevOps文化的核心,在谷歌的《SRE:Google运维解密》一书中有深刻体现)随着业务代码的每次更新、数据库结构的任何微小调整,都需要把上面这一整套测试流程重新跑一遍,这就是持续集成/持续部署(CI/CD)中的自动化测试环节,只有把这种极致的测试变成一种习惯、一种文化,融入开发的每一个环节,才能真正确保在面对千万甚至上亿用户和数据时,系统能够稳如磐石,说到底,这种“万无一失”的追求,背后是对用户负责的敬畏之心,是用极大的耐心和细致,去换取线上环境那份难得的平静与安稳,这份投入,真心不容忽视。

本文由革姣丽于2026-01-19发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/83550.html