K8s折腾得我们头大心累,问题一堆还没完没了

- 问答

- 2026-01-24 04:07:44

- 3

【来源:某电商公司运维工程师张工的吐槽】

"我们公司去年跟风上了K8s,本以为能像宣传说的那样轻松管理容器,结果这大半年光折腾这玩意儿了,每天早上打开电脑,心跳就加速,就怕报警群里又刷屏,根本不是想象中那种点几下鼠标就完事的美好状态。"

"光是一个最简单的应用部署,背后就埋着无数坑,光说镜像拉取这事儿,明明测试环境好好的,一到生产环境就报错,不是网络抽风就是权限不足,日志翻得眼睛都快瞎了,有时候同一个配置,今天能跑,明天就趴窝,查来查去也找不到根本原因,只能靠重启大法临时救火,感觉自己像个江湖郎中。"

【来源:某创业公司后端开发团队内部会议记录】

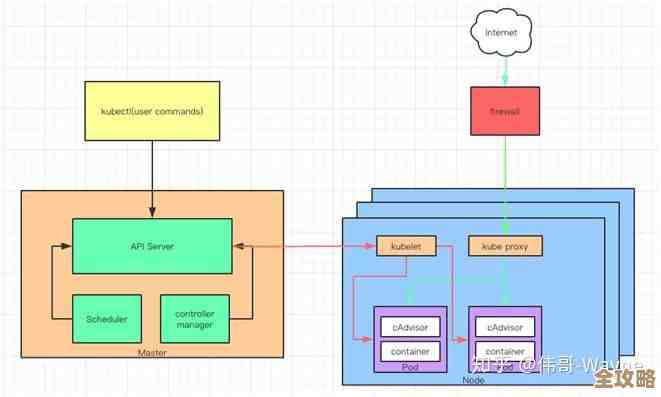

"最让人头大的是那些概念,什么Pod、Service、Ingress、ConfigMap、Secret...名字听着就晕,开发同事想自己部署个测试服务,光看文档就得半天,一不小心yaml文件缩进错了,或者字段名打错个字母,整个部署就失败,报错信息还经常云里雾里,根本不知道从哪儿下手修改。"

"服务发现和网络配置更是玄学,明明感觉配置得跟文档一模一样,但服务之间就是互相访问不通,一会儿是DNS解析有问题,一会儿是网络策略给拦了,为查一个网络问题,运维和开发能对着系统折腾一整天,最后可能发现就是个非常低级的配置疏忽,这种时间成本实在太伤了。"

【来源:某技术社区论坛热帖讨论】

"存储也是个老大难,用本地盘吧,节点一挂数据就丢;用网络存储吧,性能又跟不上,还贵,PVC(持久化存储声明)动不动就绑定失败,或者容量满了不会自动扩容,得人工盯着,有次一个核心服务因为存储空间不足停了半小时,差点酿成线上事故。"

"监控和日志收集也是一言难尽,组件太多,日志分散在各个角落,想追踪一个用户请求的完整链路,得在好几个界面之间来回切换,拼凑线索,自带的监控指标看着多,但真出了性能问题,有用的没几个,还得靠额外装一堆采集器,搞得集群越来越臃肿。"

【来源:某金融科技公司平台部负责人访谈】

"版本升级?那简直是一场噩梦,小版本升级都可能引入兼容性问题,更别说大版本跨越了,官方文档步骤写得再详细,到了自己环境里总能冒出些意想不到的状况,每次升级都得提前几周做预案,全团队严阵以待,在测试环境反复演练,就这还不能保证百分百成功,升级窗口期那几个小时,整个团队的心都悬在嗓子眼。"

"资源管理也没省心到哪儿去,设置了资源限制(Requests/Limits),有的服务动不动就因为内存超标被Kill掉;不设限制吧,又怕某个服务失控把整个节点拖垮,如何精准配置资源成了门玄学,全靠慢慢试错。"

【来源:多位中小团队技术负责人的共同反馈】

"说到底,K8s本身是个为大规模复杂场景设计的重型武器,但很多像我们一样的中小团队,业务根本没那么复杂,用上K8s感觉就像高射炮打蚊子,为了用而用,反而引入了远超预期的复杂性和维护成本,运维团队疲于奔命,天天在处理K8s平台自身的问题,而不是专注在业务价值上,招个熟手又贵又难,团队学习曲线极其陡峭。"

"感觉我们不是在驾驭技术,而是被技术绑架了,很多问题看似解决了,但根本原因摸不透,过段时间换个花样又冒出来,真的有种没完没了的感觉,现在团队里一提起K8s,大家的表情都很复杂,可以说是‘又爱又恨’,但更多的时候是‘心累’。"

本文由召安青于2026-01-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/84864.html