Redis集群里缓存数据一致性问题探讨和那些坑点分析

- 问答

- 2025-12-26 07:49:14

- 4

主要参考了多位资深开发者在技术社区如CSDN、博客园、掘金等平台分享的实战经验总结,以及《Redis设计与实现》等书籍中的相关概念)

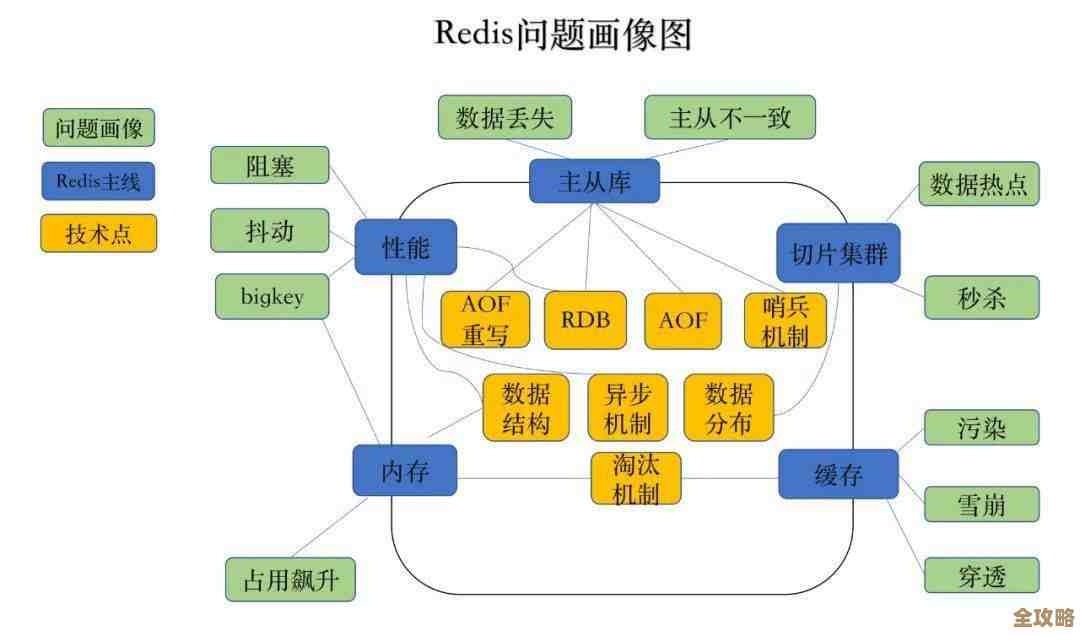

Redis集群在现代应用中被广泛用作缓存层,它的核心目标是提升系统的读取性能和应对高并发访问,一旦涉及到数据的更新,一个非常棘手的问题就会出现:如何保证Redis中缓存的数据与后端数据库(如MySQL)中的数据保持一致,这个问题如果处理不好,轻则导致用户看到过时的旧数据,重则引发严重的业务逻辑错误,下面我们就来直接探讨这些问题和常见的坑点。

核心问题:为什么会产生不一致?

不一致的根本原因在于,我们引入了“缓存”这个额外的数据层,同一份数据有两个存放地点:数据库和Redis,当你需要更新数据时,理想情况是两边同时更新成功,但现实中的网络延迟、服务宕机、并发操作等都可能导致两边更新不同步。

最常见的场景是“先更新数据库,再删除缓存”,这个策略看起来很合理,但隐藏着坑点,假设在某个时刻,缓存恰好失效了(或者被LRU淘汰了),这时一个请求A来读取数据,发现缓存为空,于是它去数据库读取旧值,并准备将这个旧值写入缓存,就在这个极短的时间内,另一个请求B来更新数据:它先成功更新了数据库,然后执行删除缓存的操作,如果删除缓存的操作在请求A将旧值写入缓存之后才完成,那么缓存里存的依然是旧数据,而数据库是新数据,后续的所有读请求都会读到这个脏数据,直到缓存下次过期或被更新,这就是一个典型的因操作时序问题导致的不一致。

常见的坑点分析

-

“双写”策略的陷阱:有些开发者会采用“先更新缓存,再更新数据库”或者两者同时更新的策略,这比“先更新数据库再删缓存”更危险,如果先更新缓存成功,但更新数据库失败了,那么缓存里的数据就是“的、数据库中根本不存在的脏数据,影响会非常严重,同样,由于网络延迟,两个更新操作的完成顺序可能错乱,导致最终缓存和数据库的数据对不上。

-

删除缓存失败的重试问题:在“先更新数据库,再删除缓存”策略中,删除缓存这一步不是绝对可靠的,可能会因为网络抖动、Redis节点临时不可用等原因导致删除失败,如果删除失败后没有重试机制,那么缓存就会一直保持旧数据,必须引入重试机制,但重试本身也是个坑,简单的在代码里循环重试可能会阻塞当前请求,影响性能,一个更好的做法是将失败的操作抛到一个消息队列里,由专门的后台任务进行异步重试,直到成功为止。

-

数据库主从延迟带来的坑:在大型系统中,数据库通常采用“主从架构”,写操作发生在主库,读操作可能发生在从库,主库的数据同步到从库需要时间,这就会产生主从延迟,如果你在更新主库后立刻删除了缓存,紧接着一个读请求到来,这个请求可能被路由到一个数据尚未同步完成的从库上,读到的依然是旧数据,然后这个旧数据又被塞回了缓存,导致不一致,解决这个问题的办法可以是“延迟双删”,即在更新数据库并首次删除缓存后,隔几百毫秒到一秒再次删除一次缓存,以确保读请求在从库读到旧数据并写入缓存后,能再次被清除。

-

热点数据并发重建的坑:当某个热点缓存key过期失效的瞬间,可能会有大量并发请求同时涌来,大家都发现缓存没了,于是都去查询数据库,并试图将结果写入Redis,这个过程会给数据库带来巨大压力,也就是常说的“缓存击穿”,更麻烦的是,如果网络或处理稍有时序差异,这些并发请求可能会用查询到的(可能是相同的)数据多次覆盖缓存,虽然数据本身可能没错,但造成了不必要的资源浪费和潜在的数据覆盖风险,解决方法是使用Redis的

setnx命令实现互斥锁,只允许一个请求去数据库查询和重建缓存,其他请求等待。 -

对不一致的容忍度认知不清:这是最大的一个“认知坑”,不是所有业务场景都要求绝对的、实时的一致性,一个商品的点赞数、文章的阅读量,晚几秒钟更新到缓存中被用户看到,通常是可接受的,这种场景下,甚至可以给缓存设置一个较短的过期时间,允许存在短暂的不一致,通过过期后重新加载来自动纠正,这样可以简化系统设计,提升性能,而像商品库存、秒杀扣款这类场景,则对一致性要求极高,技术方案的选择必须基于具体的业务需求,不能一味追求强一致性而牺牲了系统的可用性和简单性。

总结一下

处理Redis集群的缓存一致性问题,没有一劳永逸的“银弹”,它是在性能、一致性和系统复杂度之间的一场权衡,常用的“先更新数据库,再删除缓存”配合消息队列异步重试和应对主从延迟的延迟删除,是一个相对稳健的方案,但更重要的是,开发者必须深刻理解自己业务的容忍度,清晰地认识到每一个操作步骤可能失败的场景和由此带来的后果,并针对性地设计补偿和容错机制,才能有效地避开这些坑。

本文由水靖荷于2025-12-26发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/wenda/68665.html