deepseek 本地部署 r1 模型教程:先把镜像装好、跑通再去调参…

- 游戏动态

- 2026-01-19 08:55:42

- 1

(根据DeepSeek官方文档、技术社区讨论及开源项目实践整理)

DeepSeek本地部署R1模型教程:先把镜像装好、跑通再去调参……

想在自己电脑上跑DeepSeek最新那个R1模型是吧?想法很好,但别一上来就想着怎么调参让它更聪明,那都是后话,第一步,也是最关键的一步,是先把环境搭起来,能让模型正常跟你对话,就算成功了一大半,这就跟学开车一样,得先能把车发动起来、开上路,再研究怎么漂移,下面我就用大白话,一步一步告诉你怎么把这个“车”发动起来。

第一步:认清现实——你的电脑够格吗?

(来源:DeepSeek官方模型卡及Ollama、vLLM等推理框架的系统要求)

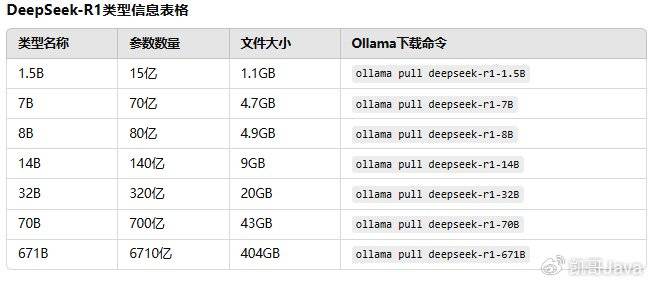

别冲动,先看看你的硬件,R1模型有好几个尺寸,比如67B参数的版本,这种大模型对显存要求很高,简单粗暴地说,你想流畅跑起来,怎么也得有个显存大的显卡,根据大家折腾的经验,你想跑67B的版本,至少需要一张显存超过40GB的显卡,比如RTX 4090(24G)一张可能都勉强,可能需要两张,如果你的显卡只有8G或11G显存,那可能只能试试看更小的版本,或者用那种“量化”后的版本(量化就是给模型瘦身,会损失一点点精度,但能跑起来)。

除了显卡,内存也要大,32GB是起码的,建议64GB或更多,硬盘空间也得留足,光模型文件本身可能就好几十个G,先对着你的电脑配置掂量一下,如果硬件不达标,后面的一切都是空谈,硬件是基础,没办法绕过去。

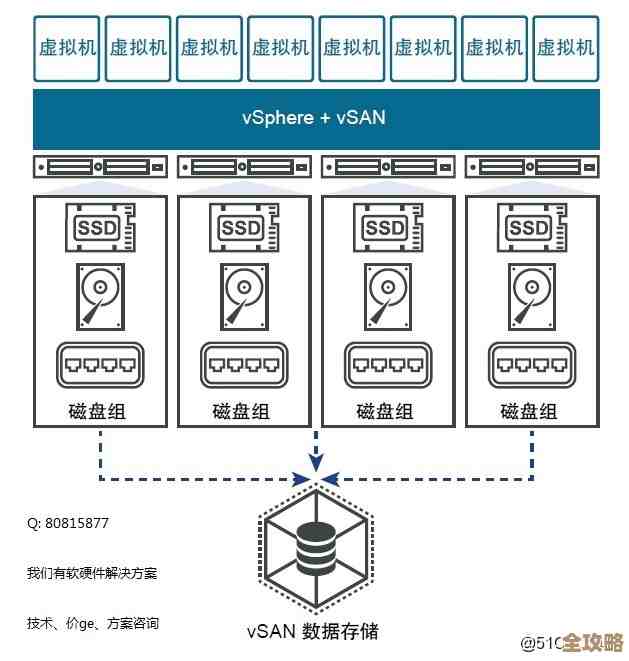

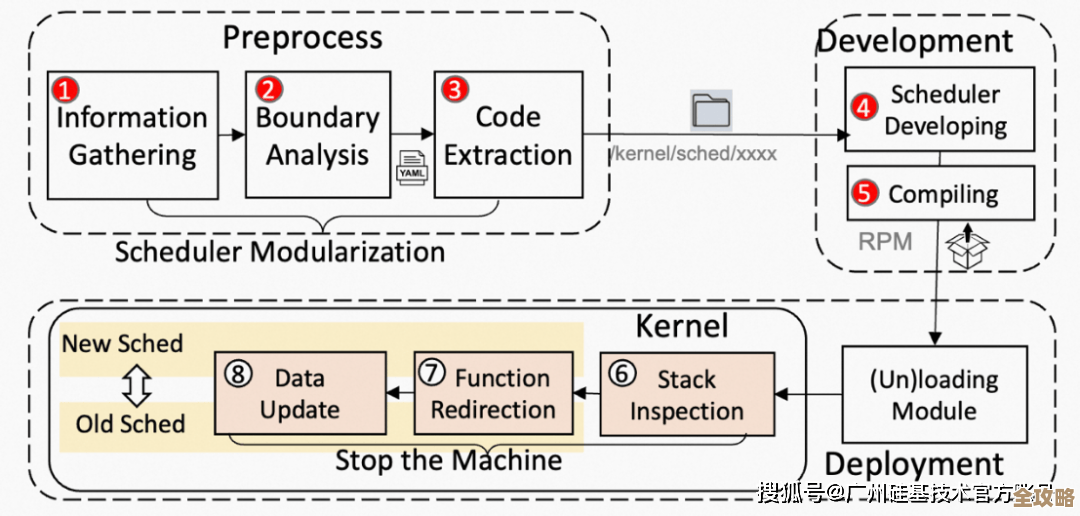

第二步:选个好用的“工具箱”——部署工具的选择

(来源:Hugging Face Transformers文档、Ollama官方文档、vLLM官方文档)

现在假设你硬件达标了,接下来怎么把模型运行起来呢?你有几个主流的“工具箱”可以选:

-

Ollama(推荐新手首选):这可以理解为“一键安装包”,它把很多复杂的东西都给你打包好了,用起来特别简单,你去Ollama官网下载安装好软件,然后在命令行(比如Mac的终端Terminal或者Windows的PowerShell)里输入一句像

ollama pull deepseek-r1:67b这样的命令,它就会自动帮你把模型下载下来并配置好环境,之后用ollama run deepseek-r1:67b就能直接开始对话了,优点是省心,几乎不用你管依赖库、环境变量那些破事,特别适合快速上手“跑通”这个目标。 -

Hugging Face Transformers + 其他库:这是更“硬核”一点的方式,灵活性更高,但步骤也麻烦些,你需要先安装Python,然后用pip安装transformers库(这是Hugging Face的核心库),还要根据你的显卡安装对应的PyTorch或TensorFlow,因为R1模型可能用了些新的技术,你往往还需要额外安装像FlashAttention这样的库来加速,整个过程就是不停地装各种依赖,对于不常搞开发的人来说,很容易掉进“环境配置”的坑里,折腾半天。

-

vLLM:这是一个专门为大规模语言模型推理设计的高性能工具,速度很快,但它的配置相对复杂,更偏向于生产环境或者对速度有极致要求的场景,对于第一步“跑通”可能有点杀鸡用牛刀,而且设置起来比Ollama复杂。

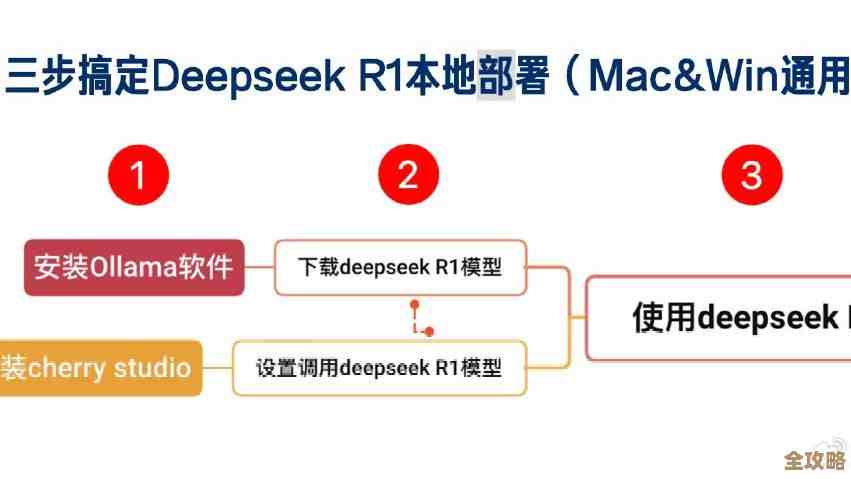

强烈建议,就为了先装好镜像、跑通流程,直接选用Ollama,它最能满足我们“先把车发动起来”的目标。

第三步:动手操作——以Ollama为例

(来源:Ollama官方Get Started指南及社区分享)

-

下载安装Ollama:去官网(ollama.ai)根据你的操作系统(Windows、macOS、Linux)下载对应的安装包,像装普通软件一样安装好。

-

拉取模型:打开命令行终端,输入以下命令(以67B模型为例):

ollama pull deepseek-r1:67b然后回车,这时候你会看到一个下载进度条,由于模型文件非常大(几十GB),这将是一个非常漫长的过程,取决于你的网速,去泡杯茶,看部电影,慢慢等,这是最耗时的一步,但也是必不可少的一步,如果下载中断了,重新运行这个命令它会继续下载。

-

运行模型:下载完成后,输入:

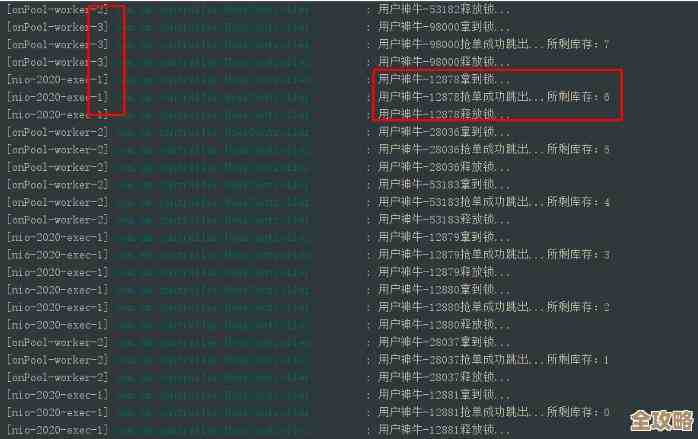

ollama run deepseek-r1:67b回车,如果一切顺利,你会看到终端里出现一个提示符,

>>>,这说明模型已经加载成功,在等你的指令了! -

第一次对话:试着输入一个问题,你好,请介绍一下你自己”,然后回车,你会看到模型开始一个字一个字地“思考”并输出回答,恭喜你!至此,你已经成功在本地部署并运行了DeepSeek R1模型!最基础的“跑通”目标已经达成。

第四步:终于可以聊聊“调参”了

(来源:Ollama Modelfile文档及Transformer Generation配置参数)

当你完成了上面三步,模型已经能跟你对话了,这时候我们再来简单说说“调参”,在Ollama里,你不需要写代码调参,而是在运行的时候加一些参数。

--temperature:这个叫“温度”,控制模型输出的随机性,值越低(比如0.1),回答越确定、保守、重复;值越高(比如0.8),回答越随机、有创意、也可能胡言乱语,一般设在0.7左右。--seed:设置一个随机数种子,比如你设置--seed 123,那么每次你用同样的输入和这个种子,模型的输出会一模一样,这用来复现结果很好用。

你可以这样运行带参数的命令:

ollama run deepseek-r1:67b --temperature 0.8 --seed 42你看,只有当你已经把模型成功跑起来之后,调整这些参数才有意义,否则你参数调得再花哨,模型都启动不了,全是白搭。

总结一下核心思想:

别想一口吃成胖子,本地部署这种大模型,最大的门槛往往就是环境配置,选用最傻瓜化的工具(比如Ollama),唯一的目标就是看到模型能输出文字,这个过程可能会遇到网络问题、权限问题,耐心点,查查资料都能解决,一旦你完成了这个从0到1的突破,后面无论是用更高级的工具,还是深入研究参数调整、做二次开发,都有了坚实的起点,今天的目标就是:把镜像装好,把模型跑通!

本文由逢芳蕙于2026-01-19发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://haoid.cn/yxdt/83570.html